DeepSeek R1由中国人工智能公司 DeepSeek 开发的一种新的开源人工智能语言模型现在很流行。

一些用户称,就推理能力而言,它与 OpenAI 的 o1 不相上下,甚至更强。

目前,DeepSeek 是免费的,这对用户来说是个好消息,但也带来了一些问题。

随着用户数量的增加,他们将如何处理服务器的成本?运行模型的硬件应该不便宜吧?

一个合理的猜测是数据。

数据是人工智能模型的生命线。它们可能会以某种方式收集用户数据,这些数据可能对其交易模型或其他形式的货币化有用。

如果您担心数据隐私,但又想在不共享数据的情况下使用 R1,最好的选择是在本地运行模型。

什么是 DeepSeek R1?

几天前,DeepSeek R1 以完全开源的模式问世。这意味着任何人都可以访问其底层代码,进行修改,甚至根据自己的需要对其进行微调。

DeepSeek R1(通常缩写为 R1)源自一个名为 DeepSeek-V3 的大型基础模型。

研究团队通过将监督微调(SFT)与高质量人工标注数据和强化学习(RL)相结合,对该模型进行了优化。

这使得聊天机器人可以处理复杂的提示,显示复杂问题背后的原因(有时比其他模型更清晰),甚至可以在聊天界面中显示代码以进行快速测试。

这确实令人印象深刻,尤其是对于开源模式而言。

如何在本地运行 DeepSeek R1

至 本地运行 DeepSeek R1我们将使用一个名为 Ollama 的工具。

Ollama 是一款免费开源工具,允许用户在本地计算机上运行大型语言模型 (LLM)。

访问 Ollama 官方网站,点击 "下载 "按钮,然后将其安装到系统上。

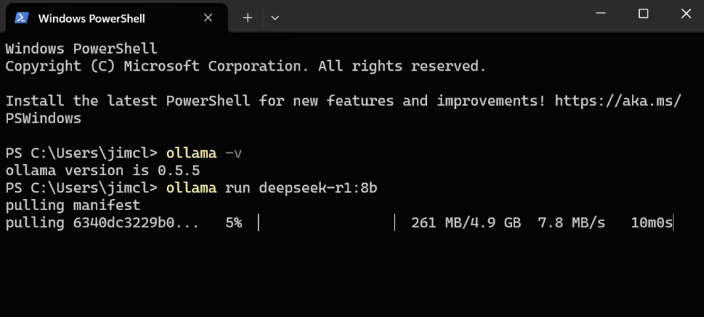

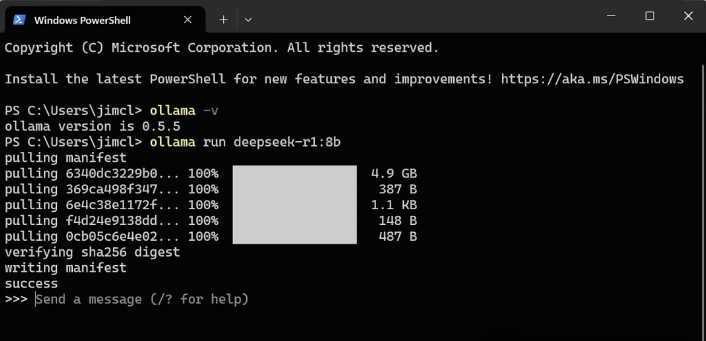

确认安装成功、

打开终端并运行以下命令: ollama -v

你应该看到 Ollama 的版本号,而不是错误信息。

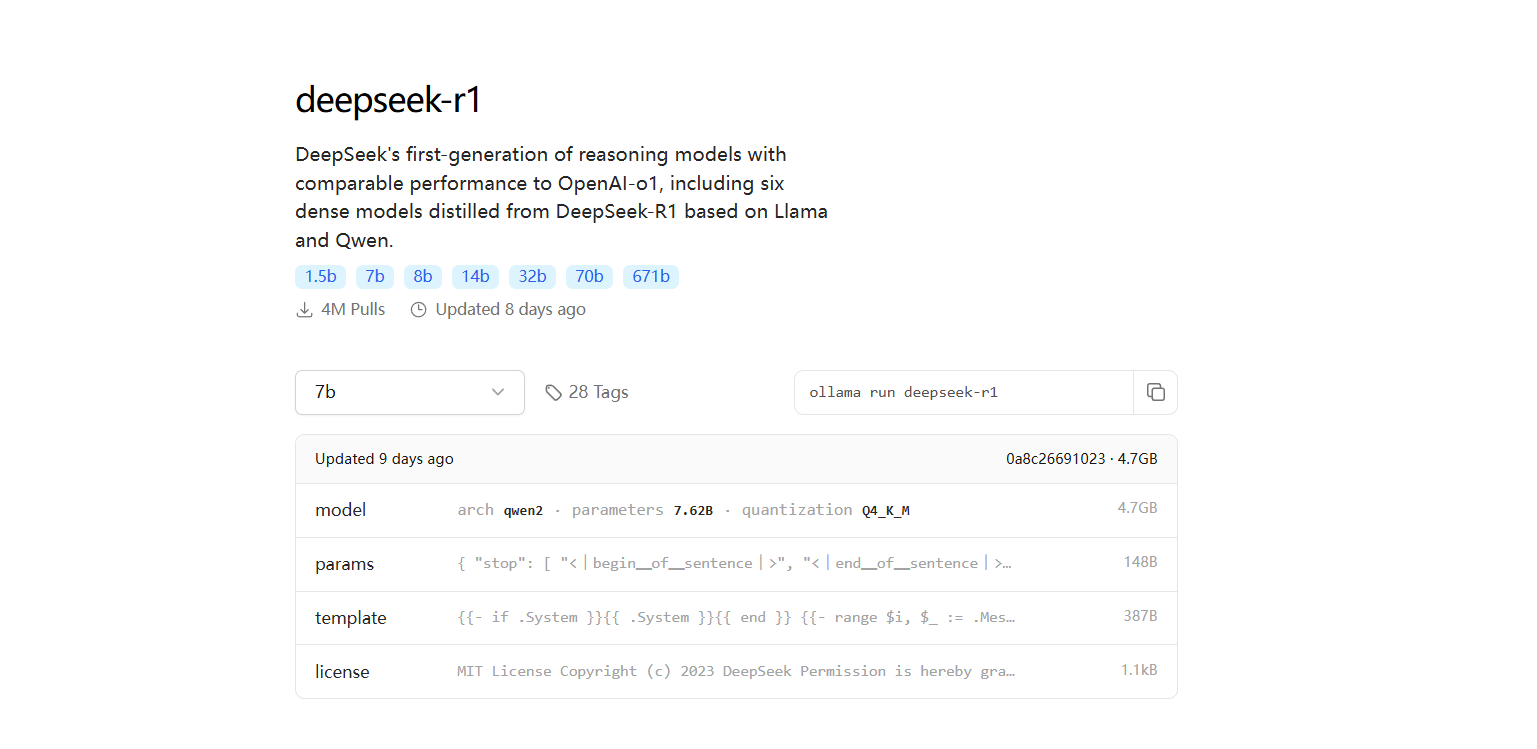

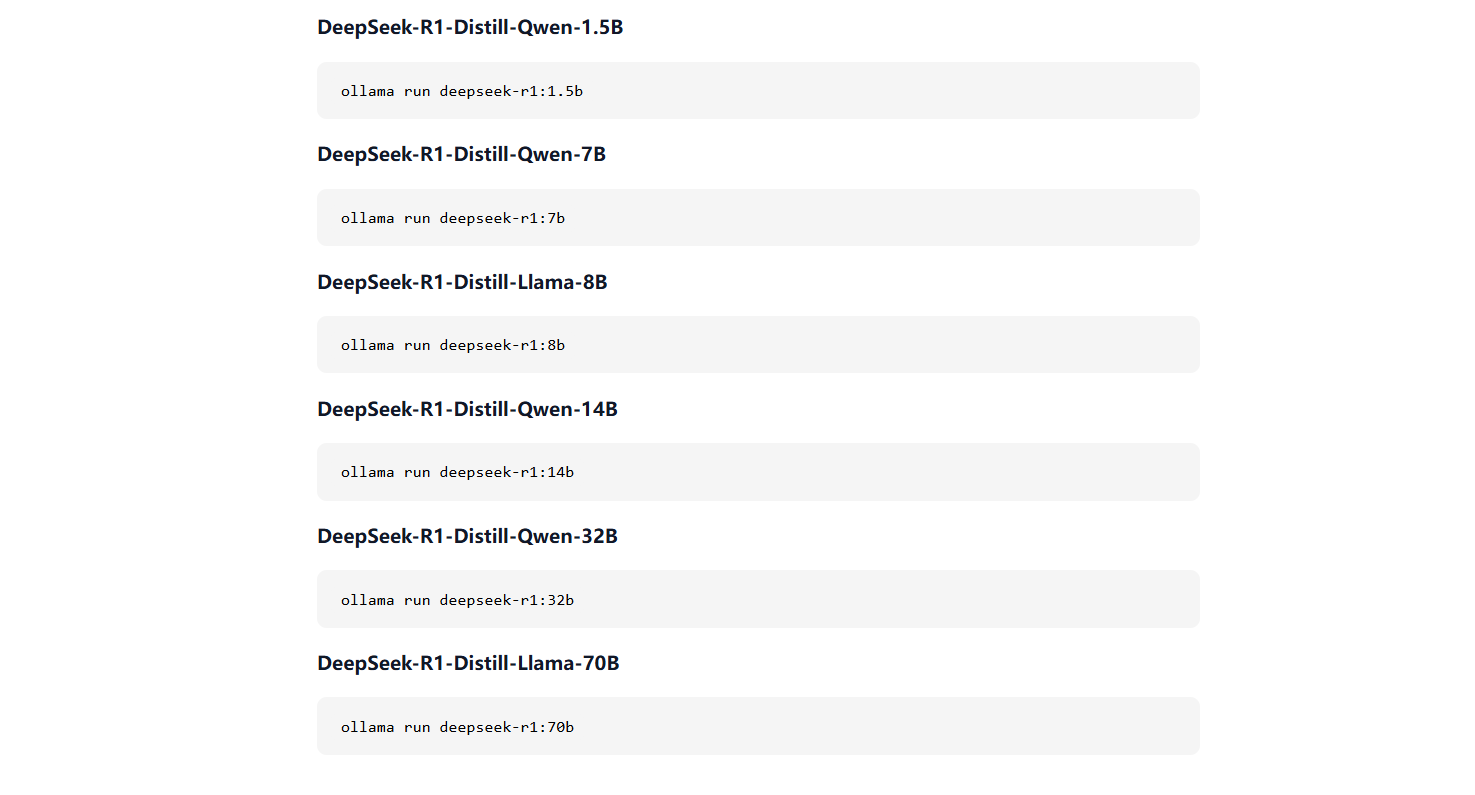

在 "机型 "选项卡下,搜索关键词 "deepseek",你会在列表顶部看到 "deepseek-r1"。

点击它,在 "模型 "部分,你会看到有多种模型大小,参数从 50 亿到 6710 亿不等。

像 80 亿参数版本这样的小型模型可以在配备 8 GB 显存的 GPU 上运行,而大型模型则需要更多的资源(请参阅下文有关显存和 GPU 要求的部分)。

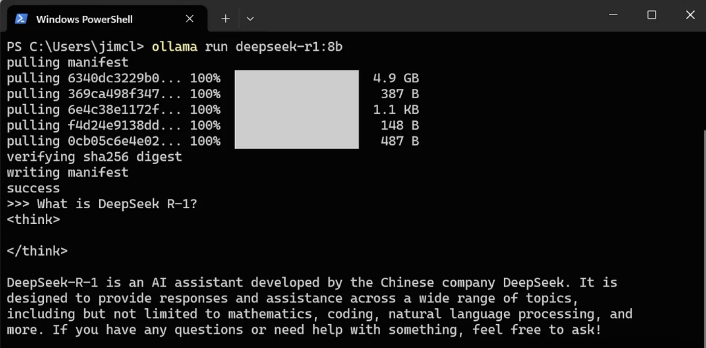

要下载并运行 80 亿参数模型,请使用以下命令:ollama run deepseek-r1:8b

模型将开始下载(约 4.9 GB)。继续下载前,请确保您有足够的磁盘空间。

下载完成后,模型将在本地计算机上运行,您可以立即与它开始对话。

让我们用一个提示样本来测试一下:

提示: 什么是 DeepSeek R-1?

回应:DeepSeek R-1 是中国 DeepSeek 公司开发的一款人工智能助手。

它旨在提供各种主题的答案和帮助,包括但不限于数学、编程、自然语言处理等。如果您有任何问题或需要帮助,请随时向我咨询!

好极了

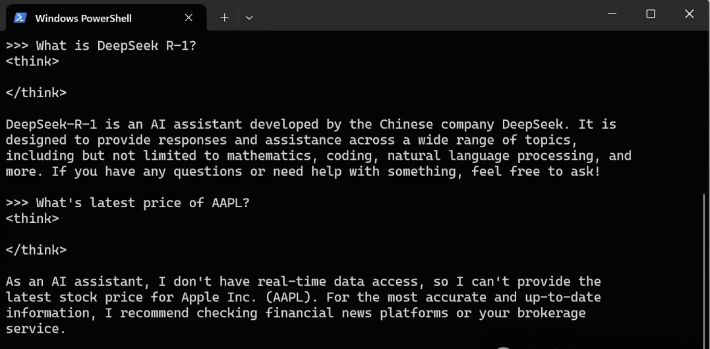

它速度很快,即使我将笔记本电脑从 Wi-Fi 网络断开也能正常工作。请注意,即使您连接了它,它也无法访问互联网。

提示:AAPL 的最新股价是多少?

回复:作为人工智能助手,我无法访问实时数据,因此无法提供苹果公司 (AAPL) 的最新股价。

要想获得最准确的最新信息,我建议您查看财经新闻平台或您的经纪服务:

本地运行 LLM,包括 LLaMA2、Phi 4、Mistral 和 Gemma 2允许用户创建和共享自己的 LLM将模型权重、配置和数据打包成一个单一的包优化设置和配置细节,包括 GPU 的使用。

GPU 和内存要求

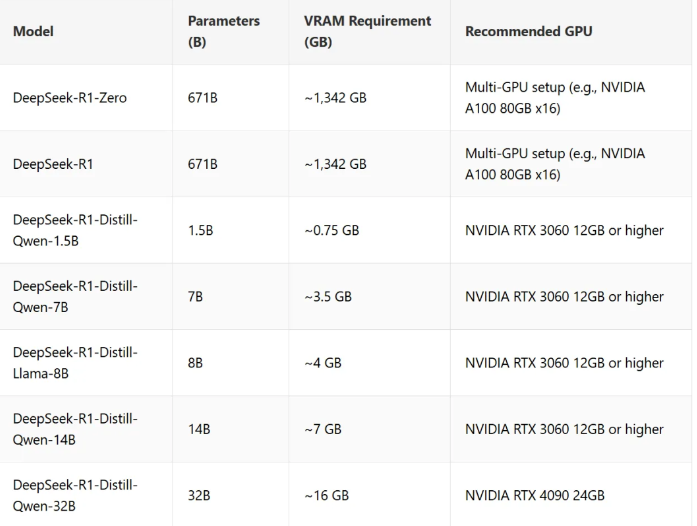

DeepSeek-R1 的内存需求取决于模型大小、参数数量和量化技术等因素。

以下是 DeepSeek-R1 及其缩小模型的内存需求以及推荐 GPU 的详细概述:

内存使用要点

大型模型的分布式 GPU 设置:DeepSeek-R1-Zero和DeepSeek-R1需要大量显存,因此需要分布式GPU配置(如多GPU配置中的NVIDIA A100或H100)以获得最佳性能。

精简版机型经过优化,可在单 GPU 上运行,图形内存要求较低,从 0.7 GB 起。

额外的内存使用:激活、缓冲区和批处理任务可能会消耗额外内存。

为什么要在本地运行?

DeepSeek 的网络聊天机器人和手机应用都是免费的,而且非常方便。您无需进行任何设置,DeepThink 和网络搜索等功能均已内置。

不过,在本地运行可能是更好的选择,原因如下

隐私权

当您使用网页版或应用程序版时,您的查询和任何附加文件都会被发送到DeepSeek的服务器进行处理。

离线访问

在本地运行模型意味着不需要互联网连接。

如果你正在旅行,遇到Wi-Fi不稳定的情况,或者只是喜欢离线工作,本地设置允许你随时随地使用DeepSeek。

面向未来

目前,DeepSeek 的服务是免费的,但这不可能永远持续下去。在某些时候,它们可能需要货币化,可能会出现使用限制或订阅费用。通过本地模式,您可以完全避免这些限制。

灵活

有了本地版本,您就不会受到默认设置的限制。想对模型进行微调?

与其他工具集成?DeepSeek R1的开源特性为您提供了无限可能。

摘要

目前还不清楚 DeepSeek 如何处理用户数据。

如果你不在乎数据隐私,使用网络或移动应用程序可能是更好的选择。它们更易于使用,并提供 DeepThink 和网络搜索等功能。

但如果你关心数据的去向,本地模式是一个值得考虑的好选择。

DeepSeek 模型的设计目的是即使在功能不是特别强大的硬件上也能很好地运行。

像 DeepSeek-R1-Zero 这样的大型模型需要分布式 GPU 设置,而精简版则可以在单 GPU 上以较低的内存要求顺利运行。