DeepSeek R1, un nuovo modello linguistico di intelligenza artificiale open-source sviluppato dall'azienda cinese DeepSeek, è molto popolare in questo momento.

Alcuni utenti sostengono che sia paragonabile o addirittura più forte di o1 di OpenAI in termini di capacità di inferenza.

Attualmente DeepSeek è gratuito, il che è una buona notizia per gli utenti, ma solleva anche alcune domande.

Come gestiranno il costo del server man mano che il numero di utenti aumenta? L'hardware che gestisce il modello non dovrebbe essere economico, giusto?

Un'ipotesi ragionevole è quella dei dati.

I dati sono la linfa vitale dei modelli di IA, che possono raccogliere in qualche modo i dati degli utenti, utili per i loro modelli di trading o per altre forme di monetizzazione.

Se siete preoccupati per la privacy dei dati ma volete comunque utilizzare R1 senza condividere i dati, la soluzione migliore è eseguire il modello in locale.

Che cosa è DeepSeek R1?

Qualche giorno fa, DeepSeek R1 è stato presentato come modello completamente open source. Ciò significa che chiunque può accedere al suo codice sottostante, apportare modifiche e persino perfezionarlo in base alle proprie esigenze.

DeepSeek R1 (spesso abbreviato in R1) deriva da un grande modello di base chiamato DeepSeek-V3.

Il team di ricerca ha ottimizzato questo modello combinando la messa a punto supervisionata (SFT) con dati di alta qualità annotati manualmente e l'apprendimento per rinforzo (RL).

Il risultato è un chatbot in grado di gestire richieste complesse, di mostrare il ragionamento che sta dietro a domande complesse (a volte in modo più chiaro rispetto ad altri modelli) e persino di presentare il codice nell'interfaccia della chat per una rapida verifica.

È davvero impressionante, soprattutto per un modello open-source.

Come eseguire DeepSeek R1 in locale

A eseguire DeepSeek R1 localmenteutilizzeremo uno strumento chiamato Ollama.

Ollama è uno strumento gratuito e open source che consente agli utenti di eseguire modelli linguistici di grandi dimensioni (LLM) localmente sul proprio computer.

È disponibile per macOS, Linux e Windows. Visitate il sito ufficiale di Ollama, fate clic sul pulsante "Download" e installatelo sul vostro sistema.

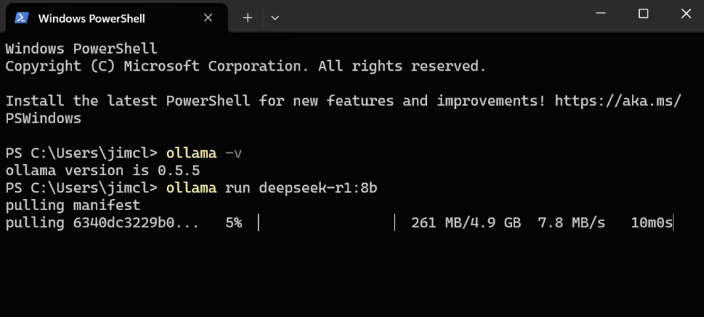

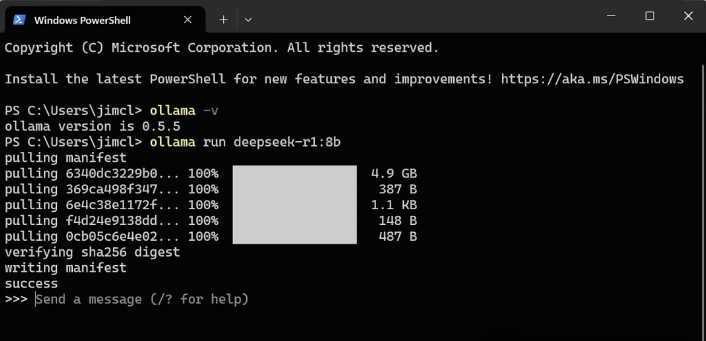

Per confermare la riuscita dell'installazione,

aprire un terminale ed eseguire il seguente comando: ollama -v

Dovrebbe essere visualizzato il numero di versione di Ollama invece di un messaggio di errore.

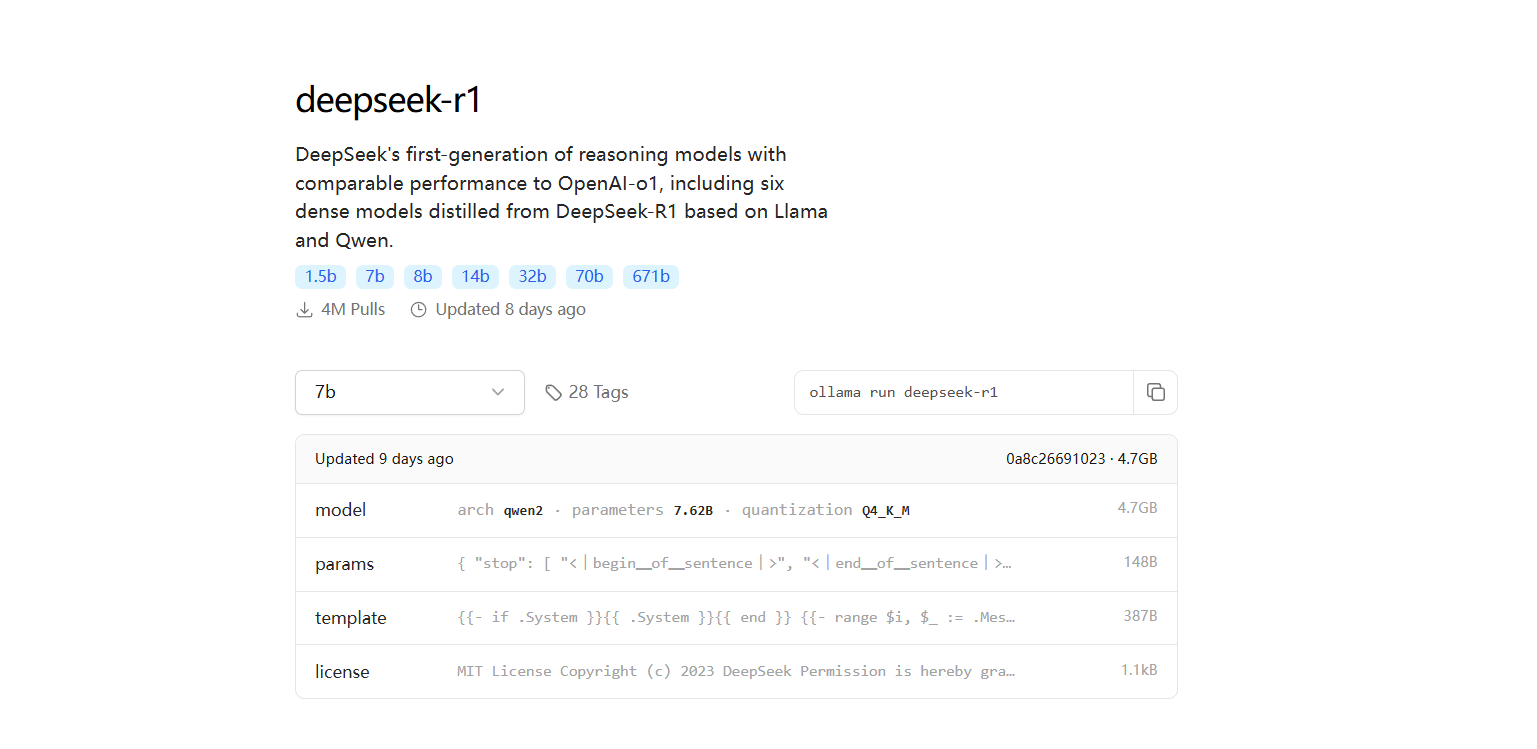

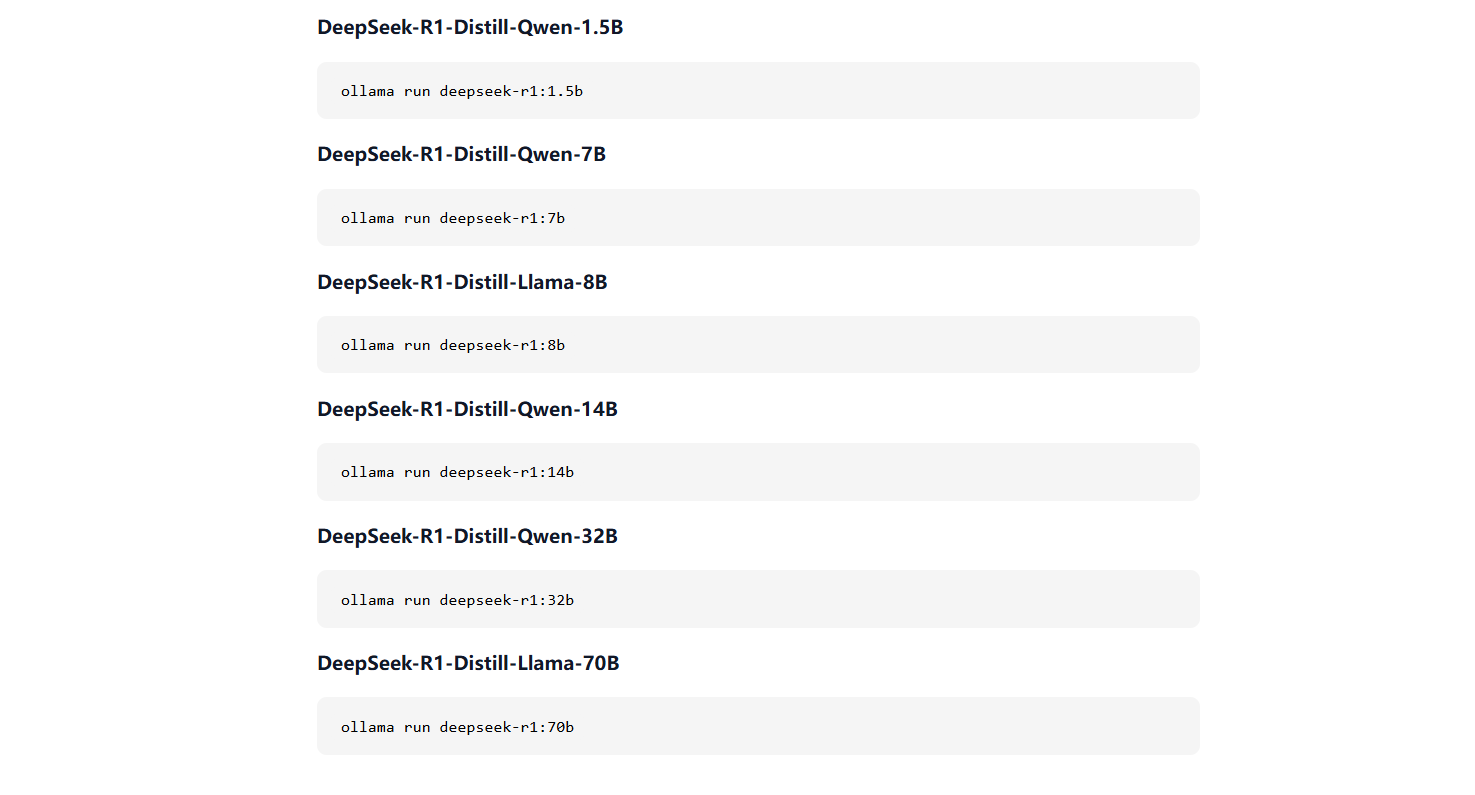

Nella scheda "Modelli", cercate la parola chiave "deepseek" e dovreste vedere "deepseek-r1" in cima all'elenco.

Facendo clic su di esso, nella sezione "Modelli", si noterà che ci sono modelli di diverse dimensioni con parametri che vanno da 5 miliardi a 671 miliardi. Come regola generale, i modelli più grandi richiedono GPU più potenti per essere eseguiti.

Un modello di piccole dimensioni, come la versione da 8 miliardi di parametri, può essere eseguito su una GPU con 8 GB di memoria grafica, mentre i modelli più grandi richiedono risorse significativamente maggiori (si veda la sezione seguente sui requisiti della memoria grafica e della GPU).

Per scaricare ed eseguire il modello a 8 miliardi di parametri, utilizzare il seguente comando:ollama run deepseek-r1:8b

Il modello inizierà a essere scaricato (circa 4,9 GB). Prima di procedere, assicurarsi di disporre di spazio sufficiente sul disco.

Una volta completato il download, il modello verrà eseguito sul computer locale e sarà possibile avviare immediatamente una conversazione con esso.

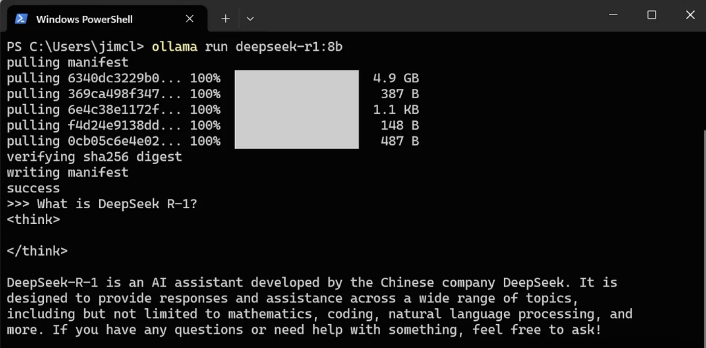

Verifichiamo questo con un prompt di esempio:

Prompt: Che cos'è DeepSeek R-1?

Risposta: DeepSeek R-1 è un assistente AI sviluppato dall'azienda cinese DeepSeek.

È stato progettato per fornire risposte e aiuto su una varietà di argomenti, tra cui, ma non solo, la matematica, la programmazione, l'elaborazione del linguaggio naturale, ecc. Se avete domande o bisogno di aiuto, non esitate a chiedermelo!

Ottimo.

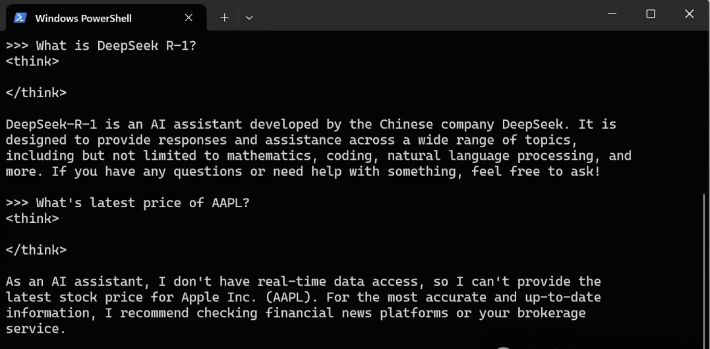

È veloce e funziona anche quando scollego il portatile dalla rete Wi-Fi. Si noti che non può accedere a Internet anche se si è connessi.

Suggerimento: qual è l'ultimo prezzo delle azioni di AAPL?

Risposta: In qualità di assistente AI, non posso accedere ai dati in tempo reale e quindi non posso fornire l'ultimo prezzo delle azioni di Apple Inc.

Per ottenere informazioni più precise e aggiornate, vi suggerisco di consultare le piattaforme di notizie finanziarie o i vostri servizi di intermediazione:

Esecuzione di LLM in locale, compresi LLaMA2, Phi 4, Mistral e Gemma 2Consentire agli utenti di creare e condividere i propri LLMImpacchettare i pesi, le configurazioni e i dati del modello in un unico pacchettoOttimizzare le impostazioni e i dettagli della configurazione, compreso l'uso della GPU.

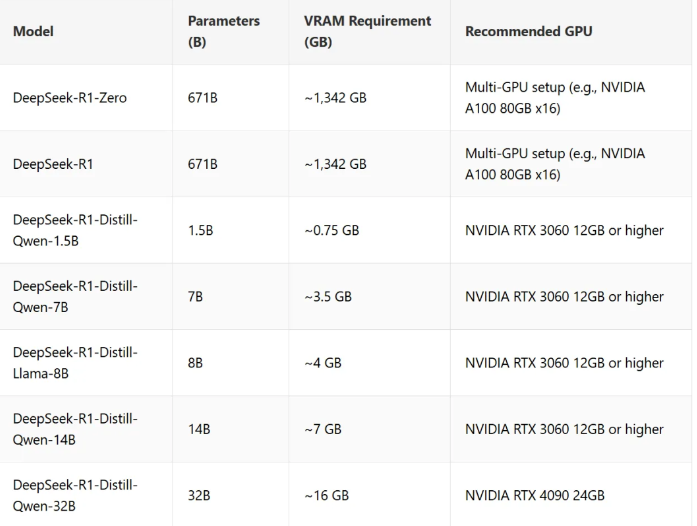

Requisiti di GPU e memoria

I requisiti di memoria per DeepSeek-R1 dipendono da fattori quali la dimensione del modello, il numero di parametri e la tecnica di quantizzazione.

Ecco una panoramica dettagliata dei requisiti di memoria per DeepSeek-R1 e il suo modello ridotto, oltre alle GPU consigliate:

Nota chiave sull'utilizzo della memoria:

Configurazione GPU distribuita per modelli di grandi dimensioni: DeepSeek-R1-Zero e DeepSeek-R1 richiedono molta memoria grafica e quindi una configurazione di GPU distribuita (ad esempio NVIDIA A100 o H100 in una configurazione multi-GPU) per ottenere prestazioni ottimali.

I modelli Lite sono ottimizzati per funzionare su una singola GPU con requisiti di memoria grafica inferiori, a partire da 0,7 GB.

Utilizzo di memoria aggiuntiva: L'attivazione, i buffer e le attività batch possono consumare memoria aggiuntiva.

Perché eseguire il lavoro in locale?

Il chatbot web e l'applicazione mobile di DeepSeek sono gratuiti e molto convenienti. Non è necessario effettuare alcuna configurazione e funzioni come DeepThink e la ricerca sul web sono integrate.

Tuttavia, l'esecuzione in locale può essere un'opzione migliore per i seguenti motivi

La privacy

Quando si utilizza la versione web o app, le query e gli eventuali file allegati vengono inviati ai server di DeepSeek per l'elaborazione. Cosa succede a questi dati? Non lo sappiamo. L'esecuzione del modello a livello locale assicura che i dati rimangano sul vostro computer, dandovi il controllo completo sulla vostra privacy.

Accesso offline

Eseguire il modello in locale significa non aver bisogno di una connessione a Internet.

Se siete in viaggio, se incontrate una connessione Wi-Fi instabile o semplicemente preferite lavorare offline, la configurazione locale vi permette di usare DeepSeek sempre e ovunque.

A prova di futuro

Attualmente i servizi di DeepSeek sono gratuiti, ma è improbabile che ciò duri per sempre. A un certo punto, potrebbe essere necessario monetizzarli e potrebbero comparire restrizioni d'uso o tariffe di abbonamento. Con il modello locale, è possibile evitare del tutto queste restrizioni.

Flessibile

Con la versione locale, non siete limitati dalle impostazioni predefinite. Volete mettere a punto il modello?

Integrarlo con altri strumenti? La natura open source di DeepSeek R1 offre infinite possibilità.

Sintesi

Al momento non è ancora chiaro come DeepSeek gestisca i dati degli utenti.

Se non vi interessa la privacy dei dati, la scelta migliore potrebbe essere quella di utilizzare le applicazioni web o mobili. Sono più facili da usare e offrono funzioni come DeepThink e la ricerca sul web.

Ma se vi interessa sapere dove vanno a finire i vostri dati, il modello locale è una buona alternativa da prendere in considerazione.

Il modello DeepSeek è progettato per funzionare bene anche su hardware non particolarmente potente.

Mentre i modelli più grandi, come DeepSeek-R1-Zero, richiedono una configurazione distribuita delle GPU, la versione lite permette di funzionare senza problemi su una singola GPU con requisiti di memoria inferiori.