DeepSeek R1, un nuevo modelo lingüístico de IA de código abierto desarrollado por la empresa china de IA DeepSeek, es popular en estos momentos.

Algunos usuarios afirman que es comparable o incluso más potente que o1 de OpenAI en términos de capacidad de inferencia.

Actualmente, DeepSeek es gratuito, lo que es una buena noticia para los usuarios, pero también plantea algunas preguntas.

¿Cómo afrontarán el coste del servidor a medida que aumente el número de usuarios? El hardware que ejecuta el modelo no debe ser barato, ¿verdad?

Una suposición razonable son los datos.

Los datos son la savia de los modelos de IA, que pueden recopilar datos de los usuarios de alguna manera, y estos datos pueden ser útiles para sus modelos comerciales u otras formas de monetización.

Si le preocupa la privacidad de los datos pero quiere utilizar R1 sin compartirlos, la mejor opción es ejecutar el modelo localmente.

¿Qué es la DeepSeek R1?

Hace unos días, DeepSeek R1 se presentó como un modelo totalmente de código abierto. Esto significa que cualquiera puede acceder a su código subyacente, realizar modificaciones e incluso ajustarlo a sus propias necesidades.

DeepSeek R1 (a menudo abreviado como R1) se deriva de un gran modelo base llamado DeepSeek-V3.

El equipo de investigación ha optimizado este modelo combinando el ajuste fino supervisado (SFT) con datos de alta calidad anotados manualmente y el aprendizaje por refuerzo (RL).

El resultado es un chatbot capaz de responder a preguntas complejas, mostrar el razonamiento que las sustenta (a veces con más claridad que otros modelos) e incluso presentar código en la interfaz de chat para realizar pruebas rápidas.

Es realmente impresionante, sobre todo para un modelo de código abierto.

Cómo ejecutar DeepSeek R1 localmente

A ejecutar DeepSeek R1 localmenteutilizaremos una herramienta llamada Ollama.

Ollama es una herramienta gratuita y de código abierto que permite a los usuarios ejecutar grandes modelos lingüísticos (LLM) localmente en sus ordenadores.

Está disponible para macOS, Linux y Windows.Visite el sitio web oficial de Ollama, haga clic en el botón "Descargar" e instálelo en su sistema.

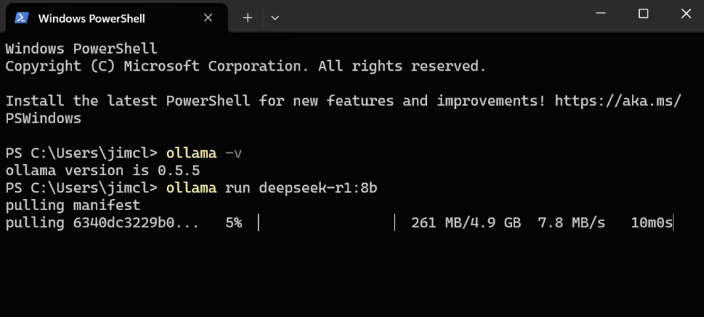

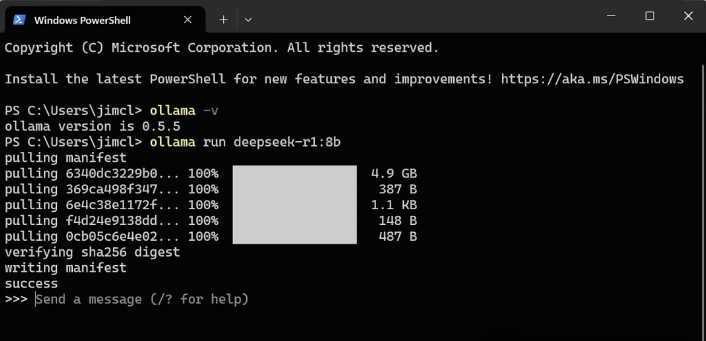

Para confirmar que la instalación se ha realizado correctamente,

abra un terminal y ejecute el siguiente comando:ollama -v

Debería ver el número de versión de Ollama en lugar de un mensaje de error.

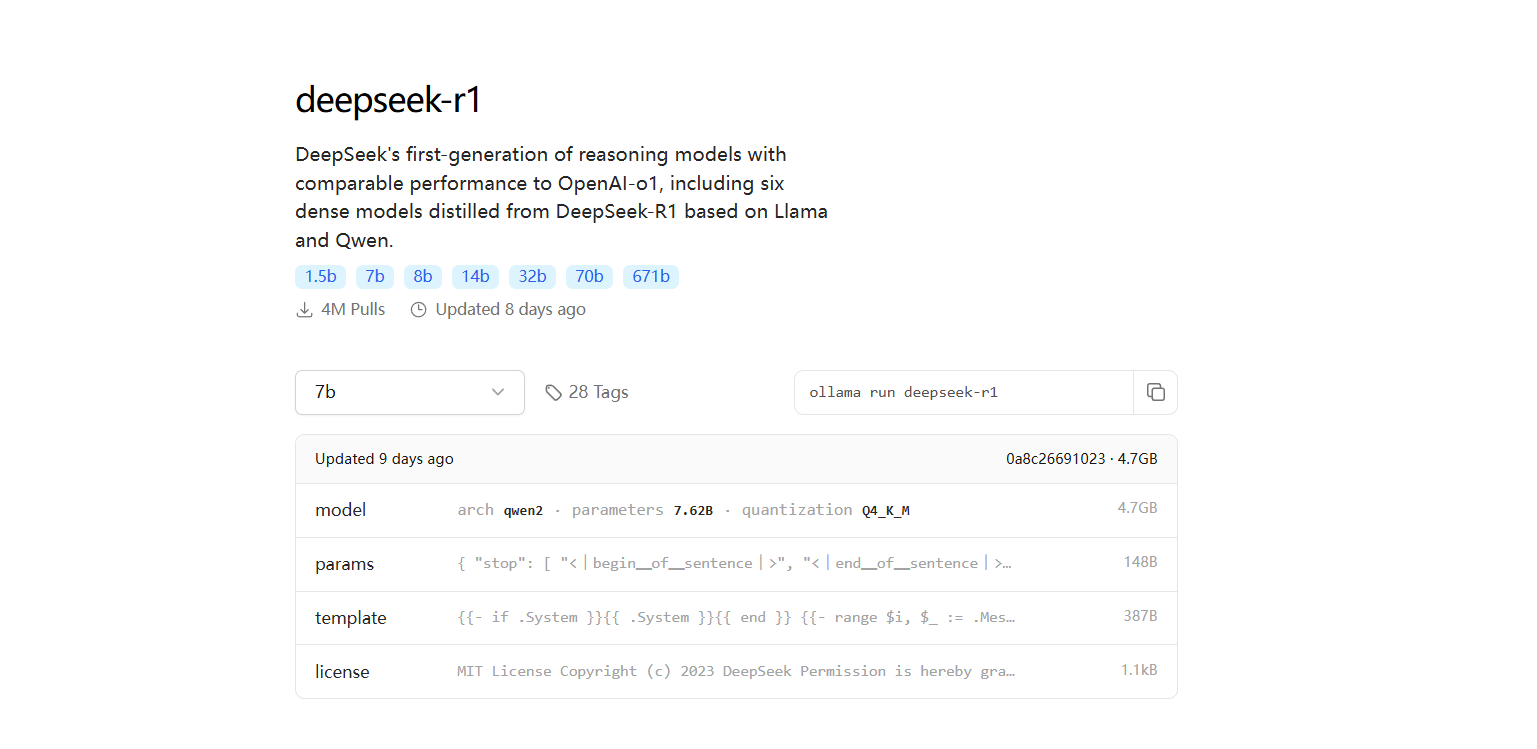

En la pestaña "Modelos", busque la palabra clave "deepseek" y debería ver "deepseek-r1" al principio de la lista.

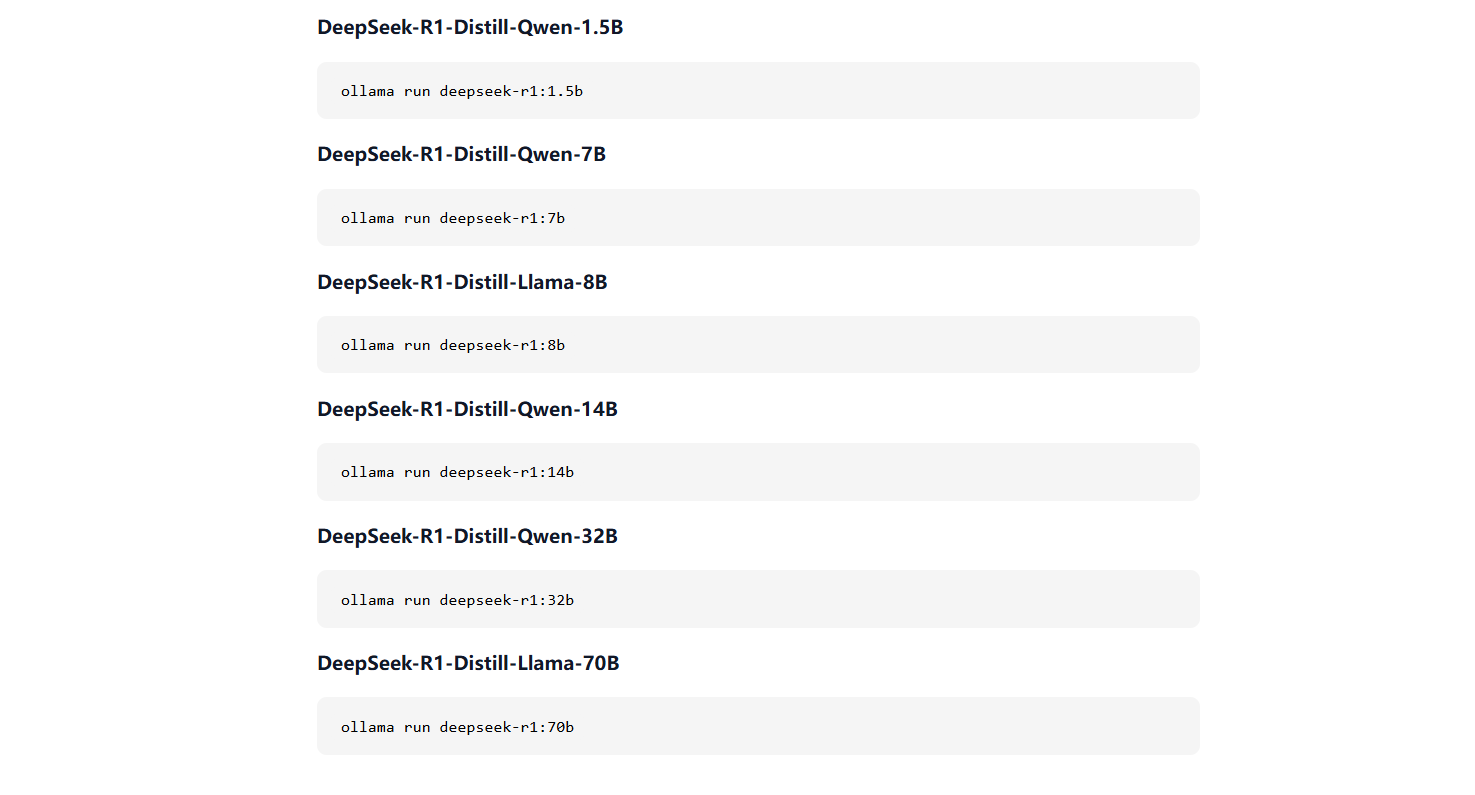

Haz clic en él y, en la sección "Modelos", verás que hay múltiples tamaños de modelos con parámetros que van de 5.000 millones a 671.000 millones.Por regla general, los modelos más grandes requieren GPU más potentes para ejecutarse.

Un modelo pequeño, como la versión de 8.000 millones de parámetros, puede ejecutarse en una GPU con 8 GB de memoria gráfica, mientras que los modelos más grandes requieren muchos más recursos (véase más adelante la sección sobre memoria gráfica y requisitos de la GPU).

Para descargar y ejecutar el modelo de 8.000 millones de parámetros, utilice el siguiente comando:ollama run deepseek-r1:8b

El modelo comenzará a descargarse (aprox. 4,9 GB). Antes de continuar, asegúrese de que dispone de espacio suficiente en el disco duro.

Una vez finalizada la descarga, el modelo se ejecutará en tu ordenador local y podrás iniciar una conversación con él inmediatamente.

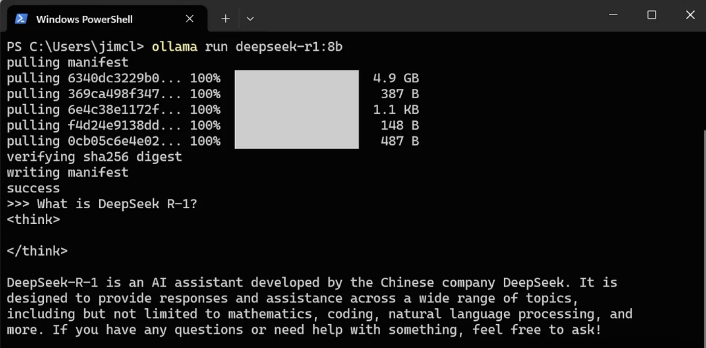

Vamos a probarlo con un ejemplo:

Prompt: Qué es DeepSeek R-1?

Respuesta: DeepSeek R-1 es un asistente de IA desarrollado por la empresa china DeepSeek.

Está diseñado para proporcionar respuestas y ayuda sobre una variedad de temas, incluyendo pero no limitado a las matemáticas, programación, procesamiento del lenguaje natural, etc. Si tienes alguna pregunta o necesitas ayuda, ¡no dudes en preguntarme!

Estupendo.

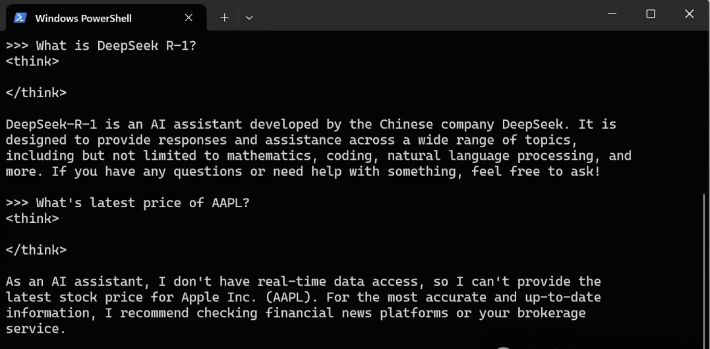

Es rápido y funciona incluso cuando desconecto mi portátil de la red Wi-Fi. Ten en cuenta que no puede acceder a Internet aunque estés conectado a ella.

Consejo: ¿Cuál es la última cotización de AAPL?

Respuesta: Como asistente de IA, no puedo acceder a datos en tiempo real y, por lo tanto, no puedo proporcionar el último precio de las acciones de Apple Inc. (AAPL).

Para obtener la información más precisa y actualizada, le sugiero que consulte las plataformas de noticias financieras o sus servicios de corretaje.Otras cosas que puede hacer Ollama:

Ejecuta LLMs localmente, incluyendo LLaMA2, Phi 4, Mistral y Gemma 2Permite a los usuarios crear y compartir sus propios LLMsPackage model weights, configurations, and data into a single packageOptimiza los ajustes y detalles de configuración, incluyendo el uso de la GPU.

Requisitos de GPU y memoria

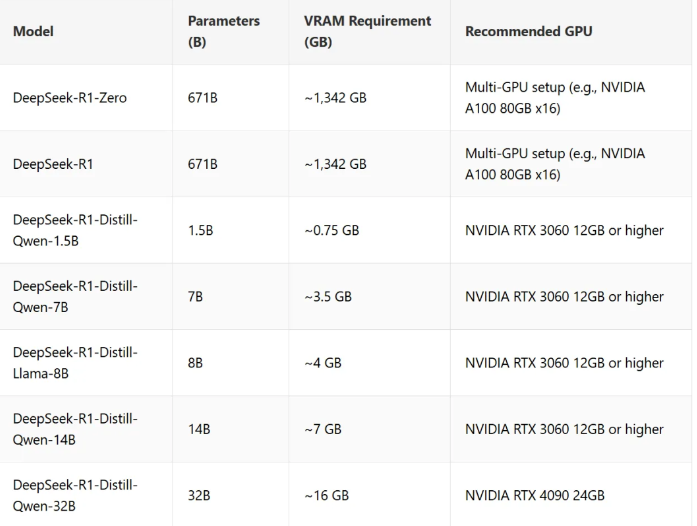

Los requisitos de memoria de DeepSeek-R1 dependen de factores como el tamaño del modelo, el número de parámetros y la técnica de cuantización.

A continuación se detallan los requisitos de memoria de DeepSeek-R1 y su modelo reducido, así como las GPU recomendadas:

Nota clave sobre el uso de la memoria:

Configuración de GPU distribuida para modelos grandes: DeepSeek-R1-Zero y DeepSeek-R1 requieren mucha memoria gráfica y, por tanto, una configuración de GPU distribuida (por ejemplo, NVIDIA A100 o H100 en una configuración multi-GPU) para obtener un rendimiento óptimo.

Los modelos Lite están optimizados para ejecutarse en una sola GPU con menores requisitos de memoria gráfica, a partir de 0,7 GB.

Consumo adicional de memoria: La activación, los búferes y las tareas por lotes pueden consumir memoria adicional.

¿Por qué funcionar localmente?

El chatbot web y la aplicación móvil de DeepSeek son gratuitos y muy prácticos. No necesitas hacer ninguna configuración y funciones como DeepThink y la búsqueda web están integradas.

Sin embargo, ejecutarlo localmente puede ser una mejor opción por las siguientes razones

Privacidad

Cuando se utiliza la versión web o de aplicación, las consultas y los archivos adjuntos se envían a los servidores de DeepSeek para su procesamiento. Ejecutar el modelo localmente garantiza que los datos permanezcan en su ordenador, lo que le proporciona un control total sobre su privacidad.

Acceso sin conexión

Ejecutar el modelo localmente significa que no necesitas conexión a Internet.

Si está de viaje, se encuentra con una red Wi-Fi inestable o simplemente prefiere trabajar sin conexión, la configuración local le permite utilizar DeepSeek en cualquier momento y en cualquier lugar.

Preparado para el futuro

Actualmente, los servicios de DeepSeek son gratuitos, pero es poco probable que esto dure para siempre. En algún momento habrá que monetizarlos y es posible que aparezcan restricciones de uso o cuotas de suscripción. Con el modelo local, puede evitar por completo estas restricciones.

Flexible

Con la versión local, no estás limitado por los ajustes por defecto. ¿Quieres ajustar el modelo?

¿Integrarlo con otras herramientas? La naturaleza de código abierto de DeepSeek R1 le ofrece infinitas posibilidades.

Resumen

Por el momento, aún no está claro cómo maneja DeepSeek los datos de los usuarios.

Si no te preocupa la privacidad de los datos, utilizar la web o las aplicaciones móviles puede ser una mejor opción. Son más fáciles de usar y ofrecen funciones como DeepThink y búsqueda web.

Pero si te preocupa a dónde van a parar tus datos, el modelo local es una buena alternativa a tener en cuenta.

El modelo DeepSeek está diseñado para funcionar bien incluso en hardware no especialmente potente.

Mientras que los modelos de mayor tamaño, como DeepSeek-R1-Zero, requieren una configuración de GPU distribuida, la versión lite permite ejecutarlos sin problemas en una sola GPU con menores requisitos de memoria.