ディープシークR1中国のAI企業DeepSeekが開発した新しいオープンソースのAI言語モデルが今人気だ。

推論能力という点ではOpenAIのo1に匹敵するか、それよりも強いと主張するユーザーもいる。

現在、DeepSeekは無料であり、ユーザーにとっては朗報だが、いくつかの疑問も生じている。

ユーザー数が増えるにつれて、サーバーのコストはどのように処理されるのでしょうか?モデルを動かすハードウェアは安くはないはずですよね?

妥当な推測のひとつはデータだ。

データはAIモデルの生命線である。AIモデルは何らかの方法でユーザーデータを収集し、このデータは取引モデルやその他の収益化に役立つ可能性がある。

データのプライバシーが心配だが、データを共有することなくR1を使いたい場合は、ローカルでモデルを実行するのがベストだ。

何なのか? ディープシークR1?

数日前、DeepSeek R1が完全なオープンソースモデルとして発表された。これは、誰もがその基礎となるコードにアクセスし、修正を加え、さらに自分のニーズに合わせて微調整できることを意味する。

DeepSeek R1(しばしばR1と略される)は、DeepSeek-V3と呼ばれる大規模なベースモデルから派生したものである。

研究チームは、高品質な手動アノテーションデータと強化学習(RL)を用いた教師あり微調整(SFT)を組み合わせることで、このモデルを最適化した。

その結果、複雑なプロンプトを処理し、複雑な質問の背後にある理由を示し(時には他のモデルよりも明確に)、さらには迅速なテストのためにチャットインターフェイスでコードを提示することができるチャットボットが生まれました。

特にオープンソースのモデルとしては本当に素晴らしい。

DeepSeek R1をローカルで実行する方法

へ DeepSeek R1をローカルで実行するOllamaというツールを使います。

Ollamaは、大規模な言語モデル(LLM)をローカルで実行できる無料のオープンソースツールである。

Ollamaの公式ウェブサイトを訪れ、「ダウンロード」ボタンをクリックし、システムにインストールする。

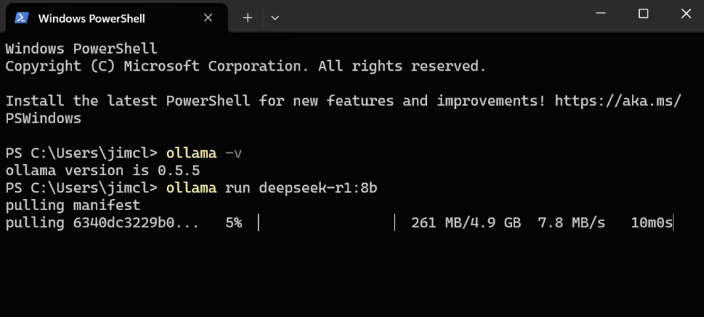

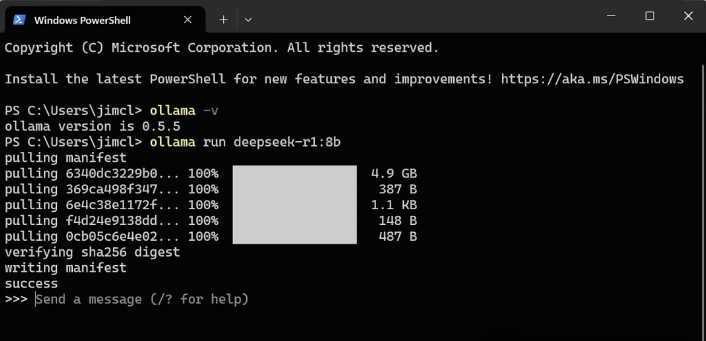

インストールの成功を確認する、

ターミナルを開き、次のコマンドを実行する。

エラーメッセージの代わりにOllamaのバージョン番号が表示されるはずです。

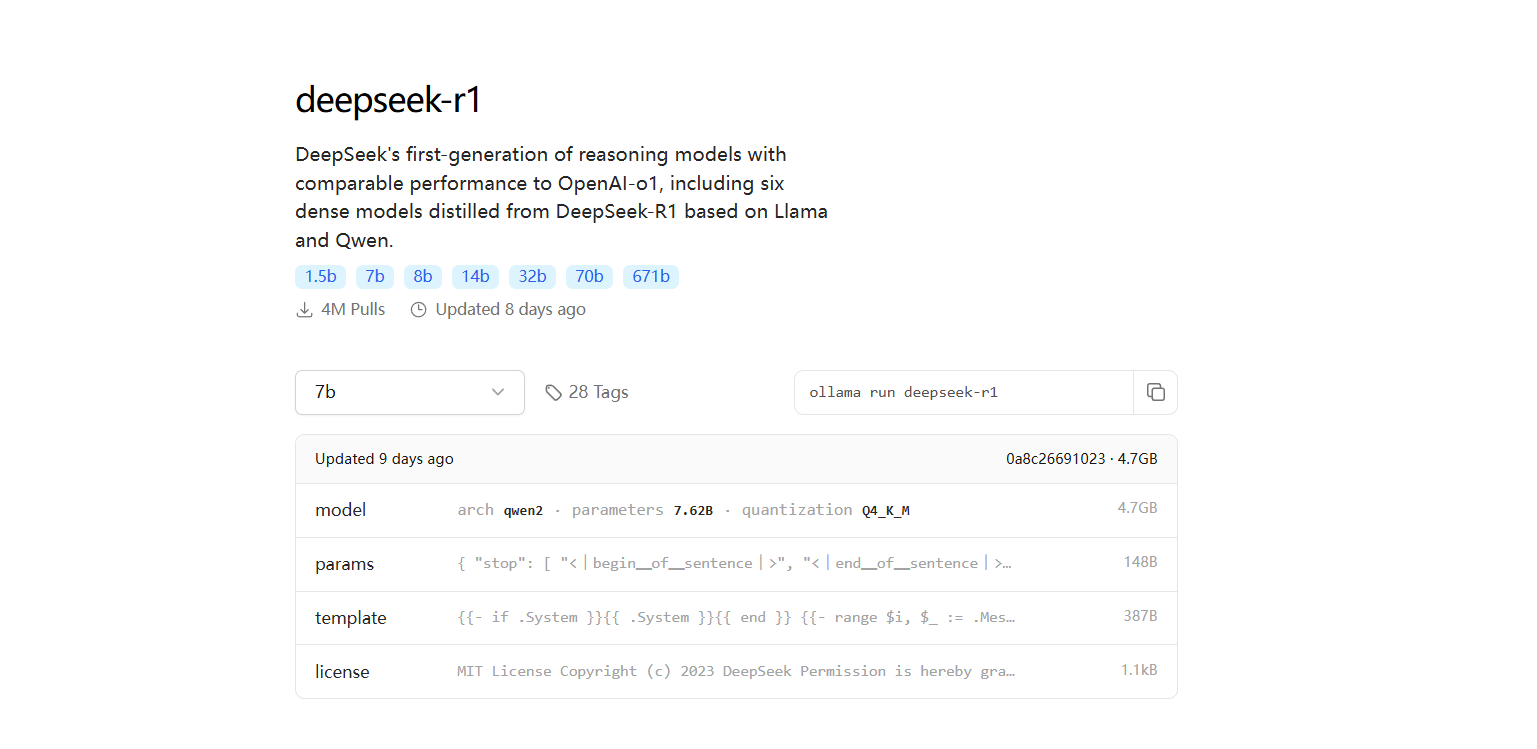

モデル」タブでキーワード「deepseek」を検索すると、リストの一番上に「deepseek-r1」が表示されるはずだ。

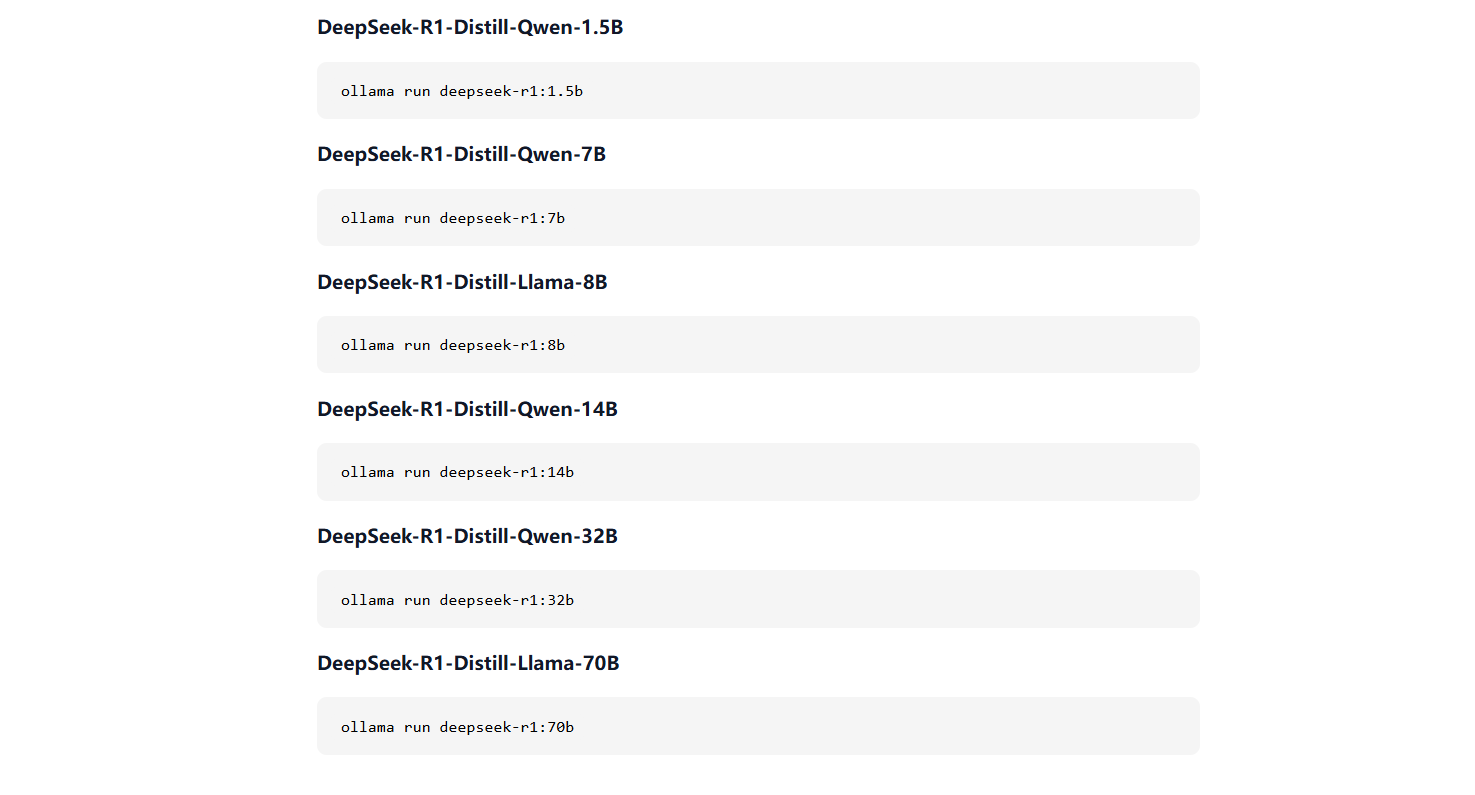

それをクリックすると、"Models "セクションで、50億から6710億までのパラメーターを持つ複数のモデルサイズがあることがわかります。一般的なルールとして、より大きなモデルを実行するには、より強力なGPUが必要です。

80億パラメータバージョンのような小さなモデルは、8GBのグラフィックメモリを搭載したGPUで実行できますが、より大きなモデルは、かなり多くのリソースを必要とします(グラフィックメモリとGPU要件については、以下のセクションを参照してください)。

80億パラメータモデルをダウンロードして実行するには、以下のコマンドを使用します:オラマ・ラン・ディープシーク R1:8B

モデルのダウンロードが始まります(約4.9GB)。先に進む前に、十分なディスク容量があることを確認してください。

ダウンロードが完了すると、モデルはあなたのローカル・コンピューター上で実行され、すぐに会話を始めることができます。

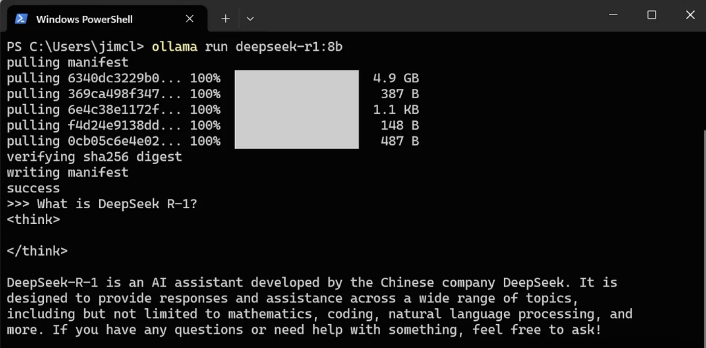

プロンプトのサンプルでテストしてみよう:

プロンプト ディープシークR-1とは?

レスポンスDeepSeek R-1は、中国のDeepSeek社が開発したAIアシスタントです。

数学、プログラミング、自然言語処理など、様々なトピックに関する回答やヘルプを提供することを目的としています。ご質問やお困りのことがありましたら、お気軽にお尋ねください!

素晴らしい。

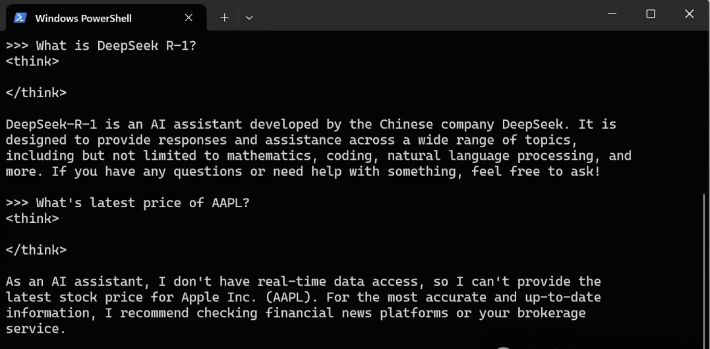

高速で、ノートパソコンをWi-Fiネットワークから切り離しても動作する。なお、インターネットに接続していても、インターネットにはアクセスできません。

ヒント:AAPLの最新株価は?

回答AIアシスタントとして、リアルタイムのデータにアクセスすることはできませんので、アップル社(AAPL)の最新の株価を提供することはできません。

最も正確で最新の情報については、金融ニュースプラットフォームや証券会社のサービスをチェックすることをお勧めする:

LLaMA2、Phi 4、Mistral、Gemma 2を含むLLMをローカルで実行ユーザが独自のLLMを作成および共有できるようにするモデルの重み、構成、データを1つのパッケージにパッケージ化GPUの使用を含む設定と構成の詳細を最適化。

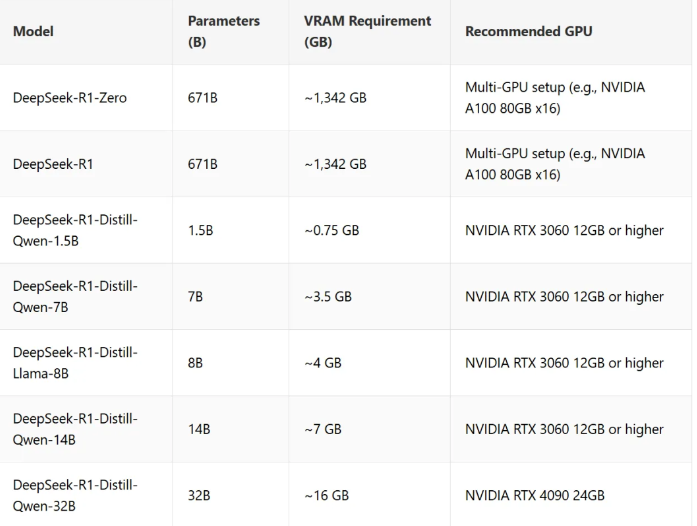

GPUとメモリの要件

DeepSeek-R1 のメモリ要件は、モデルのサイズ、パラメータの数、量子化手法などの要因に依存します。

ここでは、DeepSeek-R1およびその縮小モデルのメモリ要件の詳細と、推奨GPUの概要を説明します:

メモリ使用量に関する主な注意事項:

大規模モデル用の分散 GPU セットアップ:DeepSeek-R1-ZeroおよびDeepSeek-R1は、多くのグラフィックメモリを必要とするため、最適なパフォーマンスを得るには分散GPU構成(マルチGPUセットアップのNVIDIA A100またはH100など)が必要です。

LiteモデルはシングルGPUで動作するように最適化されており、必要なグラフィックメモリは0.7GBからと少ない。

追加のメモリ使用:アクティベーション、バッファ、バッチタスクは追加のメモリを消費する可能性があります。

なぜローカルで走るのか?

DeepSeekのウェブチャットボットとモバイルアプリは無料でとても便利です。セットアップの必要もなく、DeepThinkやウェブ検索などの機能が組み込まれています。

しかし、以下のような理由から、ローカルで実行する方が良い選択肢かもしれない。

プライバシー

Web版またはアプリ版を使用すると、クエリと添付ファイルが処理のためにDeepSeekのサーバに送信されます。このデータがどうなるかは不明です。モデルをローカルで実行すると、データはお客様のコンピュータに保存されるため、プライバシーを完全に管理できます。

オフラインアクセス

ローカルでモデルを動かすということは、インターネットに接続する必要がないということだ。

旅行中や不安定なWi-Fiに遭遇した場合、または単にオフラインで作業したい場合、ローカル・セットアップを使用すれば、いつでもどこでもDeepSeekを使用できます。

将来性

現在、DeepSeekのサービスは無料だが、これが永遠に続くことはないだろう。ある時点で収益化が必要となり、利用制限やサブスクリプション料金が発生する可能性がある。ローカルモデルでは、こうした制限を完全に回避することができる。

フレキシブル

ローカル版では、デフォルト設定に制限されることはありません。

他のツールとの統合DeepSeek R1はオープンソースであるため、無限の可能性があります。

概要

現時点では、ディープシークがユーザーデータをどのように扱っているかはまだ不明である。

データのプライバシーを気にしないのであれば、ウェブやモバイルアプリを使う方が良い選択かもしれない。これらの方が使いやすく、DeepThinkやウェブ検索などの機能が利用できる。

しかし、データの行き先を気にするのであれば、ローカルモデルを検討するのは良い選択肢だ。

ディープシーク・モデルは、特に高性能でないハードウェアでもうまく動作するように設計されている。

DeepSeek-R1-Zeroのような大きなモデルは、分散GPUセットアップを必要とするが、ライトバージョンは、より低いメモリ要件で単一のGPUでスムーズに実行することが可能である。