DeepSeek R1, ein neues Open-Source-KI-Sprachmodell, das von dem chinesischen KI-Unternehmen DeepSeek entwickelt wurde, ist derzeit sehr beliebt.

Einige Nutzer behaupten, dass es vergleichbar oder sogar stärker als OpenAIs o1 in Bezug auf die Inferenzfähigkeiten ist.

Derzeit ist DeepSeek kostenlos, was für die Nutzer eine gute Nachricht ist, aber auch einige Fragen aufwirft.

Wie werden sie mit den Kosten für den Server umgehen, wenn die Zahl der Nutzer steigt?

Eine vernünftige Vermutung sind Daten.

Daten sind das Lebenselixier von KI-Modellen, die auf irgendeine Weise Nutzerdaten sammeln und diese Daten für ihre Handelsmodelle oder andere Formen der Monetarisierung nutzen können.

Wenn Sie sich Sorgen um den Datenschutz machen, R1 aber dennoch nutzen möchten, ohne Daten weiterzugeben, ist es am besten, das Modell lokal auszuführen.

Was ist DeepSeek R1?

Vor ein paar Tagen wurde DeepSeek R1 als vollständig quelloffenes Modell vorgestellt. Das bedeutet, dass jeder auf den zugrundeliegenden Code zugreifen, Änderungen vornehmen und sogar Feinabstimmungen für seine eigenen Bedürfnisse vornehmen kann.

DeepSeek R1 (oft als R1 abgekürzt) ist von einem großen Basismodell namens DeepSeek-V3 abgeleitet.

Das Forschungsteam hat dieses Modell durch die Kombination von überwachter Feinabstimmung (SFT) mit hochwertigen, manuell annotierten Daten und Reinforcement Learning (RL) optimiert.

Das Ergebnis ist ein Chatbot, der mit komplexen Eingabeaufforderungen umgehen kann, der die Gründe für komplexe Fragen aufzeigt (manchmal deutlicher als andere Modelle) und der sogar Code in der Chat-Oberfläche für schnelle Tests präsentiert.

Das ist wirklich beeindruckend, vor allem für ein Open-Source-Modell.

Wie Sie DeepSeek R1 lokal ausführen

An DeepSeek R1 lokal ausführenwerden wir ein Tool namens Ollama verwenden.

Ollama ist ein kostenloses und quelloffenes Tool, mit dem Benutzer große Sprachmodelle (LLMs) lokal auf ihren Computern ausführen können.

Besuchen Sie die offizielle Ollama-Website, klicken Sie auf die Schaltfläche "Download" und installieren Sie das Programm auf Ihrem System.

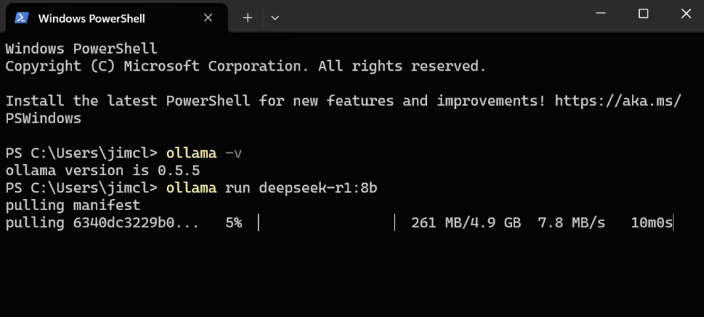

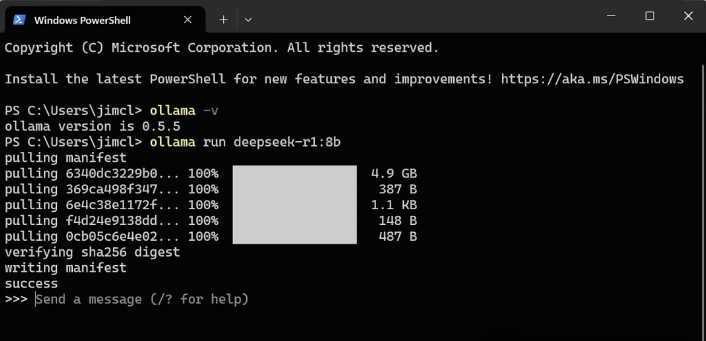

Um eine erfolgreiche Installation zu bestätigen,

Öffnen Sie ein Terminal und führen Sie den folgenden Befehl aus: ollama -v

Sie sollten die Ollama-Versionsnummer anstelle einer Fehlermeldung sehen.

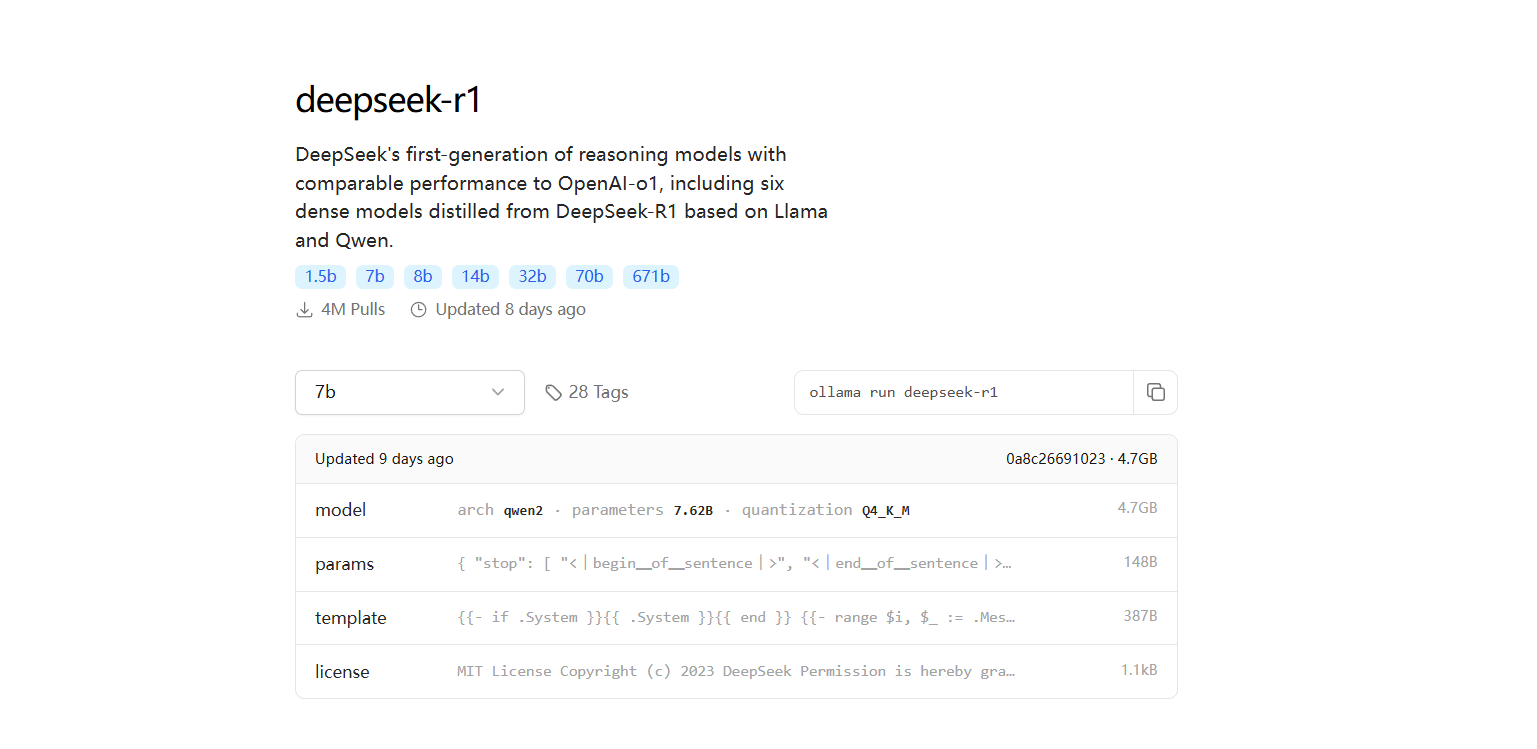

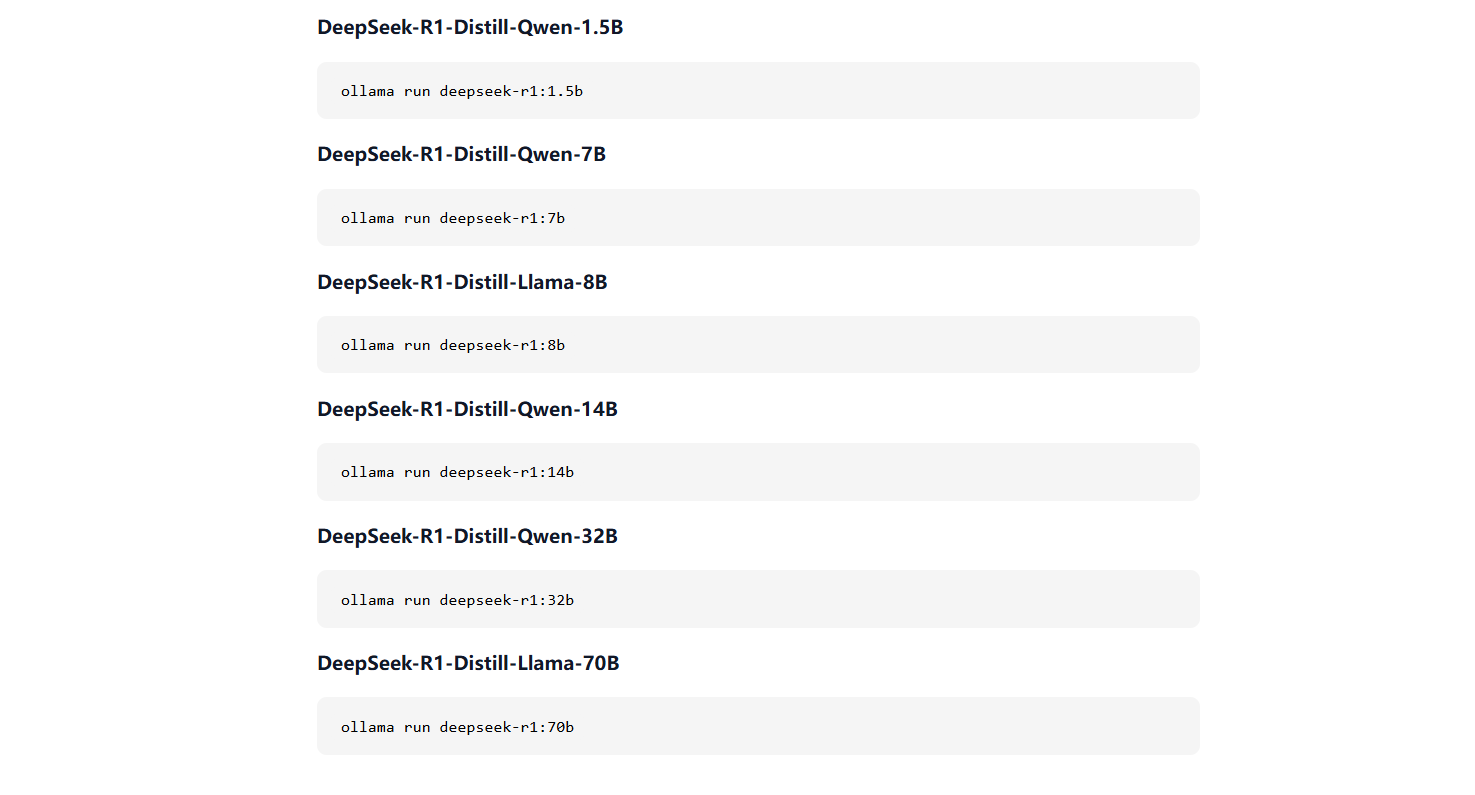

Suchen Sie unter der Registerkarte "Modelle" nach dem Schlüsselwort "deepseek", und Sie sollten "deepseek-r1" ganz oben in der Liste sehen.

Klicken Sie darauf, und im Abschnitt "Modelle" sehen Sie, dass es mehrere Modellgrößen mit Parametern zwischen 5 Mrd. und 671 Mrd. gibt, wobei größere Modelle in der Regel leistungsfähigere Grafikprozessoren erfordern.

Ein kleines Modell wie die 8-Milliarden-Parameter-Version kann auf einem Grafikprozessor mit 8 GB Grafikspeicher ausgeführt werden, während für größere Modelle deutlich mehr Ressourcen benötigt werden (siehe den folgenden Abschnitt über Grafikspeicher und GPU-Anforderungen).

Um das 8-Milliarden-Parameter-Modell herunterzuladen und auszuführen, verwenden Sie den folgenden Befehl:ollama run deepseek-r1:8b

Bevor Sie fortfahren, vergewissern Sie sich bitte, dass Sie über genügend Speicherplatz verfügen.

Sobald der Download abgeschlossen ist, läuft das Modell auf Ihrem lokalen Computer, und Sie können sofort eine Unterhaltung mit ihm beginnen.

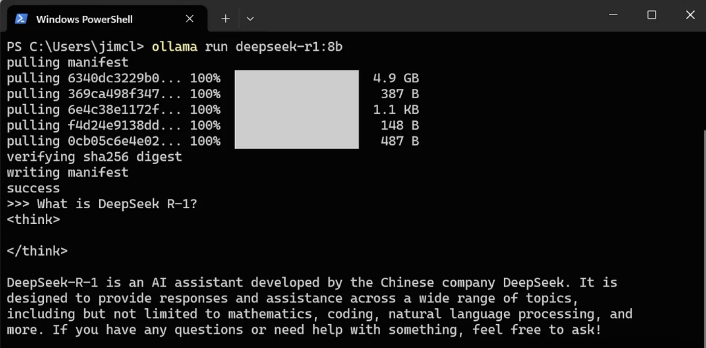

Testen wir dies mit einer Beispiel-Eingabeaufforderung:

Aufforderung: Was ist DeepSeek R-1?

Antwort: DeepSeek R-1 ist ein KI-Assistent, der von dem chinesischen Unternehmen DeepSeek entwickelt wurde.

Sie soll Antworten und Hilfe zu einer Vielzahl von Themen bieten, einschließlich, aber nicht beschränkt auf Mathematik, Programmierung, Verarbeitung natürlicher Sprache usw. Wenn Sie Fragen haben oder Hilfe brauchen, können Sie mich gerne fragen!

Großartig.

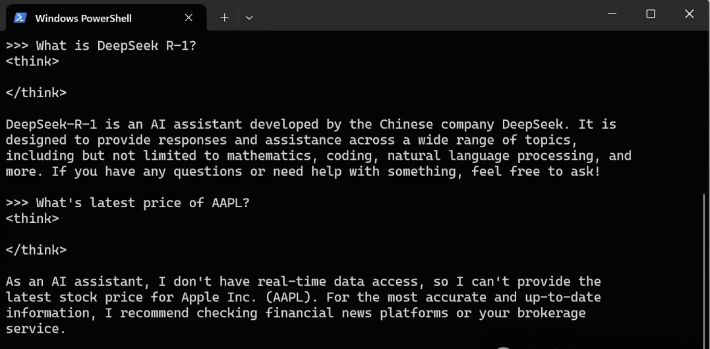

Es ist schnell und funktioniert auch, wenn ich meinen Laptop vom Wi-Fi-Netzwerk trenne. Bitte beachten Sie, dass das Gerät nicht auf das Internet zugreifen kann, auch wenn Sie mit diesem verbunden sind.

Tipp: Wie ist der aktuelle Aktienkurs von AAPL?

Antwort: Als KI-Assistent kann ich nicht auf Echtzeitdaten zugreifen und daher auch nicht den aktuellen Aktienkurs von Apple Inc. (AAPL) angeben.

Für die genauesten und aktuellsten Informationen empfehle ich Ihnen, die Finanznachrichtenplattformen oder Ihre Maklerdienste zu konsultieren.andere Dinge, die Ollama tun kann:

Lokale Ausführung von LLMs, einschließlich LLaMA2, Phi 4, Mistral und Gemma 2Erlauben Sie Nutzern, ihre eigenen LLMs zu erstellen und weiterzugebenPaketieren Sie Modellgewichte, Konfigurationen und Daten in einem einzigen PaketOptimieren Sie Einstellungen und Konfigurationsdetails, einschließlich der GPU-Nutzung.

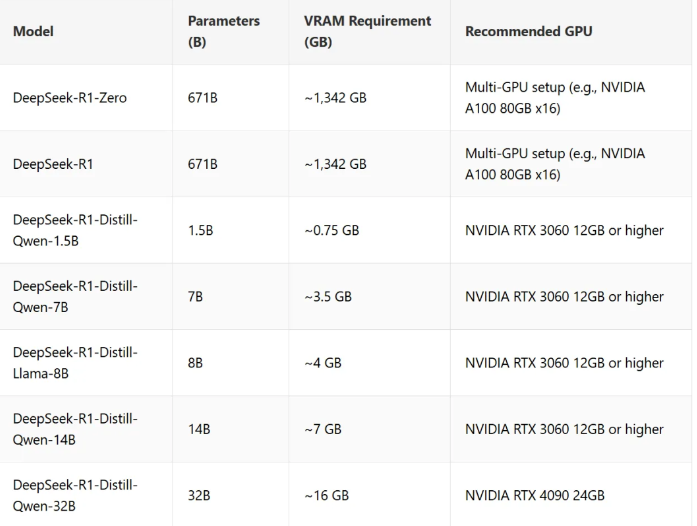

GPU- und Speicheranforderungen

Der Speicherbedarf für DeepSeek-R1 hängt von Faktoren wie der Größe des Modells, der Anzahl der Parameter und der Quantisierungstechnik ab.

Hier finden Sie einen detaillierten Überblick über die Speicheranforderungen für DeepSeek-R1 und sein reduziertes Modell sowie über die empfohlenen Grafikprozessoren:

Wichtiger Hinweis zur Speichernutzung:

Verteiltes GPU-Setup für große Modelle: DeepSeek-R1-Zero und DeepSeek-R1 benötigen viel Grafikspeicher und daher eine verteilte GPU-Konfiguration (z.B. NVIDIA A100 oder H100 in einem Multi-GPU-Setup) für optimale Leistung.

Die Lite-Modelle sind für die Ausführung auf einem einzelnen Grafikprozessor mit geringeren Anforderungen an den Grafikspeicher optimiert, beginnend bei 0,7 GB.

Zusätzlicher Speicherverbrauch: Aktivierungs-, Puffer- und Batch-Aufgaben können zusätzlichen Speicherplatz verbrauchen.

Warum lokal ausführen?

Der Web-Chatbot und die mobile App von DeepSeek sind kostenlos und sehr praktisch. Sie müssen nichts einrichten, und Funktionen wie DeepThink und Websuche sind bereits integriert.

Aus folgenden Gründen kann es jedoch besser sein, sie lokal auszuführen

Datenschutz

Wenn Sie die Web- oder App-Version verwenden, werden Ihre Abfragen und alle angehängten Dateien zur Verarbeitung an die Server von DeepSeek gesendet.Was mit diesen Daten geschieht, wissen wir nicht.Die lokale Ausführung des Modells stellt sicher, dass Ihre Daten auf Ihrem Computer bleiben, so dass Sie die vollständige Kontrolle über Ihre Privatsphäre haben.

Offline-Zugang

Wenn Sie das Modell lokal ausführen, benötigen Sie keine Internetverbindung.

Wenn Sie auf Reisen sind, ein instabiles WLAN haben oder einfach lieber offline arbeiten, können Sie DeepSeek mit der lokalen Einrichtung jederzeit und überall nutzen.

Zukunftssicher

Derzeit sind die DeepSeek-Dienste kostenlos, aber das wird wahrscheinlich nicht ewig so bleiben. Irgendwann müssen sie monetarisiert werden, und es kann zu Nutzungsbeschränkungen oder Abonnementgebühren kommen. Mit dem lokalen Modell können Sie diese Einschränkungen ganz vermeiden.

Flexibel

Mit der lokalen Version sind Sie nicht auf die Standardeinstellungen beschränkt, sondern können das Modell feinabstimmen.

Integrieren Sie es in andere Tools? Erstellen Sie eine benutzerdefinierte Schnittstelle... DeepSeek R1 ist Open Source und bietet Ihnen endlose Möglichkeiten.

Zusammenfassung

Im Moment ist noch unklar, wie DeepSeek mit den Nutzerdaten umgeht.

Wenn Sie sich nicht um den Datenschutz kümmern, sind Web- oder Mobil-Apps möglicherweise die bessere Wahl. Sie sind einfacher zu bedienen und bieten Funktionen wie DeepThink und Websuche.

Wenn es Ihnen jedoch wichtig ist, wo Ihre Daten gespeichert werden, ist das lokale Modell eine gute Alternative, die Sie in Betracht ziehen sollten.

Das DeepSeek-Modell ist so konzipiert, dass es auch auf nicht besonders leistungsfähiger Hardware gut funktioniert.

Während größere Modelle wie DeepSeek-R1-Zero ein verteiltes GPU-Setup erfordern, ermöglicht die Lite-Version einen reibungslosen Betrieb auf einer einzelnen GPU mit geringeren Speicheranforderungen.