DeepSeek R1, un nou model de limbaj AI cu sursă deschisă dezvoltat de compania chineză de AI DeepSeek, este popular în acest moment.

Unii utilizatori susțin că acesta este comparabil sau chiar mai puternic decât o1 de la OpenAI în ceea ce privește capacitățile de inferență.

În prezent, DeepSeek este gratuit, ceea ce este o veste bună pentru utilizatori, dar ridică și unele întrebări.

Cum vor gestiona costul serverului pe măsură ce numărul de utilizatori crește?Hardware-ul care rulează modelul nu ar trebui să fie ieftin, nu?

O presupunere rezonabilă sunt datele.

Datele sunt sufletul modelelor de inteligență artificială.Acestea pot colecta într-un fel sau altul date despre utilizatori, iar aceste date pot fi utile pentru modelele lor de tranzacționare sau pentru alte forme de monetizare.

Dacă sunteți îngrijorat de confidențialitatea datelor, dar doriți să utilizați R1 fără a partaja date, cea mai bună opțiune este să rulați modelul local.

Ce este DeepSeek R1?

Cu câteva zile în urmă, DeepSeek R1 a fost prezentat ca un model complet open source. Acest lucru înseamnă că oricine poate accesa codul său de bază, poate face modificări și chiar îl poate ajusta în funcție de propriile nevoi.

DeepSeek R1 (adesea abreviat ca R1) este derivat dintr-un model de bază mare numit DeepSeek-V3.

Echipa de cercetare a optimizat acest model prin combinarea ajustării fine supravegheate (SFT) cu date adnotate manual de înaltă calitate și învățarea prin consolidare (RL).

Acest lucru a dus la un chatbot care poate gestiona solicitări complexe, poate arăta raționamentul din spatele întrebărilor complexe (uneori mai clar decât alte modele) și chiar poate prezenta codul în interfața de chat pentru testare rapidă.

Este cu adevărat impresionant, mai ales pentru un model open-source.

Cum să executați DeepSeek R1 local

La rulați DeepSeek R1 local, vom utiliza un instrument numit Ollama.

Ollama este un instrument gratuit și cu sursă deschisă care permite utilizatorilor să ruleze modele lingvistice mari (LLM) la nivel local pe calculatoarele lor.

Este disponibil pentru macOS, Linux și Windows.Vizitați site-ul oficial Ollama, faceți clic pe butonul "Descărcare" și instalați-l pe sistemul dvs.

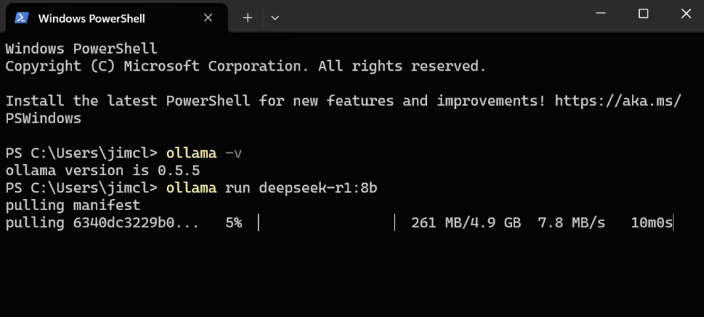

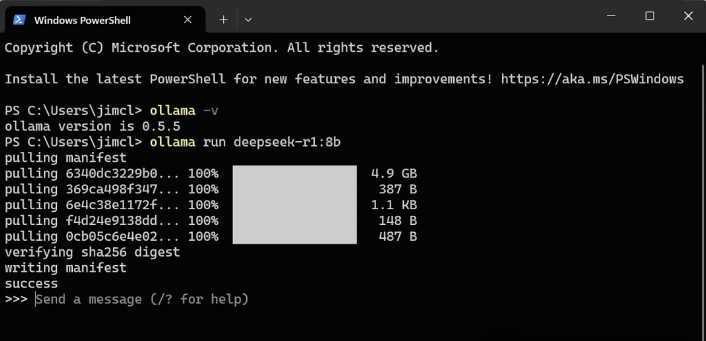

Pentru a confirma o instalare reușită,

deschideți un terminal și executați următoarea comandă:ollama -v

Ar trebui să vedeți numărul versiunii Ollama în loc de un mesaj de eroare.

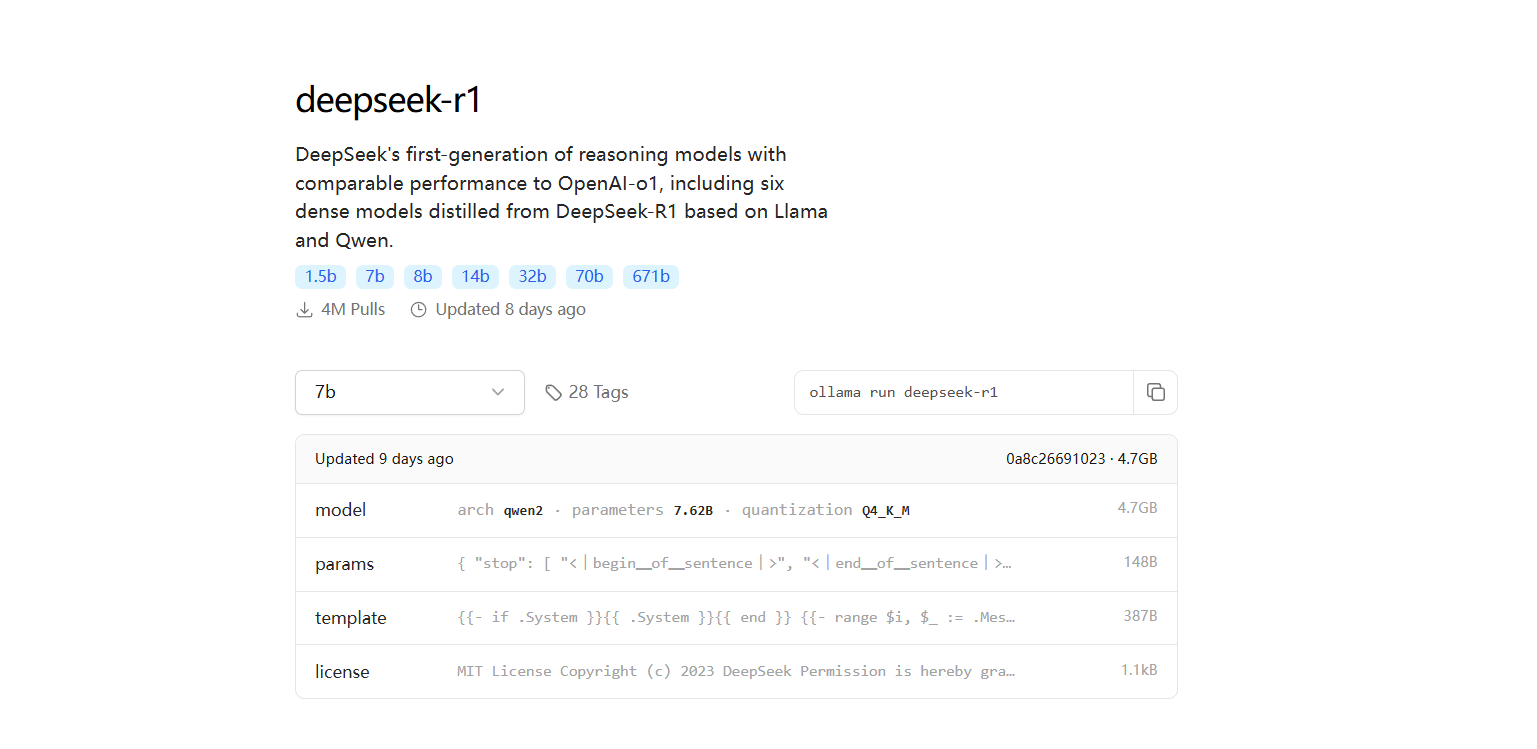

Sub fila "Modele", căutați cuvântul cheie "deepseek" și ar trebui să vedeți "deepseek-r1" în partea de sus a listei.

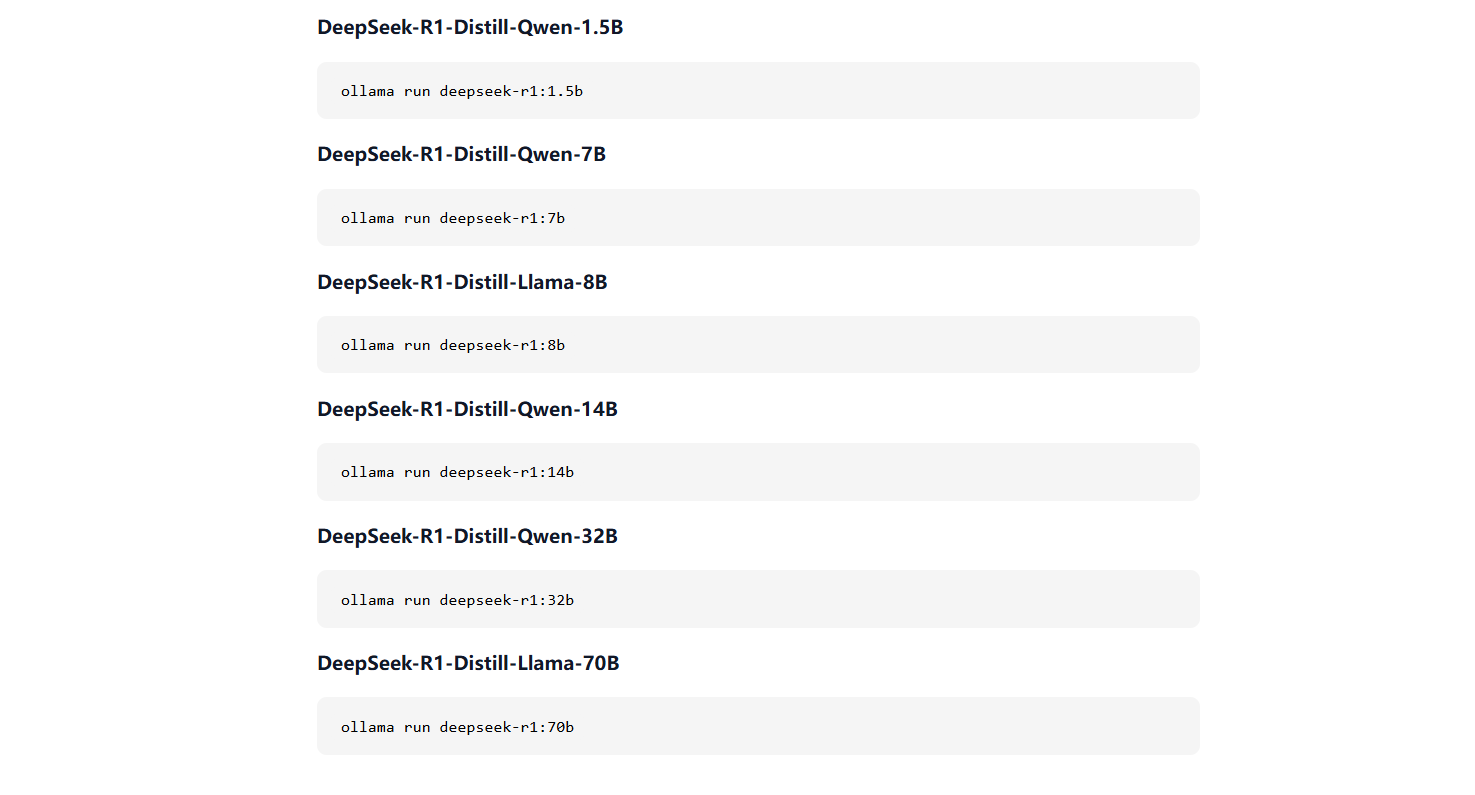

Faceți clic pe el, iar în secțiunea "Modele", veți vedea că există mai multe dimensiuni de model cu parametri variind de la 5 miliarde la 671 miliarde.Ca regulă generală, modelele mai mari necesită GPU-uri mai puternice pentru a fi rulate.

Un model mic, precum versiunea cu 8 miliarde de parametri, poate rula pe un GPU cu 8 GB de memorie grafică, în timp ce modelele mai mari necesită resurse semnificativ mai mari (consultați secțiunea de mai jos privind memoria grafică și cerințele GPU).

Pentru a descărca și rula modelul cu 8 miliarde de parametri, utilizați următoarea comandă:ollama run deepseek-r1:8b

Modelul va începe să fie descărcat (aprox. 4,9 GB).Înainte de a continua, asigurați-vă că aveți suficient spațiu pe disc.

Odată ce descărcarea este completă, modelul va rula pe computerul dvs. local și puteți începe imediat o conversație cu acesta.

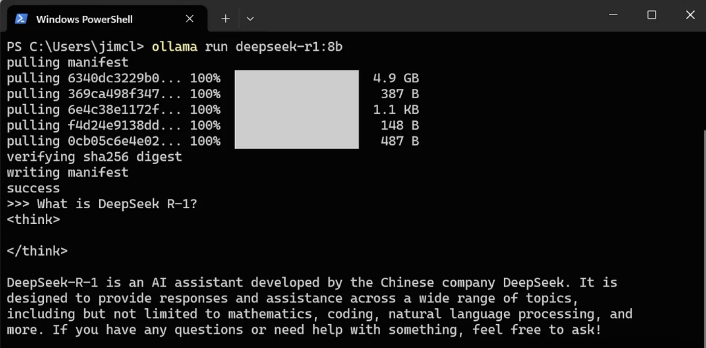

Să testăm acest lucru cu un exemplu de prompt:

Prompt: Ce este DeepSeek R-1?

Răspuns: DeepSeek R-1 este un asistent AI dezvoltat de compania chineză DeepSeek.

Acesta este conceput pentru a oferi răspunsuri și ajutor pe o varietate de subiecte, inclusiv, dar fără a se limita la matematică, programare, procesarea limbajului natural etc. Dacă aveți întrebări sau aveți nevoie de ajutor, nu ezitați să mă întrebați!

Mare.

Este rapid și funcționează chiar și atunci când îmi deconectez laptopul de la rețeaua Wi-Fi. Vă rugăm să rețineți că nu poate accesa internetul chiar dacă sunteți conectat la el.

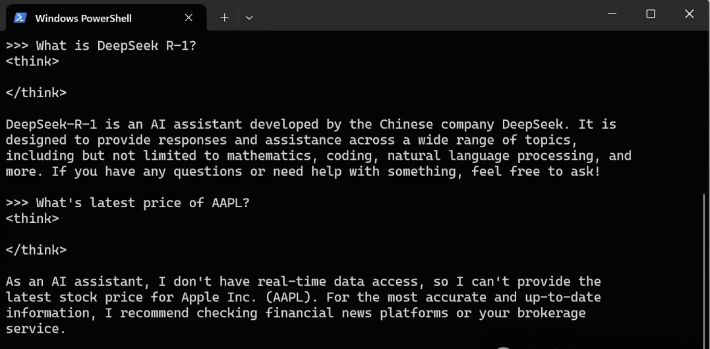

Sfat: Care este cel mai recent preț al acțiunilor AAPL?

Răspuns: Ca asistent AI, nu pot accesa date în timp real și, prin urmare, nu pot furniza cel mai recent preț al acțiunilor Apple Inc. (AAPL).

Pentru cele mai exacte și actualizate informații, vă sugerez să verificați platformele de știri financiare sau serviciile dvs. de brokeraj.Alte lucruri pe care le poate face Ollama:

Rulați LLM-uri local, inclusiv LLaMA2, Phi 4, Mistral și Gemma 2Permiteți utilizatorilor să creeze și să partajeze propriile LLM-uriPachetați ponderile modelului, configurațiile și datele într-un singur pachetOptimizați setările și detaliile de configurare, inclusiv utilizarea GPU.

Cerințe GPU și de memorie

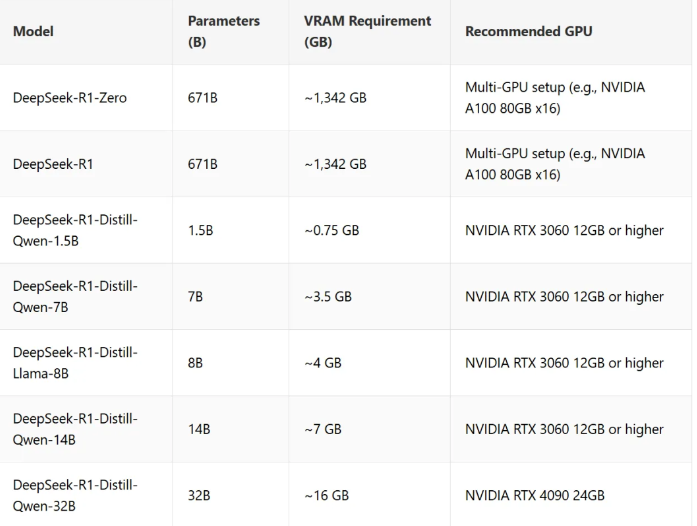

Cerințele de memorie pentru DeepSeek-R1 depind de factori precum dimensiunea modelului, numărul de parametri și tehnica de cuantizare.

Iată o prezentare detaliată a cerințelor de memorie pentru DeepSeek-R1 și modelul său redus, precum și GPU-urile recomandate:

Notă cheie privind utilizarea memoriei:

Configurație GPU distribuită pentru modele mari: DeepSeek-R1-Zero și DeepSeek-R1 necesită multă memorie grafică și, prin urmare, o configurație GPU distribuită (de exemplu, NVIDIA A100 sau H100 într-o configurație multi-GPU) pentru performanțe optime.

Modelele Lite sunt optimizate pentru a rula pe un singur GPU cu cerințe reduse de memorie grafică, începând de la 0,7 GB.

Utilizarea suplimentară a memoriei: Activarea, tampoanele și sarcinile pe loturi pot consuma memorie suplimentară.

De ce să rulați local?

Chatbotul web și aplicația mobilă DeepSeek sunt gratuite și foarte convenabile. Nu trebuie să faceți nicio configurare, iar funcții precum DeepThink și căutarea web sunt încorporate.

Cu toate acestea, rularea locală poate fi o opțiune mai bună din următoarele motive

Confidențialitate

Atunci când utilizați versiunea web sau aplicația, interogările dvs. și orice fișiere atașate sunt trimise la serverele DeepSeek pentru procesare.Ce se întâmplă cu aceste date?Nu știm.Rularea locală a modelului asigură faptul că datele dvs. rămân pe computerul dvs., oferindu-vă control complet asupra confidențialității dvs.

Acces offline

Rularea locală a modelului înseamnă că nu aveți nevoie de o conexiune la internet.

Dacă călătoriți, întâmpinați Wi-Fi instabil sau pur și simplu preferați să lucrați offline, configurația locală vă permite să utilizați DeepSeek oricând și oriunde.

Proaspăt pentru viitor

În prezent, serviciile DeepSeek sunt gratuite, dar acest lucru este puțin probabil să dureze la nesfârșit. La un moment dat, este posibil ca acestea să trebuiască să fie monetizate și să apară restricții de utilizare sau taxe de abonament. Cu modelul local, puteți evita complet aceste restricții.

Flexibil

Cu versiunea locală, nu sunteți limitat de setările implicite.Doriți să ajustați modelul?

Integrați-l cu alte instrumente? Construiți o interfață personalizată?Natura open source a DeepSeek R1 vă oferă posibilități nelimitate.

Rezumat

În prezent, nu este încă clar modul în care DeepSeek gestionează datele utilizatorilor.

Dacă nu vă pasă de confidențialitatea datelor, utilizarea aplicațiilor web sau mobile poate fi o alegere mai bună. Acestea sunt mai ușor de utilizat și oferă funcții precum DeepThink și căutarea web.

Dar dacă vă interesează unde ajung datele dvs., modelul local este o alternativă bună de luat în considerare.

Modelul DeepSeek este proiectat să funcționeze bine chiar și pe hardware care nu este deosebit de puternic.

În timp ce modelele mai mari precum DeepSeek-R1-Zero necesită o configurație GPU distribuită, versiunea lite face posibilă rularea fără probleme pe un singur GPU cu cerințe de memorie mai mici.