DeepSeek R1Nowy model językowy AI typu open-source opracowany przez chińską firmę DeepSeek jest obecnie bardzo popularny.

Niektórzy użytkownicy twierdzą, że jest on porównywalny lub nawet silniejszy niż o1 OpenAI pod względem możliwości wnioskowania.

Obecnie DeepSeek jest darmowy, co jest dobrą wiadomością dla użytkowników, ale rodzi też pewne pytania.

Jak poradzą sobie z kosztami serwera w miarę wzrostu liczby użytkowników? Sprzęt obsługujący model nie powinien być tani, prawda?

Jednym rozsądnym przypuszczeniem są dane.

Dane są siłą napędową modeli AI, które mogą w jakiś sposób gromadzić dane użytkowników, a dane te mogą być przydatne dla ich modeli handlowych lub innych form monetyzacji.

Jeśli obawiasz się o prywatność danych, ale nadal chcesz korzystać z R1 bez udostępniania danych, najlepszą opcją jest uruchomienie modelu lokalnie.

Co to jest DeepSeek R1?

Kilka dni temu DeepSeek R1 został zaprezentowany jako model w pełni open source. Oznacza to, że każdy może uzyskać dostęp do jego kodu bazowego, wprowadzać modyfikacje, a nawet dostosowywać go do własnych potrzeb.

DeepSeek R1 (często w skrócie R1) wywodzi się z dużego modelu bazowego o nazwie DeepSeek-V3.

Zespół badawczy zoptymalizował ten model, łącząc nadzorowane dostrajanie (SFT) z wysokiej jakości ręcznie adnotowanymi danymi i uczeniem ze wzmocnieniem (RL).

Zaowocowało to stworzeniem chatbota, który może obsługiwać złożone monity, pokazywać uzasadnienie złożonych pytań (czasami bardziej wyraźnie niż inne modele), a nawet prezentować kod w interfejsie czatu w celu szybkiego testowania.

To naprawdę imponujące, zwłaszcza jak na model open-source.

Jak uruchomić DeepSeek R1 lokalnie

Do uruchomić DeepSeek R1 lokalnieużyjemy narzędzia o nazwie Ollama.

Ollama to darmowe narzędzie typu open source, które pozwala użytkownikom uruchamiać duże modele językowe (LLM) lokalnie na ich komputerach.

Jest on dostępny dla systemów macOS, Linux i Windows. Odwiedź oficjalną stronę Ollama, kliknij przycisk "Pobierz" i zainstaluj go w swoim systemie.

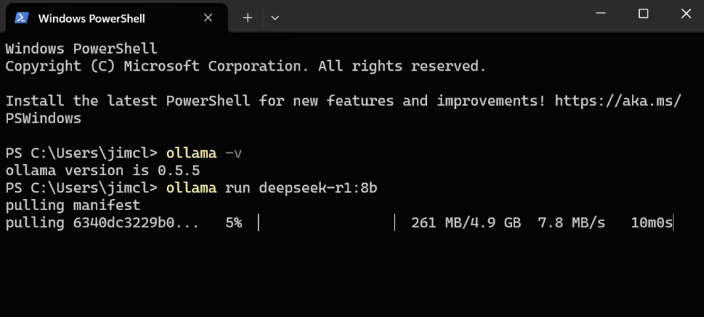

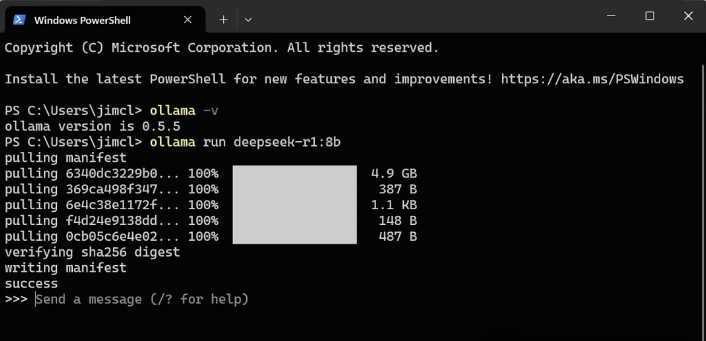

Aby potwierdzić pomyślną instalację,

otwórz terminal i uruchom następujące polecenie: ollama -v

Zamiast komunikatu o błędzie powinien pojawić się numer wersji Ollama.

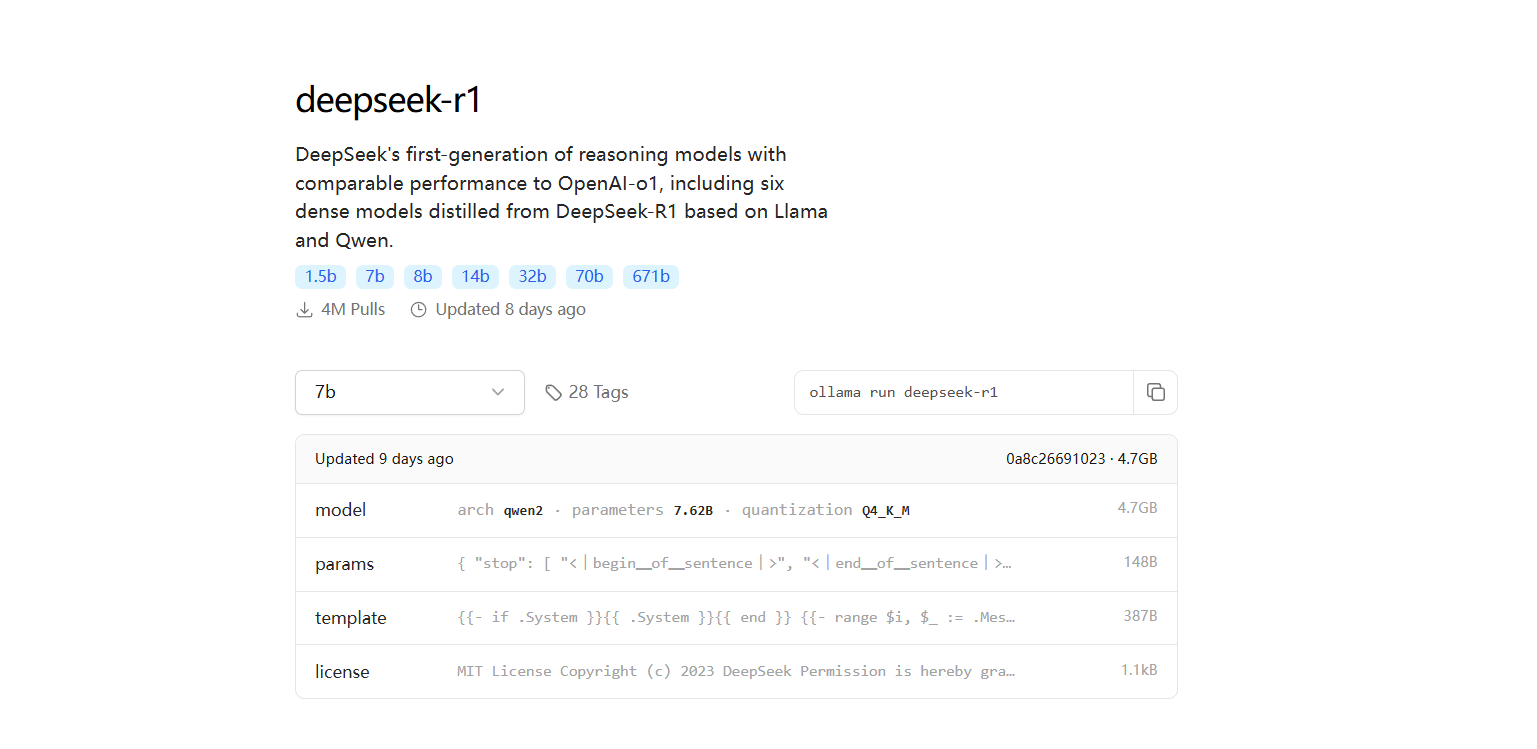

W zakładce "Modele" wyszukaj słowo kluczowe "deepseek" i powinieneś zobaczyć "deepseek-r1" na górze listy.

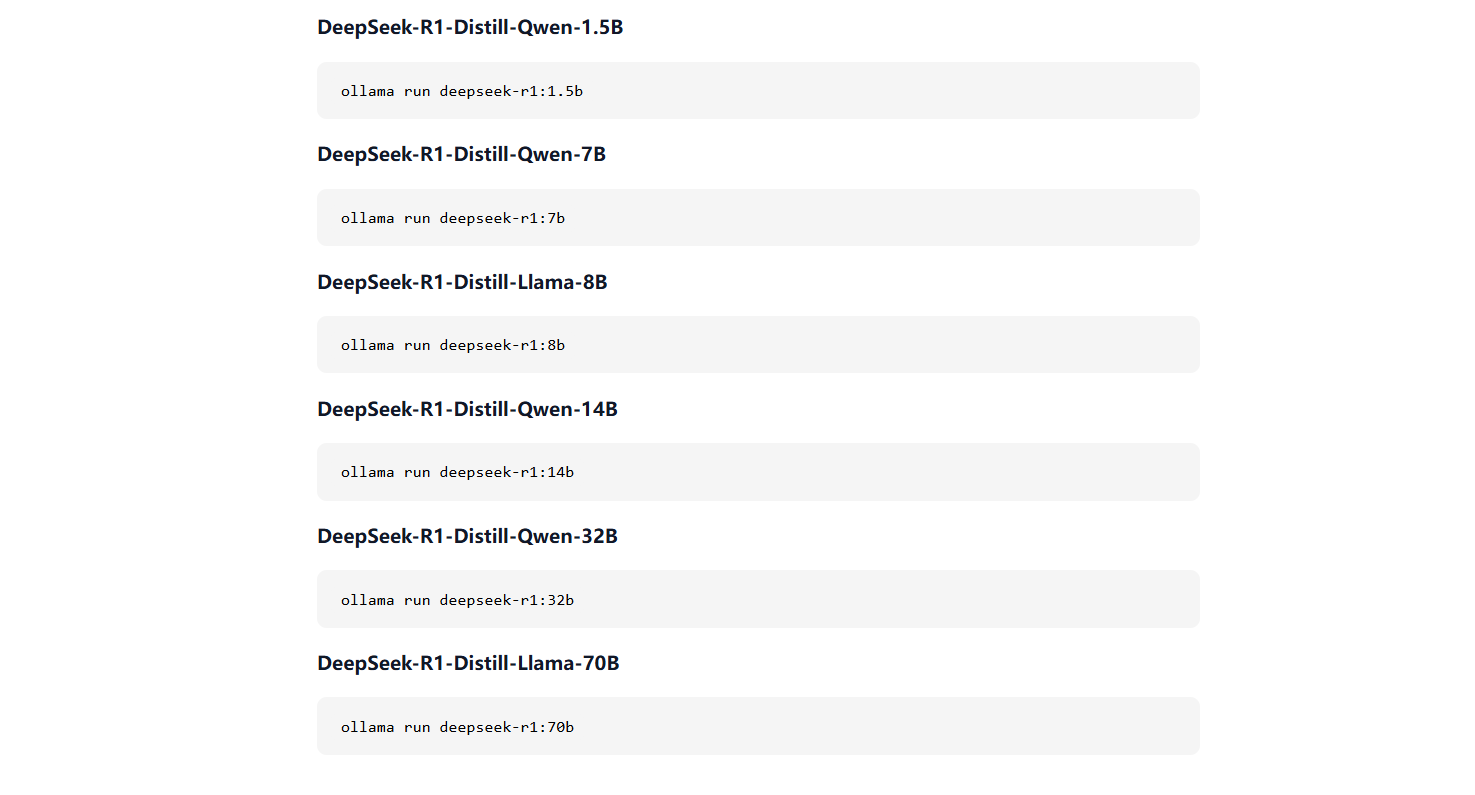

Kliknij na nią, a w sekcji "Modele" zobaczysz, że istnieje wiele rozmiarów modeli o parametrach od 5 miliardów do 671 miliardów. Z reguły większe modele wymagają do działania mocniejszych procesorów graficznych.

Mały model, taki jak wersja z 8 miliardami parametrów, może działać na GPU z 8 GB pamięci graficznej, podczas gdy większe modele wymagają znacznie więcej zasobów (patrz sekcja poniżej dotycząca pamięci graficznej i wymagań GPU).

Aby pobrać i uruchomić model o 8 miliardach parametrów, należy użyć następującego polecenia:ollama run deepseek-r1:8b

Rozpocznie się pobieranie modelu (ok. 4,9 GB). Przed kontynuowaniem upewnij się, że masz wystarczającą ilość miejsca na dysku.

Po zakończeniu pobierania model zostanie uruchomiony na komputerze lokalnym i będzie można natychmiast rozpocząć z nim rozmowę.

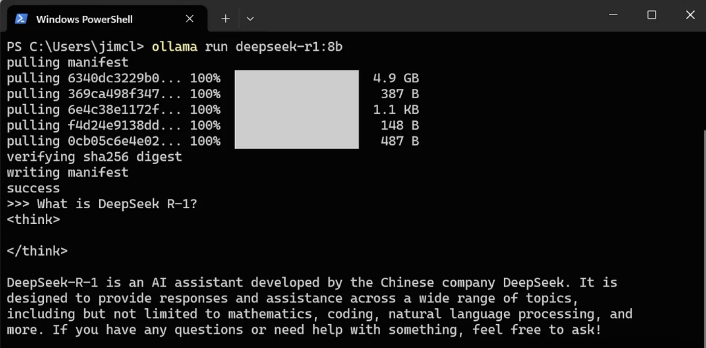

Przetestujmy to za pomocą przykładowego monitu:

Prompt: Czym jest DeepSeek R-1?

Odpowiedź: DeepSeek R-1 to asystent AI opracowany przez chińską firmę DeepSeek.

Jego celem jest dostarczanie odpowiedzi i pomocy na różne tematy, w tym między innymi matematykę, programowanie, przetwarzanie języka naturalnego itp. Jeśli masz jakieś pytania lub potrzebujesz pomocy, nie krępuj się mnie zapytać!

Świetnie.

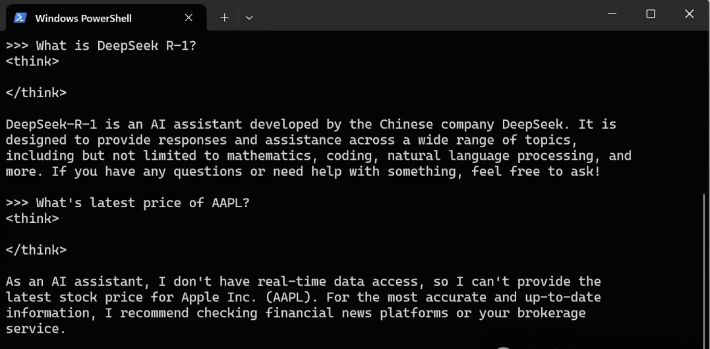

Jest szybki i działa nawet po odłączeniu laptopa od sieci Wi-Fi. Należy pamiętać, że nie może uzyskać dostępu do Internetu, nawet jeśli jesteś z nim połączony.

Wskazówka: Jaka jest najnowsza cena akcji AAPL?

Odpowiedź: Jako asystent AI nie mam dostępu do danych w czasie rzeczywistym i dlatego nie mogę podać najnowszej ceny akcji Apple Inc (AAPL).

Aby uzyskać najdokładniejsze i najbardziej aktualne informacje, sugeruję sprawdzenie platform z wiadomościami finansowymi lub usług maklerskich.inne rzeczy, które może zrobić Ollama:

Uruchamiaj LLM lokalnie, w tym LLaMA2, Phi 4, Mistral i Gemma 2Pozwól użytkownikom tworzyć i udostępniać własne LLMPakuj wagi modeli, konfiguracje i dane w jeden pakietOptymalizuj ustawienia i szczegóły konfiguracji, w tym wykorzystanie GPU.

Wymagania dotyczące GPU i pamięci

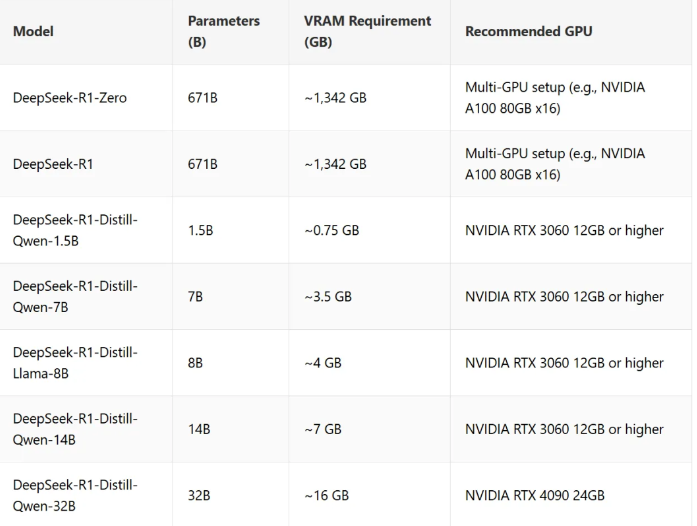

Wymagania dotyczące pamięci dla DeepSeek-R1 zależą od takich czynników, jak rozmiar modelu, liczba parametrów i technika kwantyzacji.

Poniżej znajduje się szczegółowy przegląd wymagań dotyczących pamięci dla DeepSeek-R1 i jego zredukowanego modelu, a także zalecanych procesorów graficznych:

Kluczowa uwaga dotycząca wykorzystania pamięci:

Rozproszona konfiguracja GPU dla dużych modeli: DeepSeek-R1-Zero i DeepSeek-R1 wymagają dużej ilości pamięci graficznej, a zatem rozproszonej konfiguracji GPU (np. NVIDIA A100 lub H100 w konfiguracji multi-GPU) dla optymalnej wydajności.

Modele Lite są zoptymalizowane do działania na jednym GPU z niższymi wymaganiami dotyczącymi pamięci graficznej, zaczynającymi się od 0,7 GB.

Dodatkowe zużycie pamięci: Aktywacja, bufory i zadania wsadowe mogą zużywać dodatkową pamięć.

Dlaczego warto działać lokalnie?

Internetowy chatbot i aplikacja mobilna DeepSeek są bezpłatne i bardzo wygodne. Nie trzeba przeprowadzać żadnej konfiguracji, a funkcje takie jak DeepThink i wyszukiwanie w sieci są wbudowane.

Jednak uruchomienie go lokalnie może być lepszą opcją z następujących powodów

Prywatność

Podczas korzystania z wersji internetowej lub aplikacji zapytania i wszelkie załączone pliki są wysyłane na serwery DeepSeek w celu przetworzenia. Co dzieje się z tymi danymi? Nie wiemy. Uruchamianie modelu lokalnie zapewnia, że dane pozostają na komputerze, zapewniając pełną kontrolę nad prywatnością.

Dostęp offline

Uruchamianie modelu lokalnie oznacza, że nie jest potrzebne połączenie z Internetem.

Jeśli podróżujesz, napotykasz niestabilną sieć Wi-Fi lub po prostu wolisz pracować w trybie offline, lokalna konfiguracja umożliwia korzystanie z DeepSeek w dowolnym miejscu i czasie.

Przyszłościowy

Obecnie usługi DeepSeek są bezpłatne, ale jest mało prawdopodobne, aby trwało to wiecznie. W pewnym momencie mogą one wymagać monetyzacji i mogą pojawić się ograniczenia użytkowania lub opłaty abonamentowe. Dzięki modelowi lokalnemu można całkowicie uniknąć tych ograniczeń.

Elastyczność

Dzięki wersji lokalnej nie jesteś ograniczony domyślnymi ustawieniami. Chcesz dopracować model?

Zintegrować go z innymi narzędziami? Zbudować niestandardowy interfejs? Otwarty charakter DeepSeek R1 oferuje nieograniczone możliwości.

Podsumowanie

W tej chwili nadal nie jest jasne, w jaki sposób DeepSeek obsługuje dane użytkowników.

Jeśli nie zależy ci na prywatności danych, lepszym wyborem może być korzystanie z aplikacji internetowych lub mobilnych. Są one łatwiejsze w użyciu i oferują takie funkcje jak DeepThink i wyszukiwanie w sieci.

Jeśli jednak zależy ci na tym, gdzie trafiają twoje dane, model lokalny jest dobrą alternatywą do rozważenia.

Model DeepSeek został zaprojektowany tak, aby działał dobrze nawet na sprzęcie, który nie jest szczególnie wydajny.

Podczas gdy większe modele, takie jak DeepSeek-R1-Zero, wymagają rozproszonej konfiguracji GPU, wersja lite umożliwia płynne działanie na pojedynczym GPU przy niższych wymaganiach dotyczących pamięci.