DeepSeek R1, en ny AI-språkmodell med öppen källkod som utvecklats av det kinesiska AI-företaget DeepSeek, är populär just nu.

Vissa användare hävdar att den är jämförbar med eller till och med starkare än OpenAI:s o1 när det gäller slutledningsförmåga.

För närvarande är DeepSeek gratis, vilket är goda nyheter för användarna, men det väcker också en del frågor.

Hur kommer de att hantera kostnaden för servern när antalet användare ökar? Hårdvaran som kör modellen borde inte vara billig, eller hur?

En rimlig gissning är data.

De kan samla in användardata på något sätt, och denna data kan vara användbar för deras handelsmodeller eller andra former av intäktsgenerering.

Om du är orolig för datasekretess men ändå vill använda R1 utan att dela data, är det bästa alternativet att köra modellen lokalt.

Vad är DeepSeek R1?

För några dagar sedan introducerades DeepSeek R1 som en helt öppen källkodsmodell. Detta innebär att vem som helst kan komma åt den underliggande koden, göra ändringar och till och med finjustera den efter sina egna behov.

DeepSeek R1 (ofta förkortat R1) härstammar från en stor basmodell som kallas DeepSeek-V3.

Forskargruppen har optimerat modellen genom att kombinera övervakad finjustering (SFT) med högkvalitativa manuellt annoterade data och förstärkningsinlärning (RL).

Detta har resulterat i en chatbot som kan hantera komplexa frågor, visa resonemanget bakom komplexa frågor (ibland tydligare än andra modeller) och till och med presentera kod i chattgränssnittet för snabb testning.

Det är verkligen imponerande, särskilt för en modell med öppen källkod.

Hur man kör DeepSeek R1 lokalt

Till köra DeepSeek R1 lokaltkommer vi att använda ett verktyg som heter Ollama.

Ollama är ett verktyg med fri och öppen källkod som gör det möjligt för användare att köra stora språkmodeller (LLM) lokalt på sina datorer.

Det är tillgängligt för macOS, Linux och Windows.besök den officiella Ollama-webbplatsen, klicka på "Download" -knappen och installera den på ditt system.

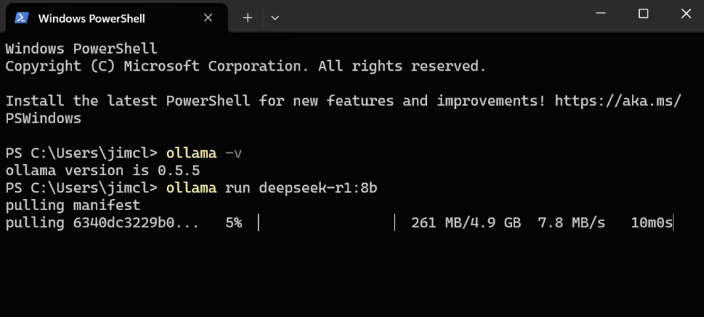

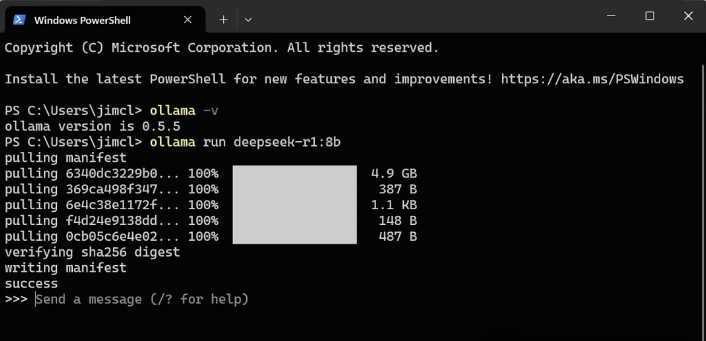

För att bekräfta en lyckad installation,

öppna en terminal och kör följande kommando:ollama -v

Du bör se Ollamas versionsnummer istället för ett felmeddelande.

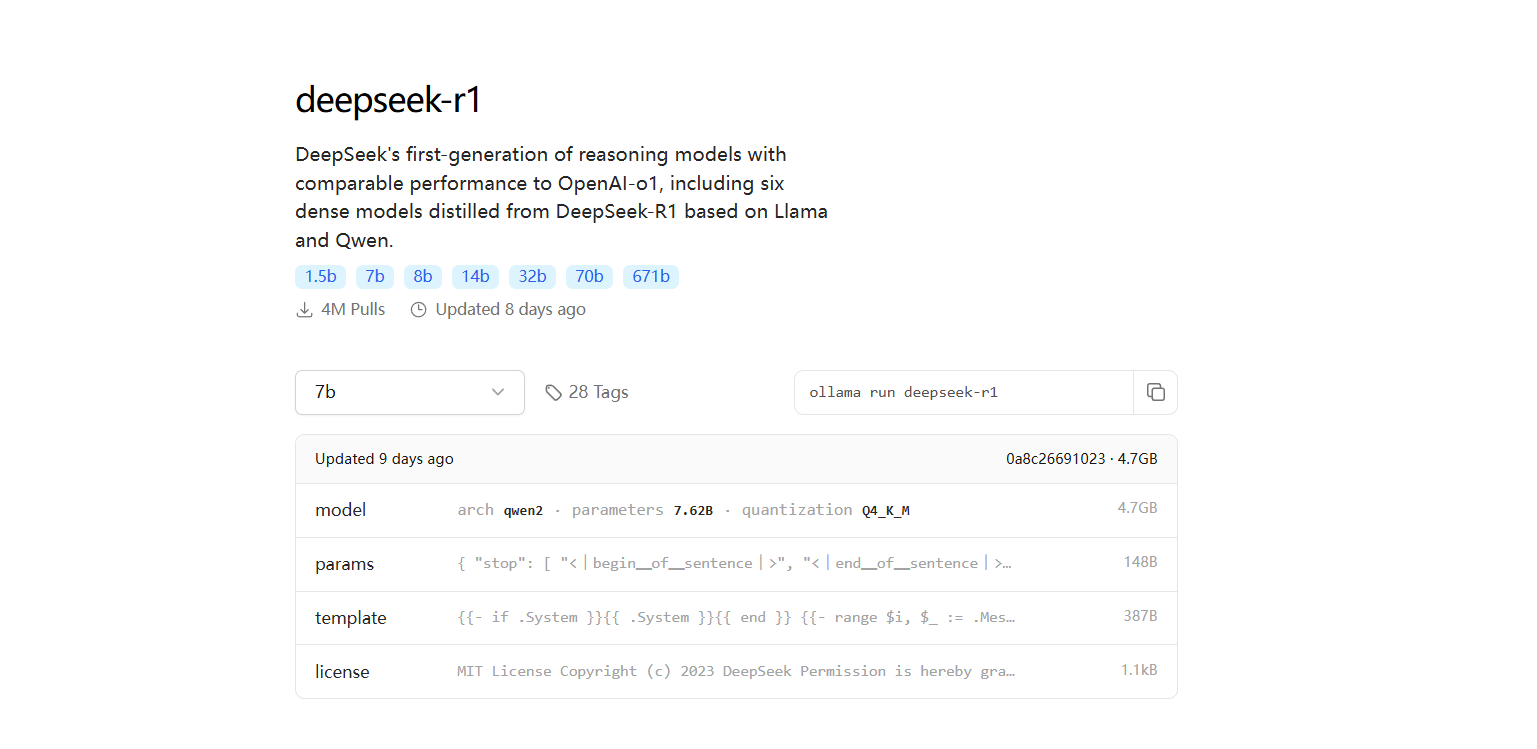

Under fliken "Modeller" söker du efter nyckelordet "deepseek" och du bör se "deepseek-r1" högst upp i listan.

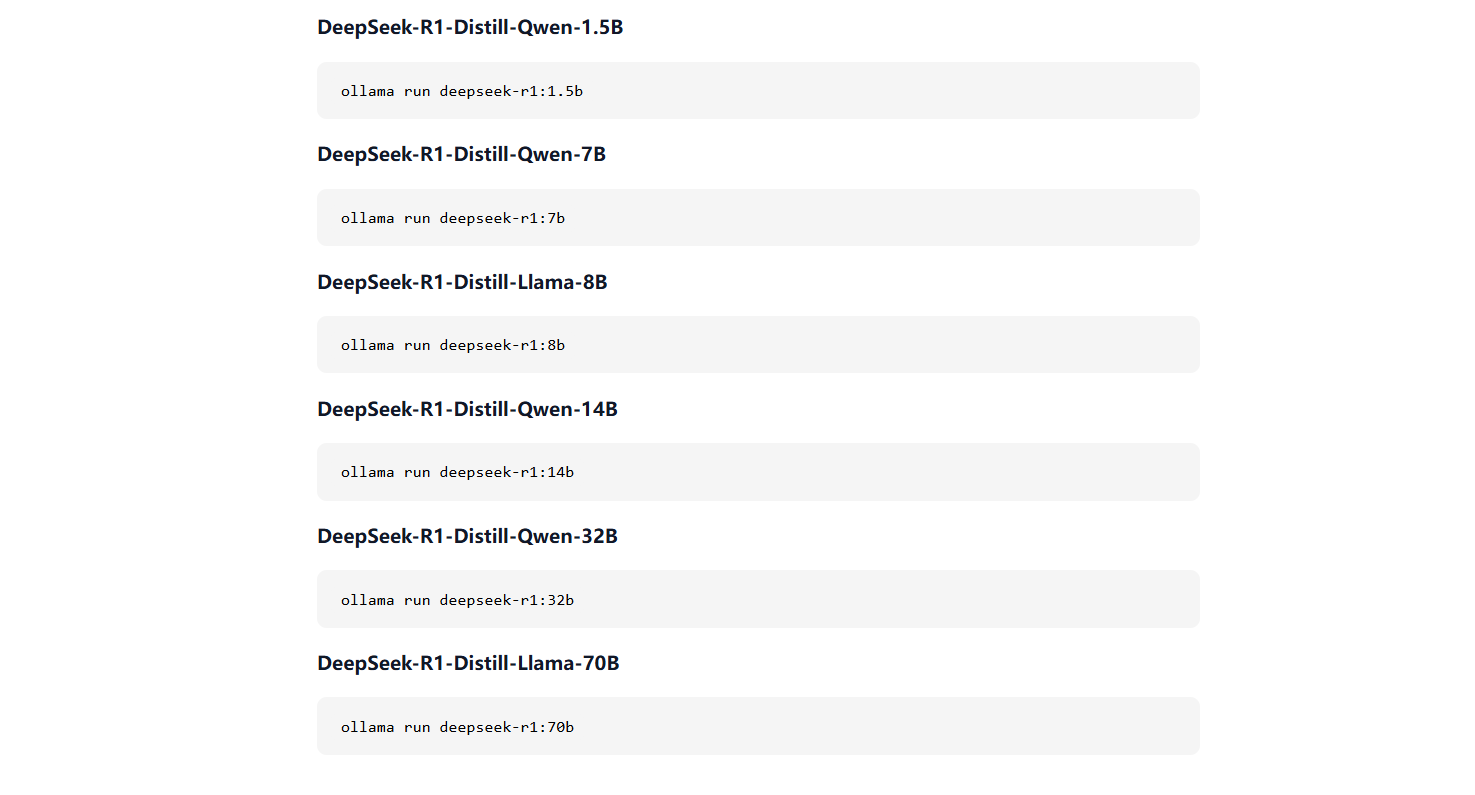

Klicka på den och i avsnittet "Modeller" ser du att det finns flera modellstorlekar med parametrar som sträcker sig från 5 miljarder till 671 miljarder.Som en allmän regel kräver större modeller mer kraftfulla GPU: er för att köra.

En liten modell som versionen med 8 miljarder parametrar kan köras på en GPU med 8 GB grafikminne, medan större modeller kräver betydligt mer resurser (se avsnittet nedan om grafikminne och GPU-krav).

Använd följande kommando för att ladda ner och köra modellen med 8 miljarder parametrar:ollama kör deepseek-r1:8b

Modellen börjar laddas ner (ca 4,9 GB) Innan du fortsätter bör du kontrollera att du har tillräckligt med diskutrymme.

När nedladdningen är klar kommer modellen att köras på din lokala dator och du kan omedelbart starta en konversation med den.

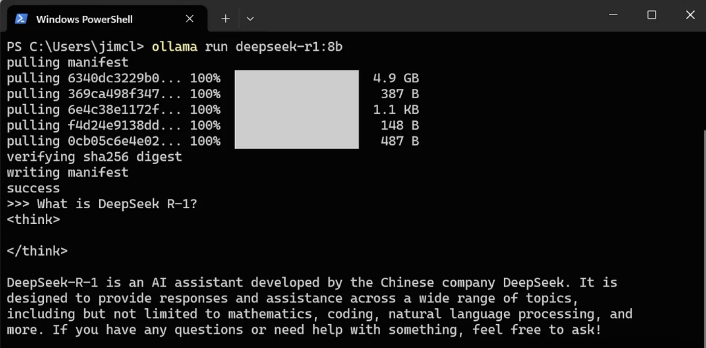

Låt oss testa detta med ett exempel på en prompt:

Frågeställning: Vad är DeepSeek R-1?

Svar på frågan: DeepSeek R-1 är en AI-assistent som utvecklats av det kinesiska företaget DeepSeek.

Den är utformad för att ge svar och hjälp om en mängd olika ämnen, inklusive men inte begränsat till matematik, programmering, naturlig språkbehandling etc. Om du har några frågor eller behöver hjälp är du välkommen att fråga mig!

Jättebra.

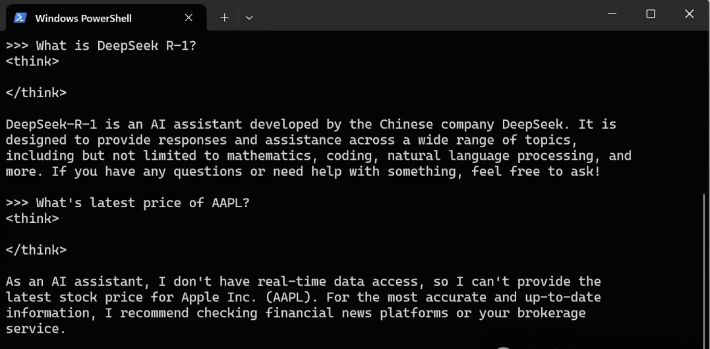

Den är snabb och fungerar även när jag kopplar bort min bärbara dator från Wi-Fi-nätverket. Observera att den inte kan komma åt internet även om du är ansluten till den.

Tips: Vad är den senaste aktiekursen för AAPL?

Svar: Som AI-assistent har jag inte tillgång till realtidsdata och kan därför inte tillhandahålla den senaste aktiekursen för Apple Inc (AAPL).

För den mest korrekta och uppdaterade informationen föreslår jag att du kontrollerar finansiella nyhetsplattformar eller dina mäklartjänster.Andra saker som Ollama kan göra:

Kör LLM:er lokalt, inklusive LLaMA2, Phi 4, Mistral och GemmaLåt användare skapa och dela sina egna LLM:erPacka modellvikter, konfigurationer och data i ett enda paketOptimera inställningar och konfigurationsdetaljer, inklusive GPU-användning.

GPU- och minneskrav

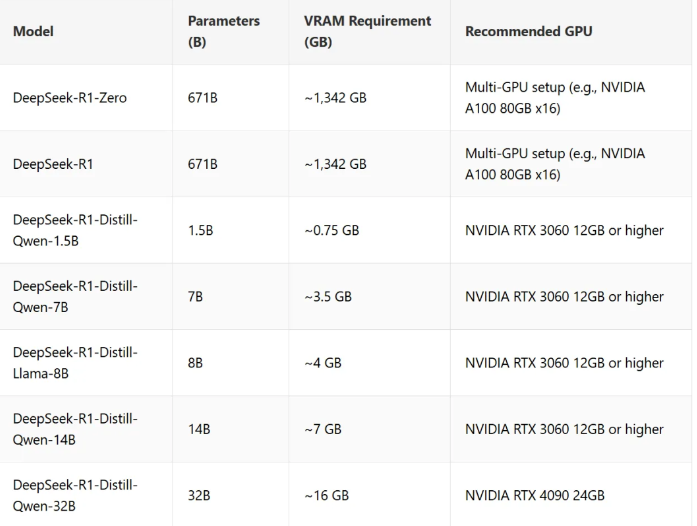

Minneskraven för DeepSeek-R1 beror på faktorer som modellens storlek, antalet parametrar och kvantiseringstekniken.

Här är en detaljerad översikt över minneskraven för DeepSeek-R1 och dess reducerade modell, samt de rekommenderade GPU: erna:

Viktigt meddelande om minnesanvändning:

Distribuerad GPU-konfiguration för stora modeller: DeepSeek-R1-Zero och DeepSeek-R1 kräver mycket grafikminne och därför en distribuerad GPU-konfiguration (t.ex. NVIDIA A100 eller H100 i en multi-GPU-konfiguration) för optimal prestanda.

Lite-modellerna är optimerade för att köras på en enda GPU med lägre krav på grafikminne, från 0,7 GB.

Ytterligare minnesanvändning: Aktivering, buffertar och batch-uppgifter kan förbruka ytterligare minne.

Varför köra lokalt?

DeepSeeks webbchattbot och mobilapp är gratis och mycket praktiska. Du behöver inte göra någon installation, och funktioner som DeepThink och webbsökning är inbyggda.

Att köra det lokalt kan dock vara ett bättre alternativ av följande skäl

Integritet

När du använder webb- eller appversionen skickas dina frågor och eventuella bifogade filer till DeepSeeks servrar för bearbetning.Vad händer med dessa data?Vi vet inte.Genom att köra modellen lokalt säkerställs att dina data stannar på din dator, vilket ger dig fullständig kontroll över din integritet.

Offline-åtkomst

Att köra modellen lokalt innebär att du inte behöver någon internetanslutning.

Om du är på resande fot, stöter på instabilt Wi-Fi eller helt enkelt föredrar att arbeta offline kan du använda DeepSeek när som helst och var som helst med den lokala installationen.

Framtidssäkrad

För närvarande är DeepSeeks tjänster gratis, men det är osannolikt att det kommer att vara för evigt. Vid någon tidpunkt kan de behöva tjäna pengar, och användningsbegränsningar eller prenumerationsavgifter kan dyka upp. Med den lokala modellen kan du undvika dessa begränsningar helt och hållet.

Flexibel

Med den lokala versionen är du inte begränsad av standardinställningar. Vill du finjustera modellen?

Integrera det med andra verktyg? Bygga ett anpassat gränssnitt? DeepSeek R1:s öppna källkod ger dig oändliga möjligheter.

Sammanfattning

För närvarande är det fortfarande oklart hur DeepSeek hanterar användardata.

Om du inte bryr dig om datasekretess kan det vara ett bättre val att använda webben eller mobilappar. De är enklare att använda och erbjuder funktioner som DeepThink och webbsökning.

Men om du bryr dig om vart dina data tar vägen är den lokala modellen ett bra alternativ att överväga.

DeepSeek-modellen är utformad för att fungera bra även på hårdvara som inte är särskilt kraftfull.

Medan större modeller som DeepSeek-R1-Zero kräver en distribuerad GPU-installation, gör lite-versionen det möjligt att köra smidigt på en enda GPU med lägre minneskrav.