DeepSeek R1um novo modelo de linguagem de IA de código aberto desenvolvido pela empresa chinesa de IA DeepSeek, está em alta no momento.

Alguns usuários afirmam que ele é comparável ou até mais forte do que o o1 da OpenAI em termos de recursos de inferência.

Atualmente, o DeepSeek é gratuito, o que é uma boa notícia para os usuários, mas também levanta algumas questões.

Como eles lidarão com o custo do servidor à medida que o número de usuários aumentar? O hardware que executa o modelo não deve ser barato, certo?

Um palpite razoável são os dados.

Os dados são a força vital dos modelos de IA, que podem coletar dados de usuários de alguma forma, e esses dados podem ser úteis para seus modelos de negociação ou outras formas de monetização.

Se você estiver preocupado com a privacidade dos dados, mas ainda quiser usar o R1 sem compartilhar dados, a melhor opção é executar o modelo localmente.

O que é DeepSeek R1?

Há alguns dias, o DeepSeek R1 foi apresentado como um modelo de código-fonte totalmente aberto. Isso significa que qualquer pessoa pode acessar seu código subjacente, fazer modificações e até mesmo ajustá-lo às suas próprias necessidades.

O DeepSeek R1 (geralmente abreviado como R1) é derivado de um modelo de base grande chamado DeepSeek-V3.

A equipe de pesquisa otimizou esse modelo combinando o ajuste fino supervisionado (SFT) com dados anotados manualmente de alta qualidade e aprendizagem por reforço (RL).

Isso resultou em um chatbot que pode lidar com solicitações complexas, mostrar o raciocínio por trás de perguntas complexas (às vezes, mais claramente do que outros modelos) e até mesmo apresentar código na interface de bate-papo para testes rápidos.

É realmente impressionante, especialmente para um modelo de código aberto.

Como executar o DeepSeek R1 localmente

Para executar o DeepSeek R1 localmentePara isso, usaremos uma ferramenta chamada Ollama.

O Ollama é uma ferramenta gratuita e de código aberto que permite que os usuários executem grandes modelos de linguagem (LLMs) localmente em seus computadores.

Ele está disponível para macOS, Linux e Windows. Visite o site oficial do Ollama, clique no botão "Download" e instale-o em seu sistema.

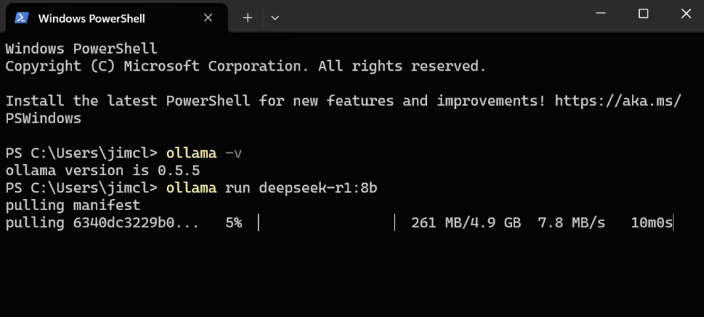

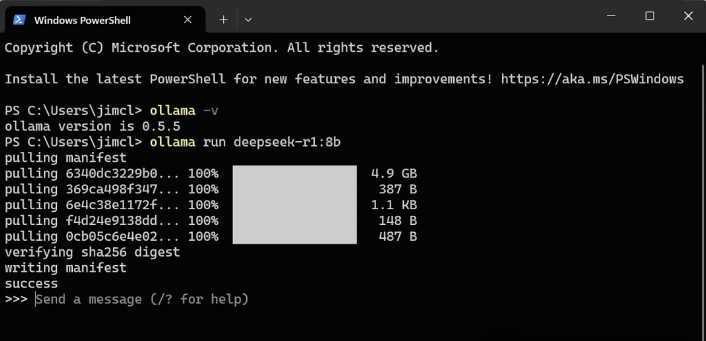

Para confirmar o sucesso da instalação,

abra um terminal e execute o seguinte comando: ollama -v

Você deverá ver o número da versão do Ollama em vez de uma mensagem de erro.

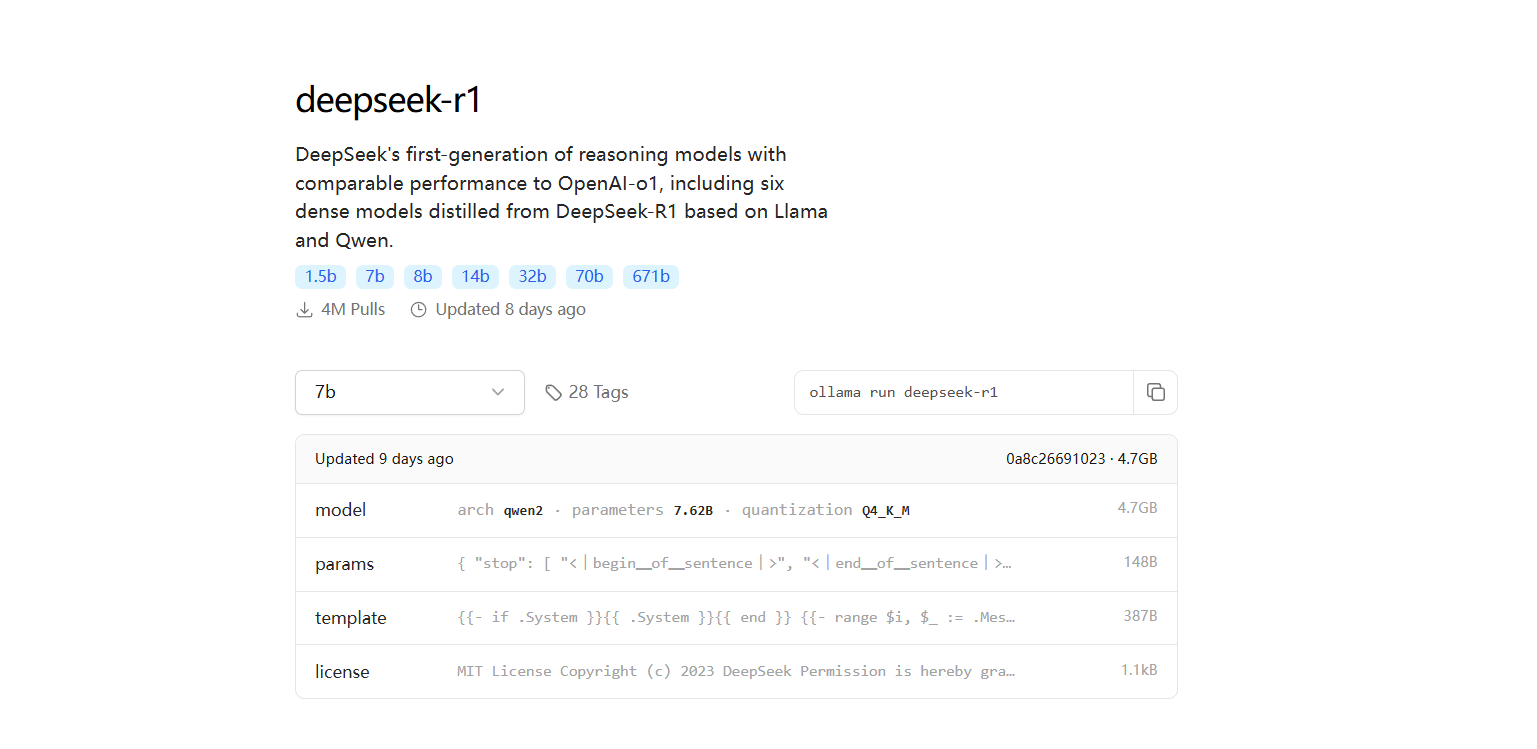

Na guia "Models" (Modelos), pesquise a palavra-chave "deepseek" e você verá "deepseek-r1" no topo da lista.

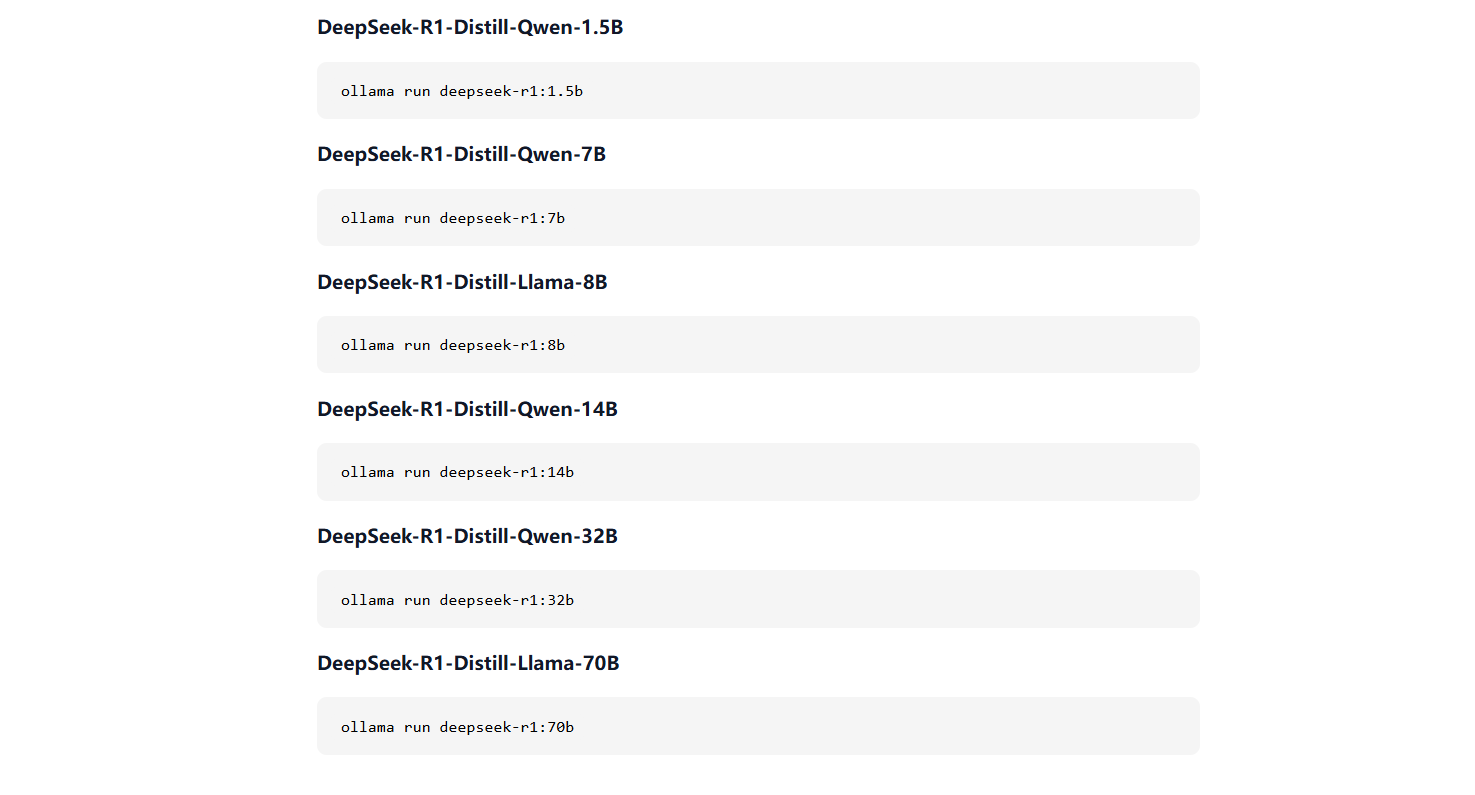

Clique nele e, na seção "Models" (Modelos), você verá que há vários tamanhos de modelos com parâmetros que variam de 5 bilhões a 671 bilhões. Como regra geral, modelos maiores exigem GPUs mais potentes para serem executados.

Um modelo pequeno, como a versão de 8 bilhões de parâmetros, pode ser executado em uma GPU com 8 GB de memória gráfica, enquanto modelos maiores exigem muito mais recursos (consulte a seção abaixo sobre requisitos de memória gráfica e GPU).

Para fazer download e executar o modelo de 8 bilhões de parâmetros, use o seguinte comando:ollama run deepseek-r1:8b

O download do modelo será iniciado (aproximadamente 4,9 GB). Antes de continuar, verifique se você tem espaço suficiente em disco.

Após a conclusão do download, o modelo será executado em seu computador local, e você poderá iniciar uma conversa com ele imediatamente.

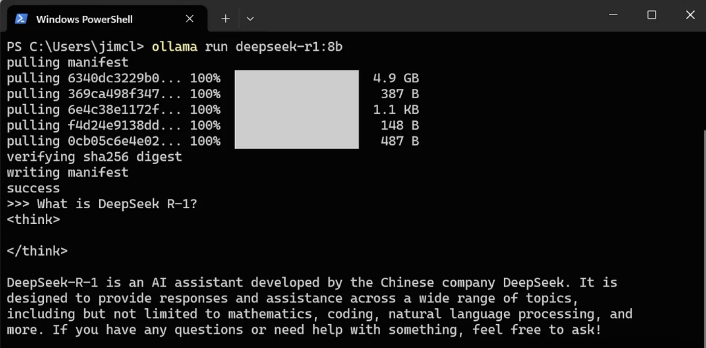

Vamos testar isso com um prompt de amostra:

Prompt: O que é o DeepSeek R-1?

Resposta: O DeepSeek R-1 é um assistente de IA desenvolvido pela empresa chinesa DeepSeek.

Ele foi projetado para fornecer respostas e ajuda em uma variedade de tópicos, incluindo, entre outros, matemática, programação, processamento de linguagem natural, etc. Se você tiver alguma dúvida ou precisar de ajuda, fique à vontade para me perguntar!

Excelente.

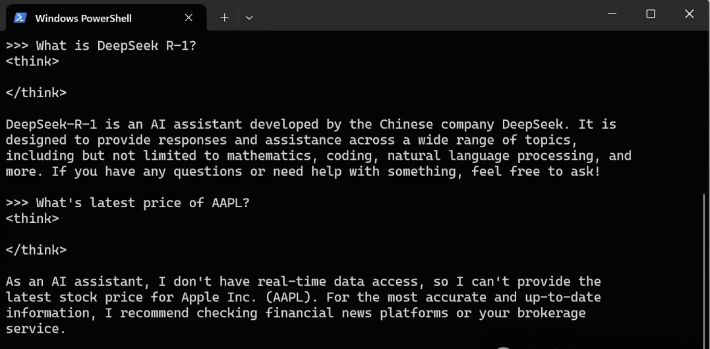

Ele é rápido e funciona mesmo quando desconecto meu laptop da rede Wi-Fi. Observe que ele não pode acessar a Internet mesmo que você esteja conectado a ele.

Dica: qual é o preço mais recente das ações da AAPL?

Resposta: Como um assistente de IA, não posso acessar dados em tempo real e, portanto, não posso fornecer o preço mais recente das ações da Apple Inc. (AAPL).

Para obter as informações mais precisas e atualizadas, sugiro que você consulte as plataformas de notícias financeiras ou seus serviços de corretagem:

Execute LLMs localmente, incluindo LLaMA2, Phi 4, Mistral e Gemma 2Permita que os usuários criem e compartilhem seus próprios LLMsPacote pesos de modelos, configurações e dados em um único pacoteOtimize as definições e os detalhes de configuração, incluindo o uso da GPU.

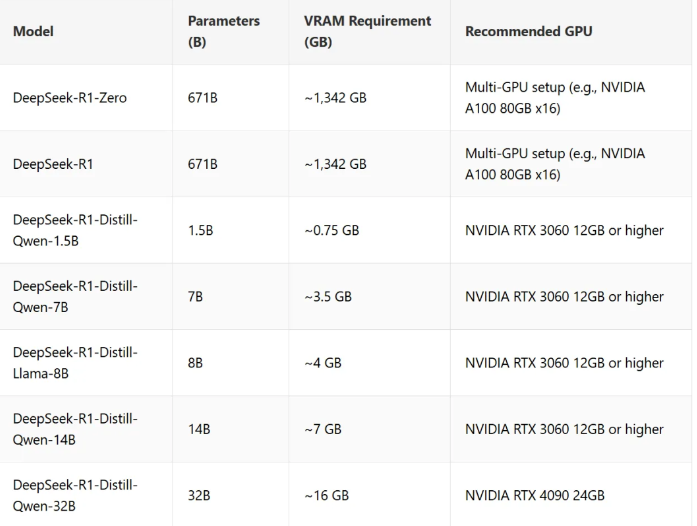

Requisitos de GPU e memória

Os requisitos de memória do DeepSeek-R1 dependem de fatores como o tamanho do modelo, o número de parâmetros e a técnica de quantização.

Aqui está uma visão geral detalhada dos requisitos de memória para o DeepSeek-R1 e seu modelo reduzido, bem como as GPUs recomendadas:

Observação importante sobre o uso da memória:

Configuração de GPU distribuída para modelos grandes: O DeepSeek-R1-Zero e o DeepSeek-R1 exigem muita memória gráfica e, portanto, uma configuração de GPU distribuída (por exemplo, NVIDIA A100 ou H100 em uma configuração de várias GPUs) para obter o desempenho ideal.

Os modelos Lite são otimizados para serem executados em uma única GPU com requisitos de memória gráfica mais baixos, a partir de 0,7 GB.

Uso adicional de memória: A ativação, os buffers e as tarefas em lote podem consumir memória adicional.

Por que executar localmente?

O chatbot da Web e o aplicativo móvel do DeepSeek são gratuitos e muito convenientes. Você não precisa fazer nenhuma configuração, e recursos como o DeepThink e a pesquisa na Web estão incorporados.

Entretanto, executá-lo localmente pode ser uma opção melhor pelos seguintes motivos

Privacidade

Quando você usa a versão da Web ou do aplicativo, suas consultas e todos os arquivos anexados são enviados aos servidores do DeepSeek para processamento. O que acontece com esses dados? Não sabemos. Executar o modelo localmente garante que seus dados permaneçam em seu computador, dando-lhe controle total sobre sua privacidade.

Acesso off-line

Executar o modelo localmente significa que você não precisa de uma conexão com a Internet.

Se estiver viajando, encontrando uma rede Wi-Fi instável ou simplesmente preferindo trabalhar off-line, a configuração local permite que você use o DeepSeek a qualquer hora e em qualquer lugar.

Preparado para o futuro

Atualmente, os serviços do DeepSeek são gratuitos, mas é improvável que isso dure para sempre. Em algum momento, eles podem precisar ser monetizados, e restrições de uso ou taxas de assinatura podem aparecer. Com o modelo local, você pode evitar totalmente essas restrições.

Flexível

Com a versão local, você não está limitado pelas configurações padrão.

Integrá-lo com outras ferramentas? Crie uma interface personalizada... A natureza de código aberto do DeepSeek R1 lhe oferece infinitas possibilidades.

Resumo

No momento, ainda não está claro como o DeepSeek lida com os dados do usuário.

Se você não se importa com a privacidade dos dados, usar a Web ou aplicativos móveis pode ser uma opção melhor. Eles são mais fáceis de usar e oferecem recursos como o DeepThink e a pesquisa na Web.

Mas se você se preocupa com o destino de seus dados, o modelo local é uma boa alternativa a ser considerada.

O modelo DeepSeek foi projetado para funcionar bem mesmo em um hardware que não seja particularmente potente.

Embora modelos maiores, como o DeepSeek-R1-Zero, exijam uma configuração de GPU distribuída, a versão lite possibilita a execução sem problemas em uma única GPU com requisitos de memória menores.