DeepSeek R1Сейчас популярна новая языковая модель ИИ с открытым исходным кодом, разработанная китайской компанией DeepSeek.

Некоторые пользователи утверждают, что по возможностям умозаключений он сравним или даже превосходит o1 от OpenAI.

В настоящее время DeepSeek бесплатен, что является хорошей новостью для пользователей, но также вызывает некоторые вопросы.

Как они будут справляться с расходами на сервер по мере увеличения числа пользователей? Оборудование, на котором работает модель, не должно быть дешевым, верно?

Одно из разумных предположений - это данные.

Данные - жизненная сила моделей ИИ. Они могут собирать данные о пользователях, и эти данные могут быть полезны для их торговых моделей или других форм монетизации.

Если вы беспокоитесь о конфиденциальности данных, но при этом хотите использовать R1 без обмена данными, лучший вариант - запустить модель локально.

Что такое DeepSeek R1?

Несколько дней назад DeepSeek R1 был представлен как модель с полностью открытым исходным кодом. Это означает, что любой желающий может получить доступ к ее базовому коду, вносить изменения и даже настраивать ее под свои нужды.

DeepSeek R1 (часто сокращенно R1) является производной от большой базовой модели под названием DeepSeek-V3.

Исследовательская группа оптимизировала эту модель, сочетая контролируемую тонкую настройку (SFT) с высококачественными аннотированными вручную данными и обучением с подкреплением (RL).

В результате появился чатбот, который может обрабатывать сложные запросы, показывать обоснование сложных вопросов (иногда более наглядно, чем другие модели) и даже представлять код в интерфейсе чата для быстрого тестирования.

Это действительно впечатляет, особенно для модели с открытым исходным кодом.

Как запустить DeepSeek R1 локально

На Запустите DeepSeek R1 локальноМы будем использовать инструмент под названием Ollama.

Ollama - это бесплатный инструмент с открытым исходным кодом, который позволяет пользователям запускать большие языковые модели (LLM) локально на своих компьютерах.

Она доступна для macOS, Linux и Windows. Посетите официальный сайт Ollama, нажмите кнопку "Загрузить" и установите ее на свою систему.

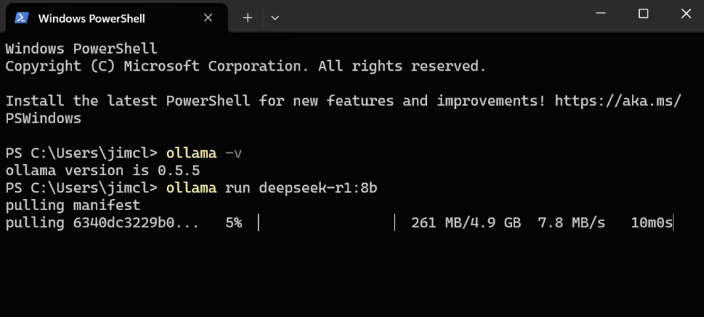

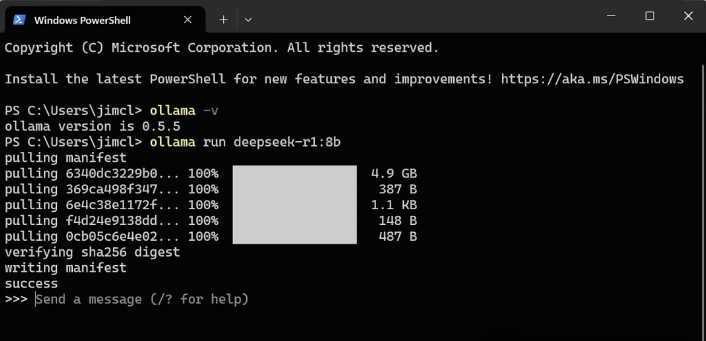

Чтобы подтвердить успешную установку,

откройте терминал и выполните следующую команду:ollama -v

Вместо сообщения об ошибке вы должны увидеть номер версии Ollama.

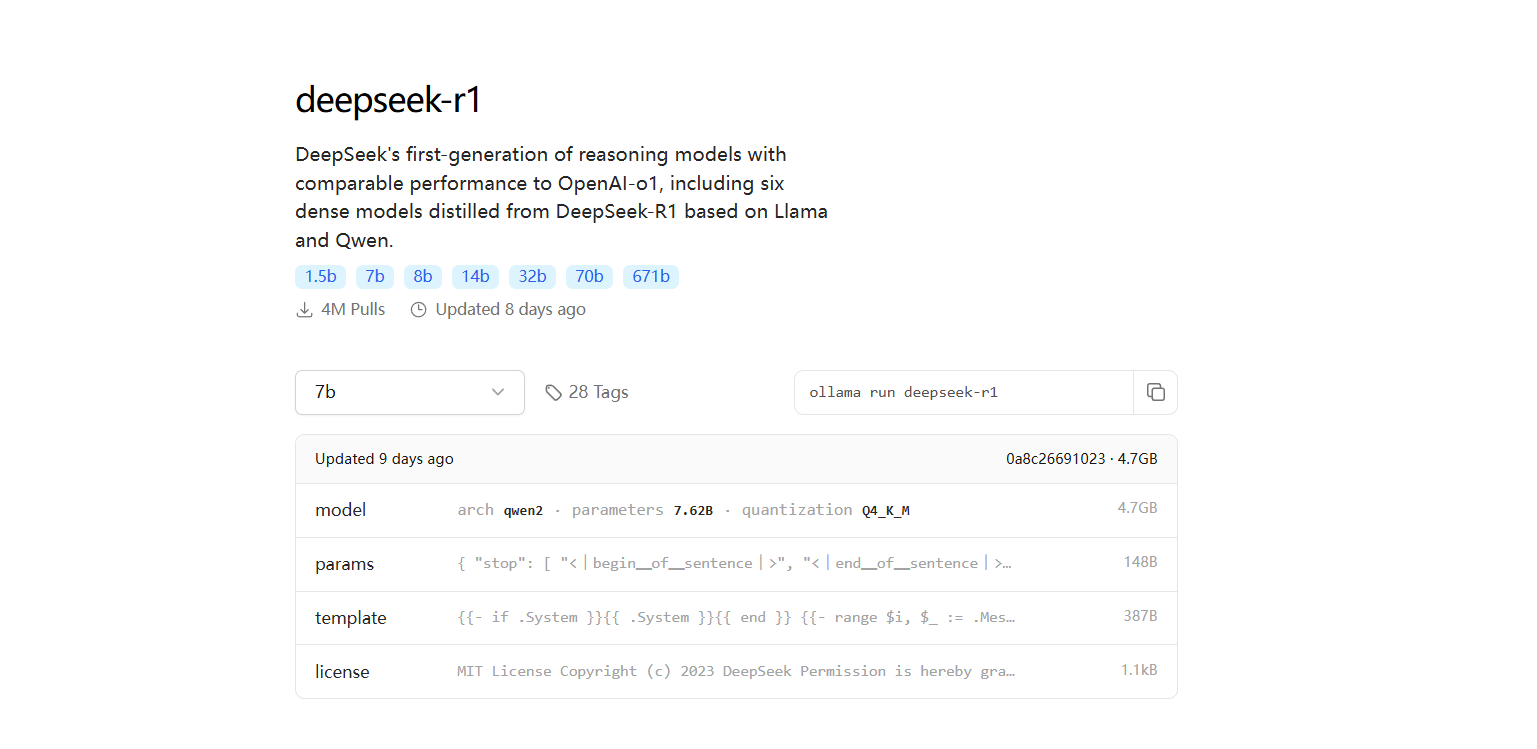

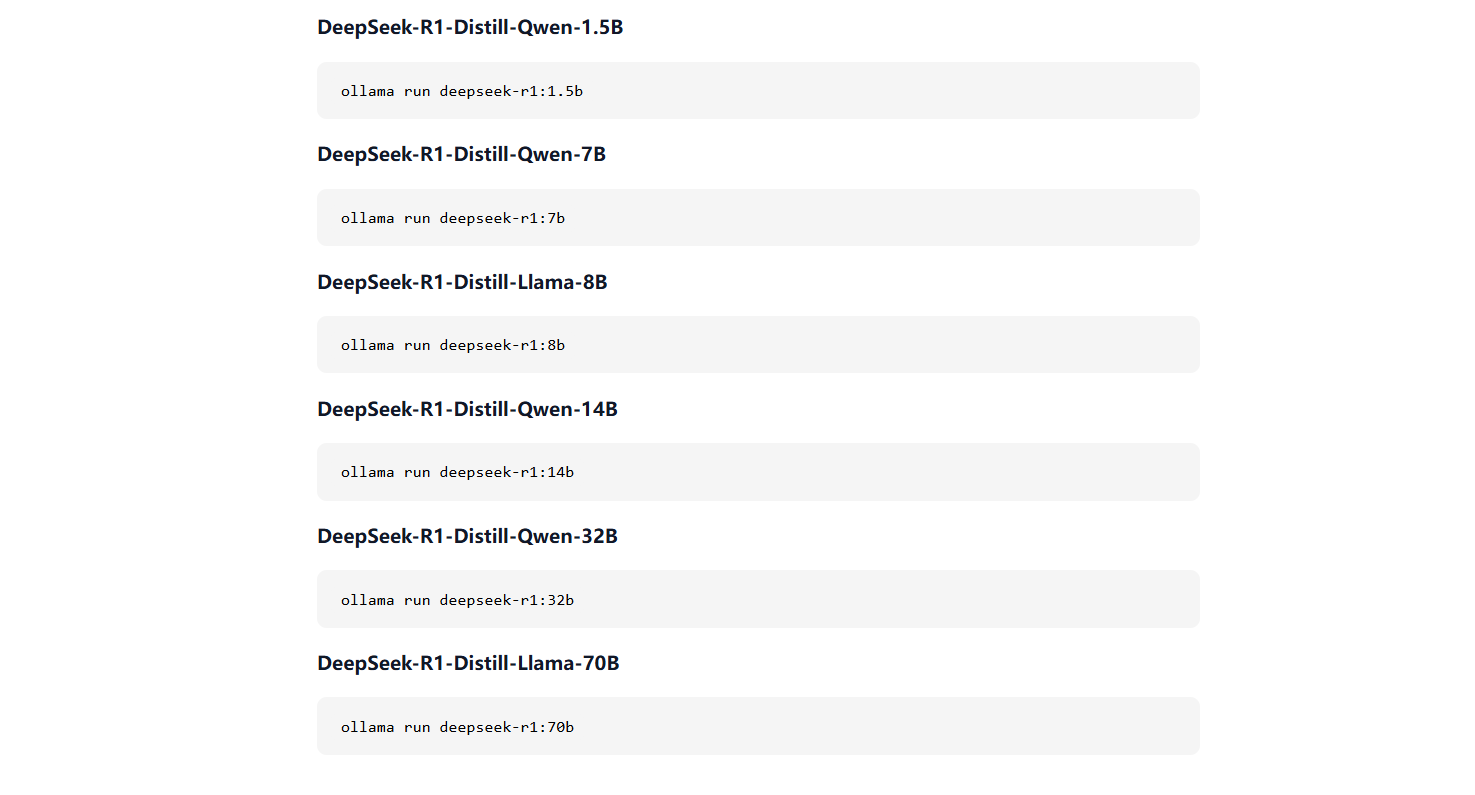

На вкладке "Модели" выполните поиск по ключевому слову "deepseek", и вы увидите "deepseek-r1" в верхней части списка.

Нажмите на него, и в разделе "Модели" вы увидите, что есть несколько размеров моделей с параметрами от 5 млрд до 671 млрд. Как правило, для запуска больших моделей требуются более мощные графические процессоры.

Небольшая модель, например версия с 8 миллиардами параметров, может работать на GPU с 8 ГБ графической памяти, в то время как более крупные модели требуют значительно больше ресурсов (см. раздел ниже о графической памяти и требованиях к GPU).

Чтобы загрузить и запустить модель с 8 миллиардами параметров, выполните следующую команду:Оллама бежит в глубину - r1:8b

Начнется загрузка модели (около 4,9 ГБ). Прежде чем приступить к работе, убедитесь, что на диске достаточно места.

После завершения загрузки модель будет запущена на вашем локальном компьютере, и вы сможете сразу же начать с ней разговор.

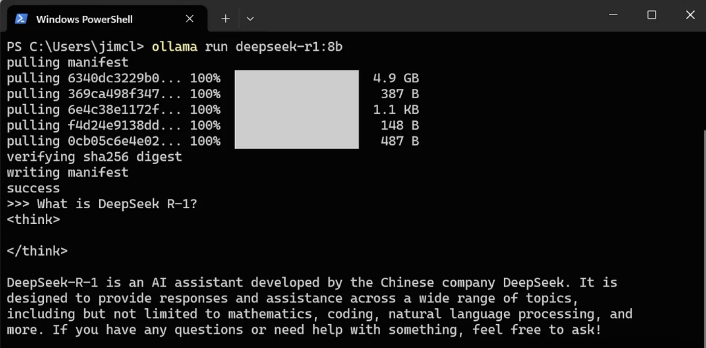

Давайте проверим это на примере запроса:

Примета: Что такое DeepSeek R-1?

Отзыв: DeepSeek R-1 - это ИИ-помощник, разработанный китайской компанией DeepSeek.

Он предназначен для предоставления ответов и помощи по различным темам, включая, но не ограничиваясь математикой, программированием, обработкой естественного языка и т.д. Если у вас есть вопросы или вам нужна помощь, не стесняйтесь спрашивать меня!

Отлично.

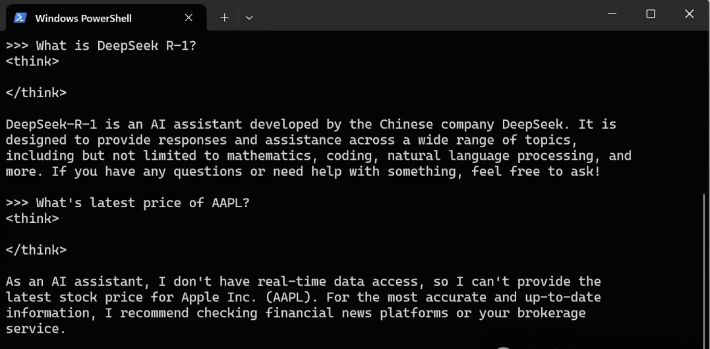

Он работает быстро и даже когда я отключаю свой ноутбук от сети Wi-Fi. Обратите внимание, что он не может получить доступ к Интернету, даже если вы подключены к нему.

Совет: Какова последняя цена акций AAPL?

Ответ: Как помощник с искусственным интеллектом, я не могу получить доступ к данным в режиме реального времени и поэтому не могу предоставить последнюю информацию о цене акций Apple Inc. (AAPL).

Для получения наиболее точной и актуальной информации я рекомендую вам проверять финансовые новостные платформы или брокерские услуги.Другие вещи, которые может сделать Ollama:

Локальный запуск LLM, включая LLaMA2, Phi 4, Mistral и Gemma 2Позволяет пользователям создавать собственные LLM и обмениваться имиПакетируйте веса моделей, конфигурации и данные в единый пакетОптимизируйте параметры и детали конфигурации, включая использование GPU.

Требования к графическому процессору и памяти

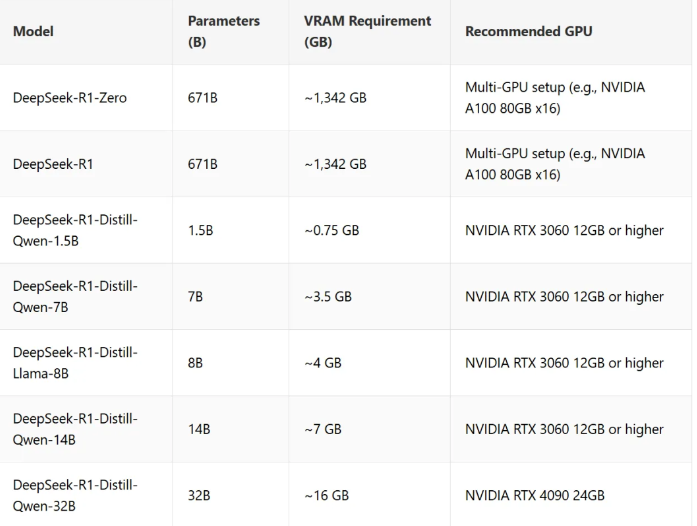

Требования к памяти для DeepSeek-R1 зависят от таких факторов, как размер модели, количество параметров и техника квантования.

Здесь представлен подробный обзор требований к памяти для DeepSeek-R1 и его уменьшенной модели, а также рекомендуемые графические процессоры:

Ключевое замечание по использованию памяти:

Распределенная конфигурация GPU для больших моделей: DeepSeek-R1-Zero и DeepSeek-R1 требуют большого объема графической памяти, поэтому для оптимальной производительности необходима распределенная конфигурация GPU (например, NVIDIA A100 или H100 в многопроцессорной системе).

Модели Lite оптимизированы для работы на одном GPU с меньшими требованиями к графической памяти, начиная с 0,7 ГБ.

Дополнительное использование памяти: Активация, буферы и пакетные задачи могут потреблять дополнительную память.

Зачем запускать локально?

Веб-чатбот и мобильное приложение DeepSeek бесплатны и очень удобны. Вам не нужно ничего настраивать, а такие функции, как DeepThink и веб-поиск, уже встроены.

Однако локальный запуск может оказаться лучшим вариантом по следующим причинам

Конфиденциальность

Когда вы используете веб-версию или приложение, ваши запросы и все прикрепленные файлы отправляются на серверы DeepSeek для обработки. Что происходит с этими данными? Мы не знаем. Запуск модели локально гарантирует, что ваши данные останутся на вашем компьютере, что дает вам полный контроль над конфиденциальностью.

Автономный доступ

Локальный запуск модели означает, что вам не нужно подключение к Интернету.

Если вы путешествуете, столкнулись с нестабильным Wi-Fi или просто предпочитаете работать в автономном режиме, локальная настройка позволит вам использовать DeepSeek в любое время и в любом месте.

Перспективный

В настоящее время сервисы DeepSeek бесплатны, но вряд ли это будет продолжаться вечно. В какой-то момент может потребоваться их монетизация, и тогда появятся ограничения на использование или абонентская плата. Локальная модель позволяет полностью избежать этих ограничений.

Гибкий

Локальная версия не ограничивает вас настройками по умолчанию. Хотите точно настроить модель?

Интегрировать его с другими инструментами? Создать собственный интерфейс? Открытый исходный код DeepSeek R1 открывает перед вами безграничные возможности.

Резюме

На данный момент пока неясно, как DeepSeek обрабатывает данные пользователей.

Если вы не заботитесь о конфиденциальности данных, лучшим выбором может стать использование веб-приложений или мобильных приложений. Они проще в использовании и предлагают такие функции, как DeepThink и веб-поиск.

Но если вам небезразлично, куда попадают ваши данные, локальная модель - хорошая альтернатива, которую стоит рассмотреть.

Модель DeepSeek разработана таким образом, чтобы хорошо работать даже на не слишком мощном оборудовании.

В то время как более крупные модели, такие как DeepSeek-R1-Zero, требуют установки распределенных GPU, lite-версия позволяет работать на одном GPU с меньшими требованиями к памяти.