DeepSeek R1en ny open source AI-sprogmodel udviklet af det kinesiske AI-firma DeepSeek, er populær lige nu.

Nogle brugere hævder, at den kan sammenlignes med eller endda er stærkere end OpenAI's o1 med hensyn til udledningsmuligheder.

I øjeblikket er DeepSeek gratis, hvilket er en god nyhed for brugerne, men det rejser også nogle spørgsmål.

Hvordan vil de håndtere omkostningerne til serveren, når antallet af brugere stiger? Hardwaren, der kører modellen, bør ikke være billig, vel?

Et rimeligt gæt er data.

De kan indsamle brugerdata på en eller anden måde, og disse data kan være nyttige for deres handelsmodeller eller andre former for indtægtsgenerering.

Hvis du er bekymret for datasikkerhed, men stadig vil bruge R1 uden at dele data, er den bedste løsning at køre modellen lokalt.

Hvad er DeepSeek R1?

For et par dage siden blev DeepSeek R1 introduceret som en fuldstændig open source-model. Det betyder, at alle kan få adgang til den underliggende kode, foretage ændringer og endda finjustere den til deres egne behov.

DeepSeek R1 (ofte forkortet R1) er afledt af en stor basismodel kaldet DeepSeek-V3.

Forskerteamet har optimeret denne model ved at kombinere superviseret finjustering (SFT) med manuelt kommenterede data af høj kvalitet og forstærkningslæring (RL).

Det har resulteret i en chatbot, der kan håndtere komplekse forespørgsler, vise ræsonnementet bag komplekse spørgsmål (nogle gange tydeligere end andre modeller) og endda præsentere kode i chatgrænsefladen til hurtig testning.

Det er virkelig imponerende, især for en open source-model.

Sådan kører du DeepSeek R1 lokalt

Til kør DeepSeek R1 lokaltvil vi bruge et værktøj, der hedder Ollama.

Ollama er et gratis og open source-værktøj, der giver brugerne mulighed for at køre store sprogmodeller (LLM'er) lokalt på deres computere.

Det er tilgængeligt til macOS, Linux og Windows. Besøg det officielle Ollama-websted, klik på knappen "Download", og installer det på dit system.

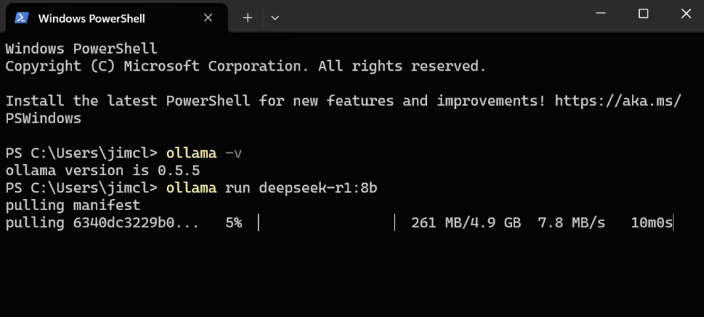

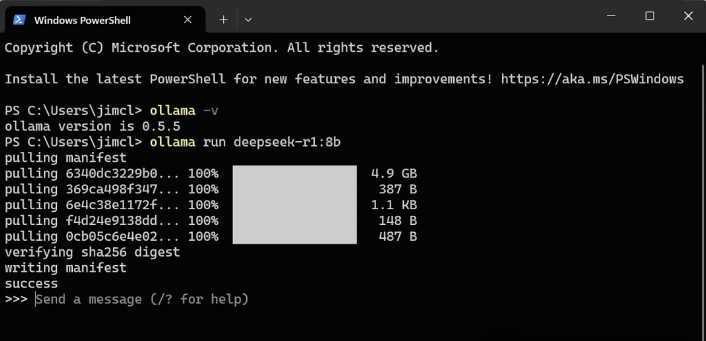

For at bekræfte en vellykket installation,

Åbn en terminal, og kør følgende kommando:ollama -v

Du bør se Ollamas versionsnummer i stedet for en fejlmeddelelse.

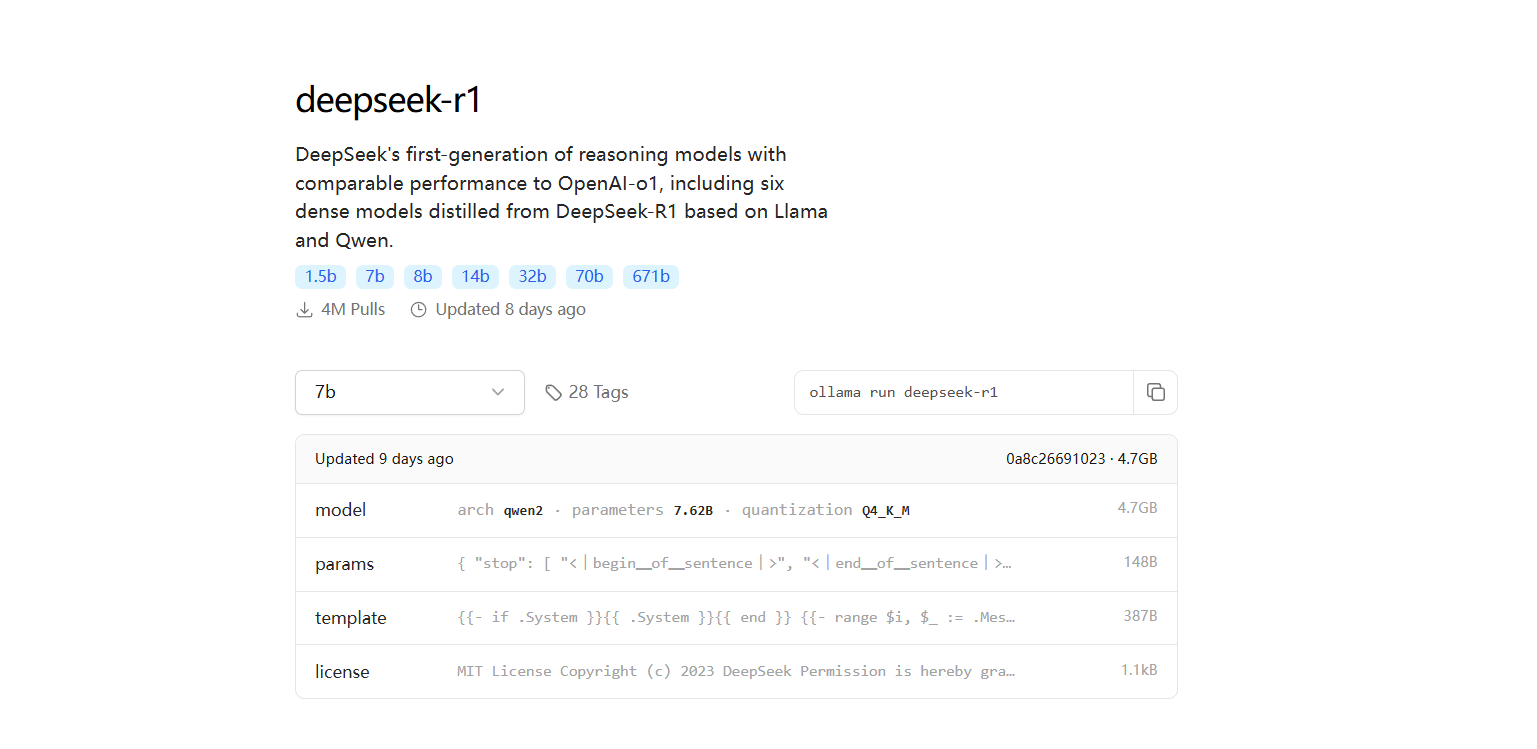

Under fanen "Modeller" skal du søge efter nøgleordet "deepseek", og du bør se "deepseek-r1" øverst på listen.

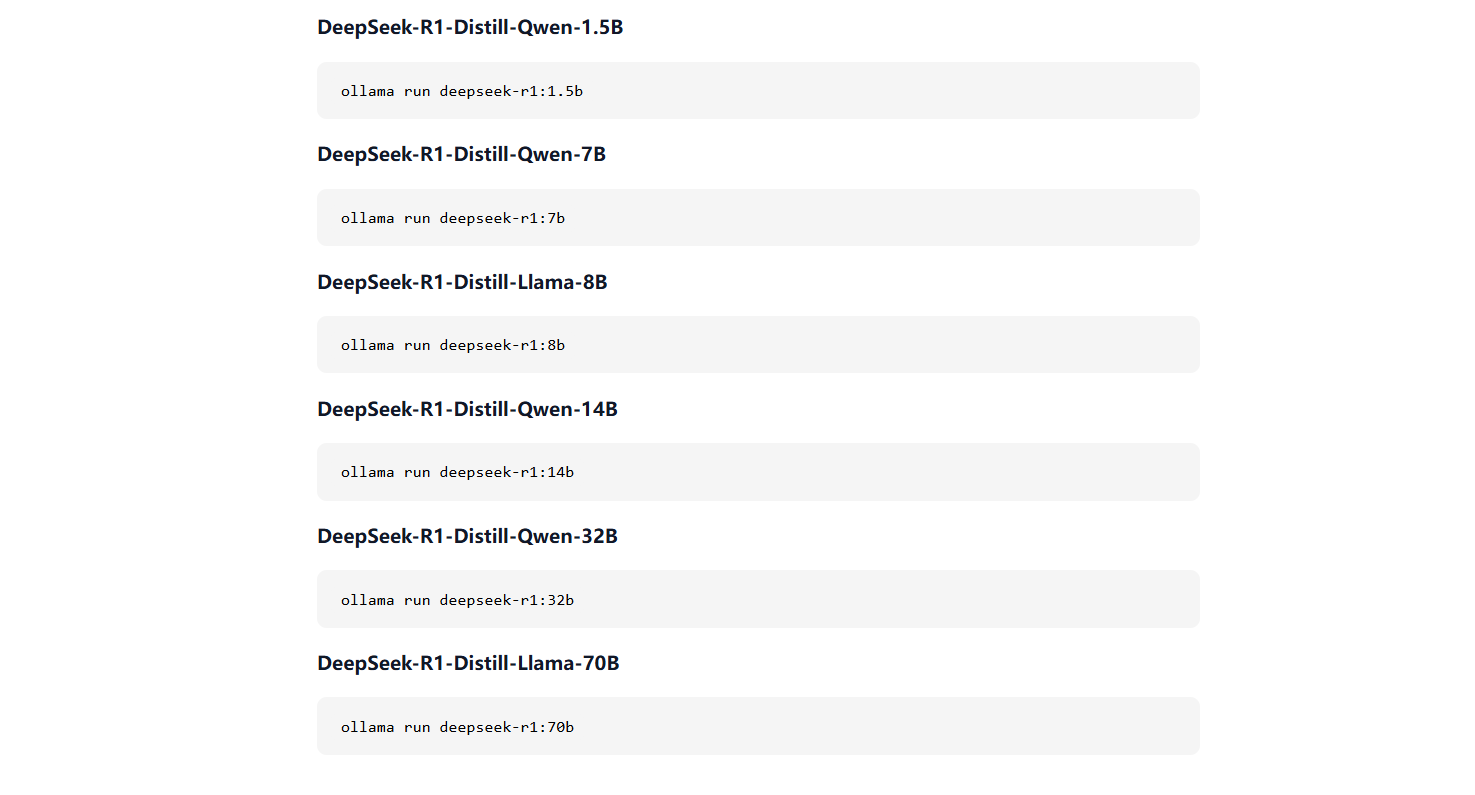

Klik på den, og i afsnittet "Modeller" vil du se, at der er flere modelstørrelser med parametre fra 5 milliarder til 671 milliarder. Som en generel regel kræver større modeller kraftigere GPU'er for at køre.

En lille model som versionen med 8 milliarder parametre kan køre på en GPU med 8 GB grafikhukommelse, mens større modeller kræver betydeligt flere ressourcer (se afsnittet nedenfor om grafikhukommelse og GPU-krav).

Brug følgende kommando til at downloade og køre modellen med 8 milliarder parametre:ollama kører deepseek-r1:8b

Modellen begynder at downloade (ca. 4,9 GB), og før du fortsætter, skal du sikre dig, at du har tilstrækkelig diskplads.

Når downloadet er færdigt, kører modellen på din lokale computer, og du kan starte en samtale med den med det samme.

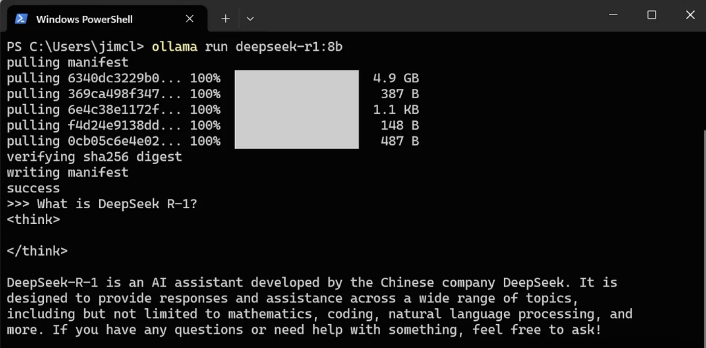

Lad os teste det med et eksempel på en prompt:

Spørg: Hvad er DeepSeek R-1??

Svar: DeepSeek R-1 er en AI-assistent, der er udviklet af det kinesiske firma DeepSeek.

Den er designet til at give svar og hjælp om en række forskellige emner, herunder men ikke begrænset til matematik, programmering, naturlig sprogbehandling osv. Hvis du har spørgsmål eller brug for hjælp, er du velkommen til at spørge mig!

Fantastisk.

Den er hurtig og fungerer, selv når jeg kobler min bærbare computer fra Wi-Fi-netværket. Bemærk, at den ikke kan få adgang til internettet, selv om du er forbundet til det.

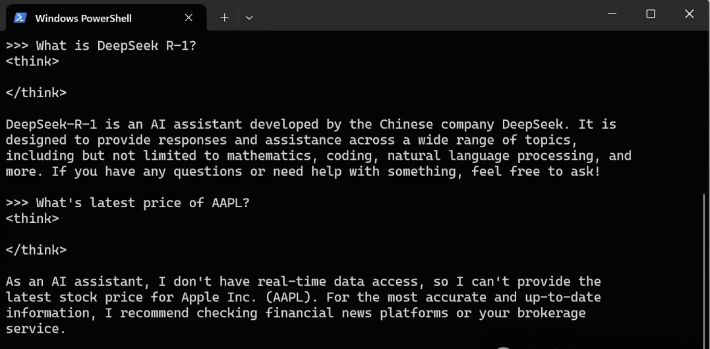

Tip: Hvad er den seneste aktiekurs for AAPL?

Svar: Som AI-assistent kan jeg ikke få adgang til realtidsdata og kan derfor ikke give den seneste aktiekurs for Apple Inc (AAPL).

For at få de mest nøjagtige og opdaterede oplysninger foreslår jeg, at du tjekker finansielle nyhedsplatforme eller din mæglervirksomhed:

Kør LLM'er lokalt, herunder LLaMA2, Phi 4, Mistral og GemmaGiv brugerne mulighed for at oprette og dele deres egne LLM'erPakkér modelvægte, konfigurationer og data i en enkelt pakkeOptimer indstillinger og konfigurationsdetaljer, herunder GPU-brug.

Krav til GPU og hukommelse

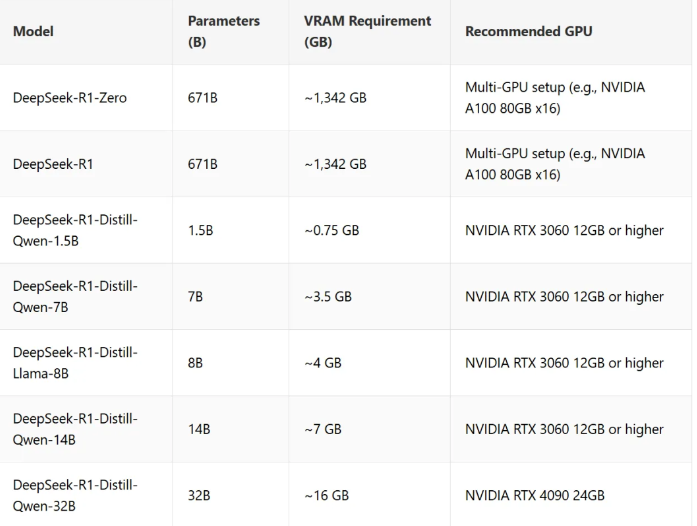

Hukommelseskravene til DeepSeek-R1 afhænger af faktorer som modellens størrelse, antallet af parametre og kvantificeringsteknikken.

Her er en detaljeret oversigt over hukommelseskravene til DeepSeek-R1 og dens reducerede model samt de anbefalede GPU'er:

Vigtig bemærkning om brug af hukommelse:

Distribueret GPU-opsætning til store modeller: DeepSeek-R1-Zero og DeepSeek-R1 kræver en masse grafikhukommelse og derfor en distribueret GPU-konfiguration (f.eks. NVIDIA A100 eller H100 i en multi-GPU-opsætning) for at opnå optimal ydeevne.

Lite-modellerne er optimeret til at køre på en enkelt GPU med lavere krav til grafikhukommelse, startende ved 0,7 GB.

Yderligere brug af hukommelse: Aktivering, buffere og batchopgaver kan forbruge ekstra hukommelse.

Hvorfor køre lokalt?

DeepSeeks webchatbot og mobilapp er gratis og meget praktisk. Du behøver ikke at foretage nogen opsætning, og funktioner som DeepThink og websøgning er indbygget.

Det kan dog være en bedre løsning at køre det lokalt af følgende grunde

Privatlivets fred

Når du bruger web- eller app-versionen, sendes dine forespørgsler og eventuelle vedhæftede filer til DeepSeeks servere til behandling. Hvad der sker med disse data, ved vi ikke. Ved at køre modellen lokalt sikres det, at dine data forbliver på din computer, hvilket giver dig fuld kontrol over dit privatliv.

Offline adgang

At køre modellen lokalt betyder, at du ikke har brug for en internetforbindelse.

Hvis du er ude at rejse, støder på ustabilt wi-fi eller bare foretrækker at arbejde offline, kan du med den lokale opsætning bruge DeepSeek når som helst og hvor som helst.

Fremtidssikret

I øjeblikket er DeepSeeks tjenester gratis, men det vil sandsynligvis ikke vare evigt. På et tidspunkt kan det blive nødvendigt at tjene penge på dem, og der kan komme brugsrestriktioner eller abonnementsgebyrer. Med den lokale model kan du helt undgå disse begrænsninger.

Fleksibel

Med den lokale version er du ikke begrænset af standardindstillinger. Vil du finjustere modellen?

Integrere det med andre værktøjer? Byg en brugerdefineret grænseflade? DeepSeek R1's open source-karakter giver dig uendelige muligheder.

Sammenfatning

I øjeblikket er det stadig uklart, hvordan DeepSeek håndterer brugerdata.

Hvis du er ligeglad med databeskyttelse, kan det være et bedre valg at bruge web- eller mobilapps. De er nemmere at bruge og tilbyder funktioner som DeepThink og websøgning.

Men hvis du bekymrer dig om, hvor dine data ender, er den lokale model et godt alternativ at overveje.

DeepSeek-modellen er designet til at køre godt, selv på hardware, der ikke er særlig kraftig.

Mens større modeller som DeepSeek-R1-Zero kræver en distribueret GPU-opsætning, gør lite-versionen det muligt at køre problemfrit på en enkelt GPU med lavere hukommelseskrav.