Klíčové informace

🔹 Jednotná architektura transformátoru: Jediný model zvládá jak porozumění obrazu a generování, čímž se eliminuje potřeba samostatných systémů.

🔹 Škálovatelný a otevřený zdrojový kód: K dispozici v 1B a 7B parametrické verze (s licencí MIT), optimalizované pro různé aplikace a komerční použití.

🔹 Nejmodernější výkon: V benchmarcích jako GenEval a DPG-Bench překonává DALL-E 3 a Stable Diffusion od OpenAI.

🔹 Zjednodušené nasazení: Zjednodušená architektura snižuje náklady na školení/interference při zachování flexibility.

Odkazy na modely

- Janus-Pro-7B: HuggingFace

- Janus-Pro-1B: HuggingFace

- GitHub: Kód a dokumenty

Proč Janus-Pro vyniká

1. Dvě superschopnosti v jednom modelu

- Pochopení režimu: Používá SigLIP-L ("superbrýle") k analýze obrázků (až 384 × 384) a textu.

- Režim generování: Pákové efekty Rektifikovaný tok + SDXL-VAE ("kouzelný štětec") k vytváření vysoce kvalitních snímků.

2. Mozková kapacita a trénink

- Základní LLM: Postaven na výkonném jazykovém modelu DeepSeek (1,5B/7B parametrů), který vyniká kontextovým uvažováním.

- Školící potrubí: Předtrénování na rozsáhlých souborech dat → doladění pod dohledem → optimalizace EMA pro dosažení špičkového výkonu.

3. Proč transformátor s nadměrnou difuzí?

- Všestrannost úkolů: Upřednostňuje jednotné porozumění + generování, zatímco difuzní modely se zaměřují výhradně na kvalitu obrazu.

- Efektivita: Autoregresní generování (jednokrokové) vs. iterativní denoizace difúze (např. 20 kroků u stabilní difúze).

- Nákladová efektivita: Jediná páteřní síť Transformer zjednodušuje školení a nasazení.

Dominance benchmarku

📊 Multimodální porozumění

Janus-Pro-7B překonává specializované modely (např. LLaVA) ve čtyřech klíčových srovnávacích testech a plynule se škáluje s velikostí parametrů.

🎨 Generování převodu textu na obrázek

- GenEval: Odpovídá SDXL a DALL-E 3.

- DPG-Bench: 84.2% přesnost (Janus-Pro-7B), čímž překonává všechny konkurenty.

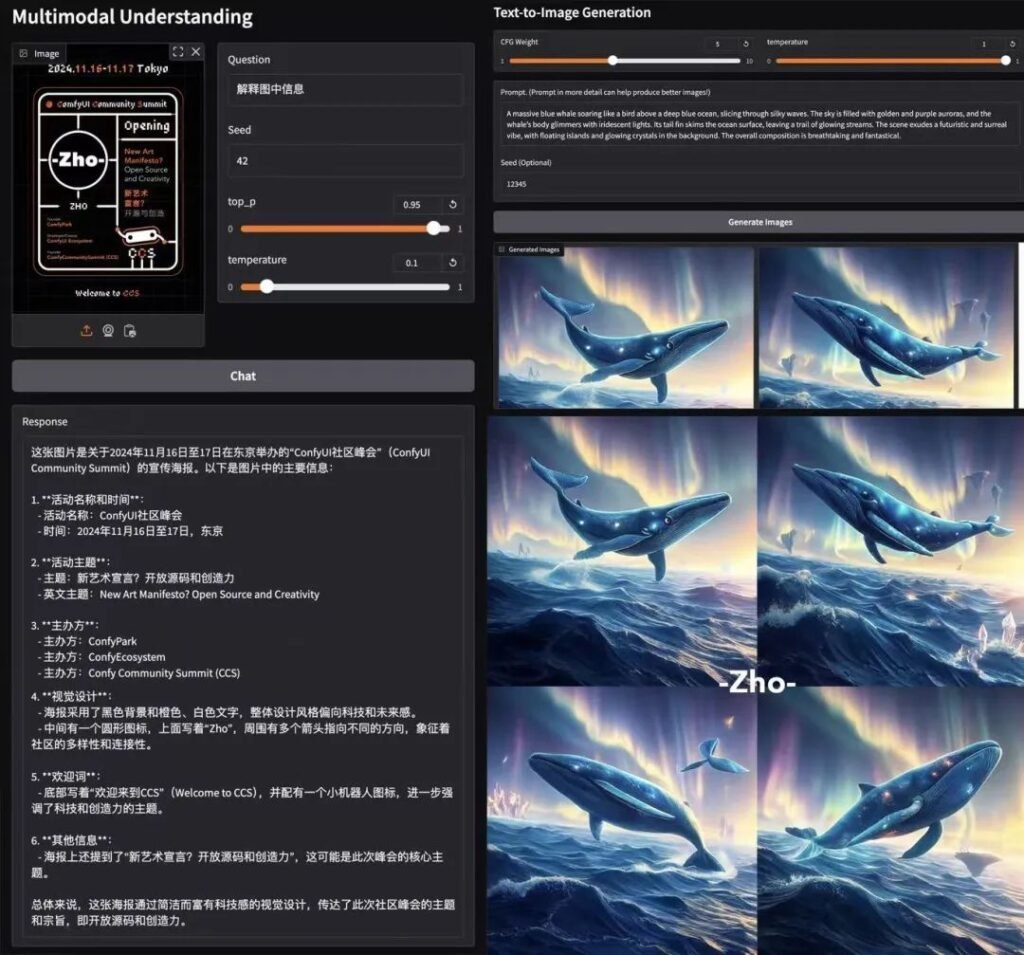

Testování v reálném prostředí

- Rychlost: ~15 sekund/obraz (L4 GPU, 22 GB VRAM).

- Kvalita: Pevné dodržování rychlosti, i když drobné detaily je třeba upřesnit.

- Demo Colab: Vyzkoušejte Janus-Pro-7B (Vyžaduje se úroveň Pro).

Technické členění

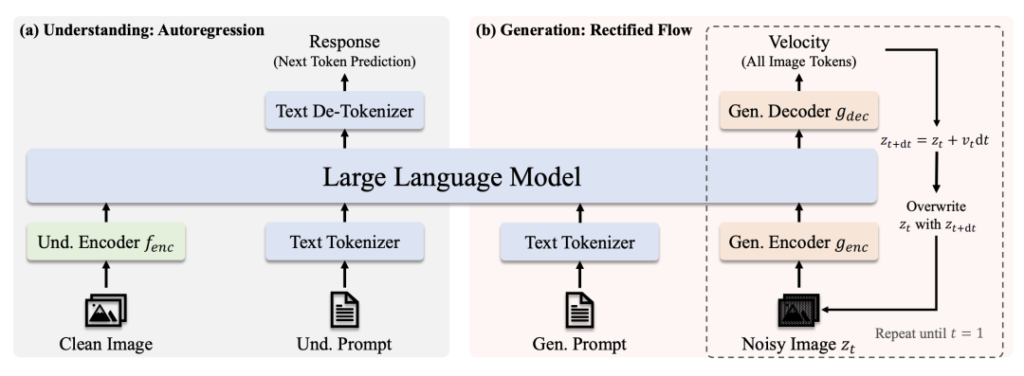

Architektura

- Pochopení cesty: Čistý obraz → SigLIP-L kodér → LLM → Textová odpověď.

- Generační cesta: Šumový obraz → Dekodér s usměrněným tokem + LLM → Iterativní denoising.

Klíčové inovace

- Oddělené vizuální kódování: Oddělené cesty pro pochopení/vygenerování zabraňují "konfliktu rolí" v modulech vidění.

- Sdílené jádro transformátoru: Umožňuje přenos znalostí napříč úkoly (např. učení se pojmu "kočka" pomáhá při rozpoznávání i kreslení).

Komunita Buzz

AK (výzkumný pracovník v oblasti umělé inteligence): "Jednoduchost a flexibilita systému Janus-Pro z něj dělají hlavního kandidáta pro multimodální systémy nové generace. Oddělením zrakových cest při zachování jednotného transformátoru vyvažuje specializaci s generalizací - což je vzácný výkon."

Proč je licence MIT důležitá

- Freedom: Používejte, upravujte a distribuujte komerčně s minimálními omezeními.

- Transparentnost: Úplný přístup ke kódu urychluje vylepšení řízená komunitou.

Závěrečné převzetí

Model Janus-Pro společnosti DeepSeek není jen dalším modelem umělé inteligence - je to změna paradigmatu. Sjednocením porozumění a generování pod jednou střechou otevírá dveře chytřejším kreativním nástrojům, aplikacím v reálném čase a nákladově efektivnímu nasazení. Díky přístupu k otevřenému zdrojovému kódu a licenci MIT by mohl být katalyzátorem další vlny multimodálních inovací. 🚀

Pro vývojáře: Podívejte se na Uzly ComfyUI a připojte se k experimentální vlně!

tento příspěvek je sponzorován: